1. 简介

AVFoundation用于播放、处理音视频。可以通过结构图看到AVFoundation位于UIKit之下,很好理解AVFoundation并不提供用户界面,你可以自己自己构建用户界面来控制媒体的播放处理等功能。 但是苹果更推荐使用AVKit来构建用户界面

2. AVKit

AVKit构建在 AVFoundation之上,可以简单的理解使用AVKit能够及其方便的使用系统为你提供的音视频播放界面。使用AVKit构建的播放界面能够随着苹果系统的更新自动更新。

iOS9之前,你可以使用MPMoviePlayerViewController做一个简单的视频播放器,但是在iOS9这个类已经被弃用了。 取而代之的是AVPlayerViewController

2. 创建一个简单的视频播放App

1.新建工程, 命名为AVBasicPlayback,在Info.plist中添加

<key>NSAppTransportSecurity</key>

<key>NSExceptionDomains</key>

<key>devimages-cdn.apple.com</key>

<key>NSExceptionRequiresForwardSecrecy</key>

<false/>

</dict>

</dict>

</dict>

目的是确保App能够从devimages-cdn.apple.com加载视频资源

importAVFoundation

funcapplication(_application:UIApplication,didFinishLaunchingWithOptionslaunchOptions:[UIApplication.LaunchOptionsKey:Any]?)->Bool{

letaudioSession=AVAudioSession.sharedInstance()

do{

tryaudioSession.setCategory(.playback)

}catch {

print(“Setting category to AVAudioSessionCategoryPlayback failed.”)

}

}

importUIKit

classViewController:UIViewController{

letplayButton=UIButton(type:.system)

setupUI()

}

//1.这是一个HTTP Live Streaming流媒体链接,用于测试

guardleturl=URL(string:”https://devimages-cdn.apple.com/samplecode/avfoundationMedia/AVFoundationQueuePlayer_HLS2/master.m3u8″)else{

}

//3. 创建AVPlayerViewController,并设置player

letcontroller=AVPlayerViewController()

//4. 显示

present(controller,animated:true){

}

}

playButton.setTitle(“Play Video”,for:.normal)

playButton.addTarget(self,action:#selector(playVideo),for:.touchUpInside)

playButton.translatesAutoresizingMaskIntoConstraints=false

playButton.centerXAnchor.constraint(equalTo:view.centerXAnchor).isActive=true

playButton.centerYAnchor.constraint(equalTo:view.centerYAnchor).isActive=true

}

}

4. 运行App,点击播放。 恭喜你,已经成功完成了一个简单的视频播放App。

如果你视频加载不出来,检查一下第一步是否完成。另外还可以在网上寻找一些HLS测试的URL或者本地资源对代码中URL的进行替换

3. 音频设置

上一步我们在AppDelegate中使用到了AVAudioSession类

AVAudioSession是App和操作系统的音频中介。我们使用这个类进行一些音频设置,无需进行复杂的配置, 系统就能为用户提供良好的音频体验

如果想要调整默认设置,我们就需要配置AVAudioSession,在上一步中我们设置了.playback。

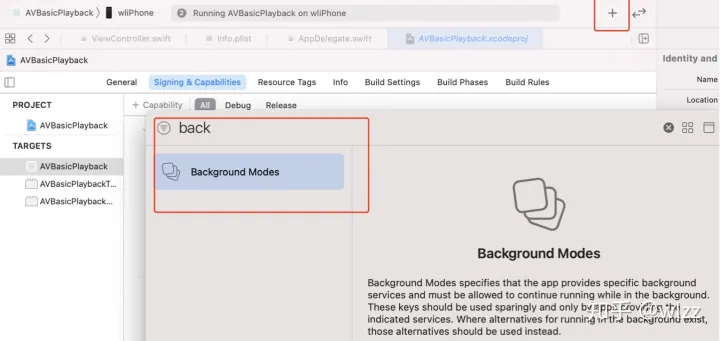

设置为.playback 能够使我们app具有后台音频播放的能力(需要配置),当你的App开始播放音频的时候系统会停止播放其他App的音频。想要了解更多可以仔细阅读下面这个链接

4.深入了解AVFoundation

4.1AVAsset

我们使用AVFoundation主要目的就是对音视频进行处理, AVAsset就是这些媒体数据的抽象模型。 我们可以用本地的视频,例如一个mp4格式的视频, 或则通过一个HLS流媒体连接来构建一个AVAsset。 使用AVAsset能够使得我们不用关心视频的格式,编解码这些复杂的工作。可以简单的理解AVAsset提供给我们一套统一的接口用于处理不同格式的视频。

AVAsset中包含了多个AVAssetTrack。 AVAssetTrack是媒体流的抽象,例如音轨、视频轨道、字幕轨道。

在大部分情况下,你只会对轨道的一部分进行处理,而不是处理整个轨道,所以AVAsset提供一些方法让你获取 AVAssetTrack的子集

4.2创建AVAsset

leturl:URL=””

实际上AVAsset是一个抽象类,你实际创建的是一个AVURLAsset实例。 你也可以通过AVURLAsset直接创建实例, 你还可以进行一些设置,比如我们不想在使用蜂窝网络的时候加载视频。

//不允许在蜂窝网络下加载

letoptions=[AVURLAssetAllowsCellularAccessKey:false]

letasset=AVURLAsset(url:url,options:options)

新建 AVAsset 的时候系统不会自动加载数据,直到需要对其进行操作(播放,导出等)。在新建AVAsset后,不要直接读取它的属性,这可能会造成阻塞。 比如你想知道一个视频是否可以播放,需要调用loadValuesAsynchronously异步加载playable

leturl=Bundle.main.url(forResource:”sample-mp4-file“,withExtension:”mp4″)!

letasset=AVAsset(url:url)

letplayableKey=”playable”

letstatus=asset.statusOfValue(forKey:playableKey,error:nil)

}

//asset.isPlayable

asset.loadValuesAsynchronously(forKeys:[playableKey]){

letstatus=asset.statusOfValue(forKey:playableKey,error:&error)

print(“loaded, playable:(asset.isPlayable)”)

}

}

}

4.3处理元数据

AVAsset是媒体对象的抽象类 , AVMetadataItem是元数据的抽象类,提供了媒体文件关联的一些元数据,例如电影的标题或专辑的插图。你可以通过AVMetadataItem获取这些信息

AVFoundation把这些元数据分别关联到Format-specific key spaces 和Common key space. 你可以获取并处理这些数据。

leturl=Bundle.main.url(forResource:”sample-mp4-file“,withExtension:”mp4″)!

letasset=AVAsset(url:url)

letformatsKey=”availableMetadataFormats”

letcommonMetadataKey=”commonMetadata“

asset.loadValuesAsynchronously(forKeys:[formatsKey,commonMetadataKey]){

//3 获取Format-specific key spaces下的元数据

letformatsStatus=asset.statusOfValue(forKey:formatsKey,error:&error)

forformatinasset.availableMetadataFormats{

letmetaData=asset.metadata(forFormat:format)

}

}

letcommonStatus=asset.statusOfValue(forKey:commonMetadataKey,error:&error)

letmetadata=asset.commonMetadata

//5 通过Identifier获取AVMetadataItem

lettitleID:AVMetadataIdentifier=.commonIdentifierTitle

lettitleItems=AVMetadataItem.metadataItems(from:metadata,filteredByIdentifier:titleID)

}

}

}

}

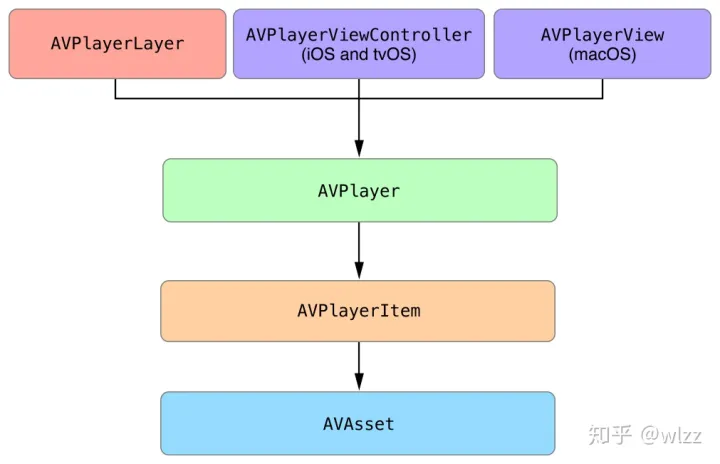

4.4视频播放

前面我们对AVAsset已经有了一个了解,它代表了一个媒体资源。如果你想播放视频,你还需要用到其他对象。

1. AVPlayer

AVPlayer 媒体播放的核心类,用它对媒体对象进行管理。

AVPlayer一次只能播放一个视频,你可以使用AVQueuePlayer (AVPlayer的子类)来创建播放队列,播放多个视频

2.AVPlayerItem

AVAsset只是对媒体对象的静态建模。当你播放它们的时候, 媒体对象会有播放时间等状态,所以你需要使用AVPlayerItem 对这些数据进行建模。 你可以使用AVPlayerItem控制播放时间等。

3.AVKit 和 AVPlayerLayer

AVPlayer和AVPlayerItem不负责视频的显示。

你可以使用AVKit下的AVPlayerController或者AVPlayerLayer来显示显示视频。 AVPlayerController 自带播放界面, AVPlayerLayer需要你自己创建控件控制视频的播放。

// 1 获取URL

leturl=Bundle.main.url(forResource:”sample-mp4-file“,withExtension:”mp4″)!

// 2 创建AVAsset对象

letasset=AVAsset(url:url)

// 3 创建AVPlayerItem对象

letplayerItem=AVPlayerItem(asset:asset)

// 4 创建AVPlayer

letplayer=AVPlayer(playerItem:playerItem)

// 5 关联

letcontroller=AVPlayerViewController()

controller.player=player

}

4.5监听播放状态

其中AVPlayerItem 的status是一个非常重要的属性,我们可以通过这个属性判断视频是否可以进行播放

leturl:URL=Bundle.main.url(forResource:”sample-mp4-file“,withExtension:”mp4″)!

varplayer:AVPlayer!

varplayerItem:AVPlayerItem!

// Key-value observing context

// 需要加载的属性

letrequiredAssetKeys=[

“playable”,

]

// 1.创建AVAsset

asset=AVAsset(url:url)

// 2.创建AVPlayerItem,并且在readyToPlay状态之前加载所有需要的属性

playerItem=AVPlayerItem(asset:asset,

automaticallyLoadedAssetKeys:requiredAssetKeys)

// 3.KVO

forKeyPath:#keyPath(AVPlayerItem.status),

context:&playerItemContext)

// 4.创建AVPlayer

player=AVPlayer(playerItem:playerItem)

}

overridefuncobserveValue(forKeyPathkeyPath:String?,

ofobject:Any?,

change:[NSKeyValueChangeKey:Any]?,

context:UnsafeMutableRawPointer?){

// 只对playerItemContext进行处理

guardcontext==&playerItemContextelse{

super.observeValue(forKeyPath:keyPath,

of:object,

}

ifkeyPath==#keyPath(AVPlayerItem.status){

letstatus:AVPlayerItem.Status

ifletstatusNumber=change?[.newKey]as?NSNumber{

status=AVPlayerItem.Status(rawValue:statusNumber.intValue)!

}else{

status=.unknown

}

switchstatus{

}

}

}

4.5基于时间对视频进行操作

首先我们了解一下CMTime

publicvartimescale:CMTimeScale

}

其中比较重要的是value和timescale 。当我们构建一个CMTime的时候,我们需要知道视频的帧率。 计算CMTime的时候,我们只要把 value作为分子和timescale作为分母,就能计算出时长。

// 60/60 = 1秒

letoneSecond=CMTime(value:60,timescale:60)

// 1/4 = 0.25秒

letquarterSecond=CMTime(value:1,timescale:4)

// 441000/44100 = 10秒

lettenSeconds=CMTime(value:441000,timescale:44100)

// 90/30 = 3秒

letcursor=CMTime(value:90,timescale:30)

如果你想对视频的播放时间进监听,首先肯定想到的是KVO,但KVO不不适合用来对时间进行监听,因为时间是连续变化的(想象一下KVO一直回调)。

-

周期监测

funcaddPeriodicTimeObserver(){

// 每半秒回调一次

lettimeScale=CMTimeScale(NSEC_PER_SEC)

lettime=CMTime(seconds:0.5,preferredTimescale:timeScale)

timeObserverToken=player.addPeriodicTimeObserver(forInterval:time,

print(“(self.player.currentTime())”)

}

}

funcremovePeriodicTimeObserver(){

iflettimeObserverToken=timeObserverToken{

player.removeTimeObserver(timeObserverToken)

}

}

2. 边界监测

funcaddBoundaryTimeObserver(){

// 视频每播放1/4我们进行一次回调

letinterval=CMTimeMultiplyByFloat64(asset.duration,multiplier:0.25)

// 添加时间节点

whilecurrentTime<asset.duration{

currentTime=currentTime+interval

times.append(NSValue(time:currentTime))

}

timeObserverToken=player.addBoundaryTimeObserver(forTimes:times,

print(self.player.currentTime())

}

}

funcremoveBoundaryTimeObserver(){

iflettimeObserverToken=timeObserverToken{

player.removeTimeObserver(timeObserverToken)

self.timeObserverToken=nil

}

}

调整视频播放时间

如果你想快速调整视频到某个时间点

funcseekToTime(){

// 2分钟

lettime=CMTime(value:120,timescale:1)

player.seek(to:time)

}

如果你想非常精确的调整视频到某个时间节点,使用seekToTime:toleranceBefore:toleranceAfter:方法。

// 10秒的第一帧。 这里不用觉得CMTime计算的时间不对,视频的帧率由视频本身决定,preferredTimescale设置一个极大的值就可以了

letseekTime=CMTime(seconds:10,preferredTimescale:Int32(NSEC_PER_SEC))

// 设置tolerance 为CMTime.zero 不允许有误差

player.seek(to:seekTime,toleranceBefore:CMTime.zero,toleranceAfter:CMTime.zero)

}

原文https://zhuanlan.zhihu.com/p/335087516

★文末名片可以免费领取音视频开发学习资料,内容包括(FFmpeg ,webRTC ,rtmp ,hls ,rtsp ,ffplay ,srs)以及音视频学习路线图等等。

见下方!↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓

原文地址:https://blog.csdn.net/yinshipin007/article/details/129768651

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_19473.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!