OpenAI高管Mira Murati周三告诉员工,一封关于AI取得突破的信件促使董事会采取了解雇行动。一位消息人士透露,OpenAI在Q*项目上取得了进展,内部人士认为这可能是OpenAI在超级智能领域的突破。这名消息人士称,虽然Q*的数学成绩只是小学生的水平,但在测试中取得优异成绩让研究人员对它未来的成功非常乐观

有人说:奥特曼不用斯派修姆光线把解雇他的OpenAI给消灭吗?

人类终将打开AGI(Artificial General Intelligence)通用人工智能的魔盒。

1. scaling up 是接近 AGI 的正确方向,虽然不一定是最佳方向。

2. 架构层面上,相信肯定有比 transformer 更好架构,但现在大家已经在这个架构上做了很多工作了,也能用。

3. 同行Meta 没有做到位,Llama 还是差的挺多的,远远没有做好, meta 没有train 好。

4. 学术界大模型研究与工业界差距大,一个问题是 gpu 算力集群不够,学术界不能做pretrain,很难下决心 all in 某个研究方向,另一个问题是学术界研究不能在生产中验证

6. 这一年来 gpt 底层model 并没换,只不过人的错觉认为变弱了

7. 很多开源社区都是重复的造轮子,所以 OpenAI内部 就自己做掉这部分轮子

8. RLHF(基于人类反馈(Human Feedback)对语言模型进行强化学习(Reinforcement Learning))不一定是AGI 的必经路径,因为RLHF是hf部分决定了上限,怎么会通往 AGI?

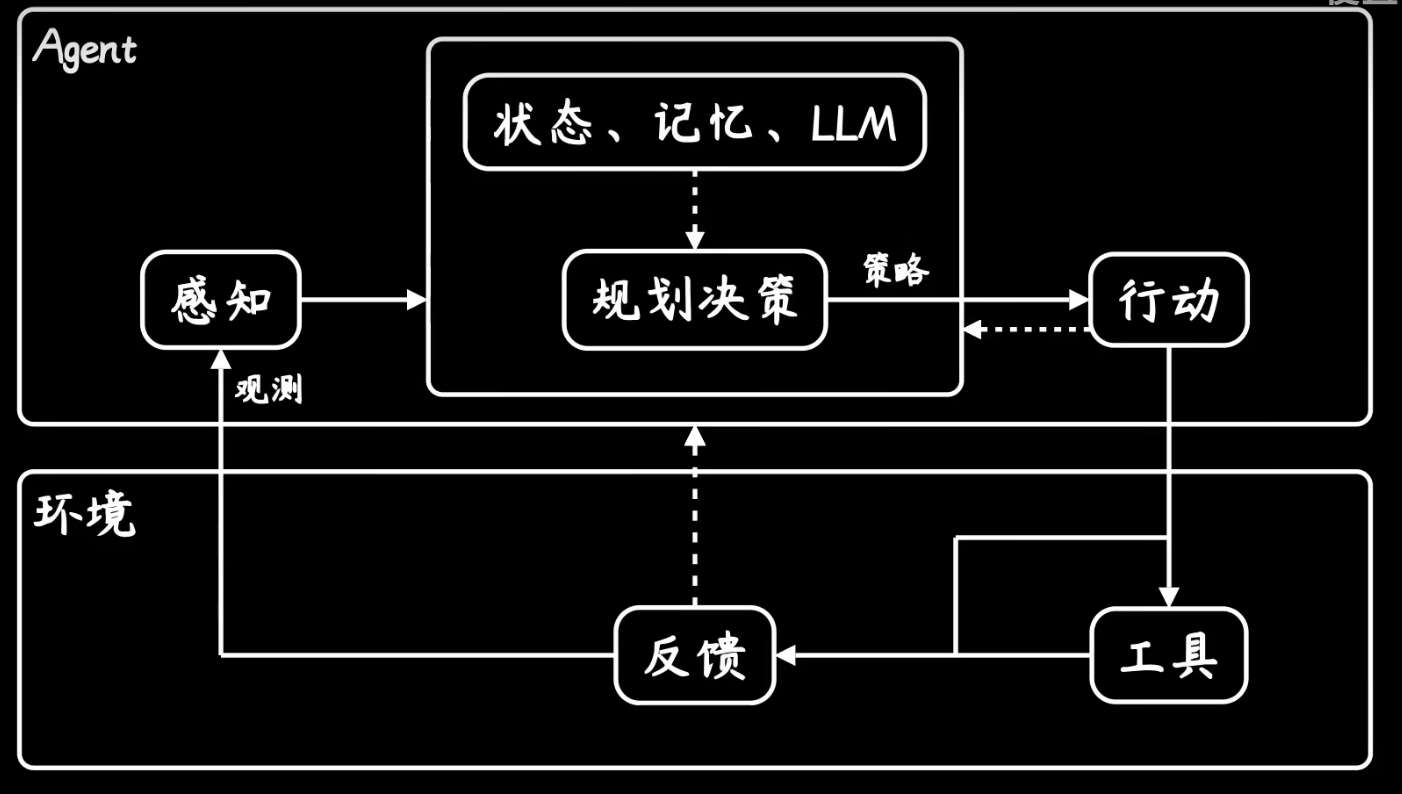

9. 但RL是正确的,看好 multi agent,类比阿法狗,可以左脚踩右脚把能力提上去。

10. GPTs是为了方便开发者而零时发布的一个产品,这不是OpenAI公司的重点

原文地址:https://blog.csdn.net/qq_42672770/article/details/134660818

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_21652.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!