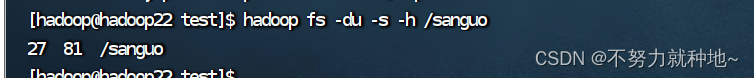

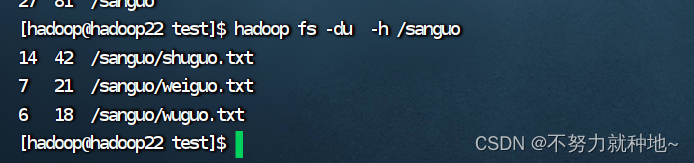

本文介绍: 副本数量记录在NameNode,不要设置超过节点数量的副本,设置超过节点数,最多也只是总节点数量的副本,不会超过DataNode节点数, 如果设置8个副本,如果DataNode节点数有8个,才会有8个副本。总结:命令太多不一一列举了,同centos系统一样,只是前面加了hadoop fs, 很容易记住。作用: 从本地上传hdfs系统 (本地文件被剪切走,不存在了)hadoop fs -help rm 查看rm命令作用。下面是查看文件夹每个文件的统计信息。hadoop fs 查看命令。81 副本*文件大小。

# hdfs前缀也是可以的。更推荐hadoop

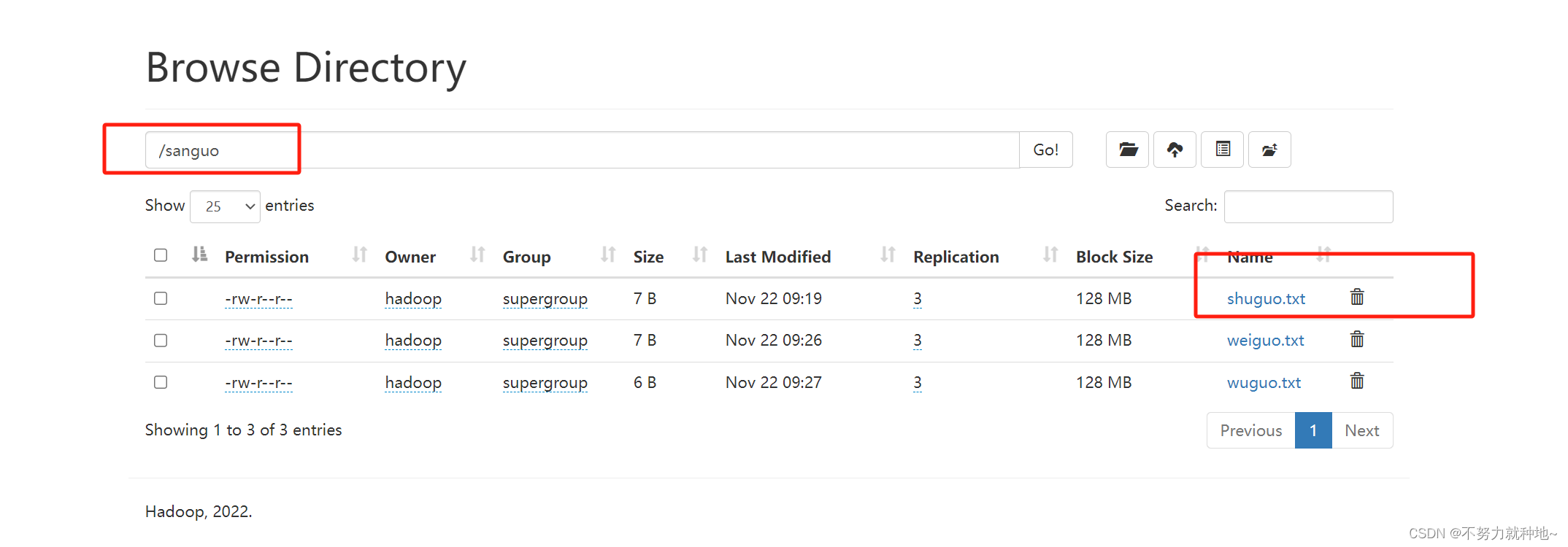

hadoop fs -mkdir /sanguo作用: 从本地上传hdfs系统 (本地文件被剪切走,不存在了)

命令:

# 新建文件

vi shuguo.txt

#进入后 输入一些文字,保存退出即可

#同shuguo.txt要在同目录下,输入命令

hadoop fs -moveFromLocal shuguo.txt /sanguo

#新增文件

vi weiguo.txt

# 输入一些文字,保存并退出

# 从本地复制一份文件,至hdfs文件系统

hadoop fs -copyFromLocal weiguo.txt /sanguo

# 同上相同,更推荐这种,更加简洁

hadoop fs -put weiguo.txt /sanguo

# 新建文件

vi liubei.txt

# 输入一些文字,保存并退出

#

hadoop fs -appendToFile liubei.txt /sanguo/shuguo.txt5. 从hdfs下载至本地:

# copy

hadoop fs -copyToLocal /sanguo/shuguo.txt ./

# 更推荐这种,简洁

# 下载

hadoop fs -get /sanguo/shuguo.txt ./6. ls命令:

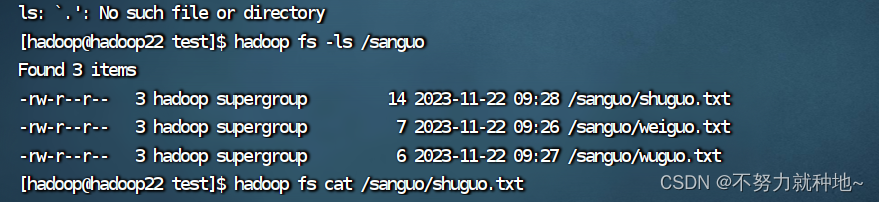

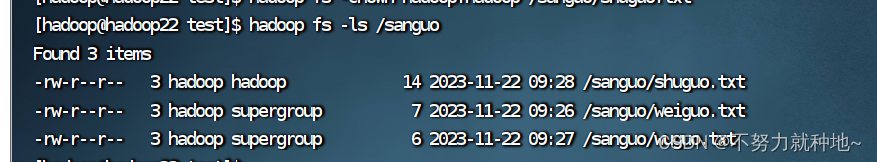

hadoop fs -ls /sanguo

7. cat命令:

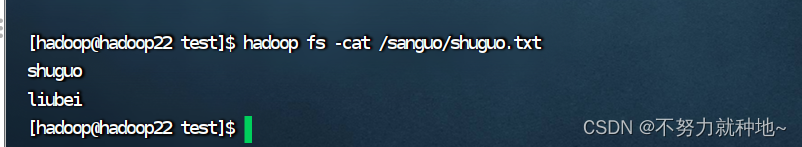

hadoop fs -cat /sanguo/shuguo.txt

hadoop fs -chown hadoop:hadoop /sanguo/shuguo.txt

9. cp 复制:

# 创建文件夹

hadoop fs -mkdir /jinguo

# 复制

hadoop fs -cp /sanguo/shuguo.txt /jinguo10. mv 移动:

hadoop fs -mv /sanguo/weiguo.txt /jinguohadoop fs -tail /sanguo/shuguo.txt# 删除文件

hadoop fs -rm /sanguo/shuguo.txt

# 递归删除文件夹

hadoop fs -rm -r /sanguohadoop fs -du -s -h /sanguo

hadoop fs -du -h /sanguo

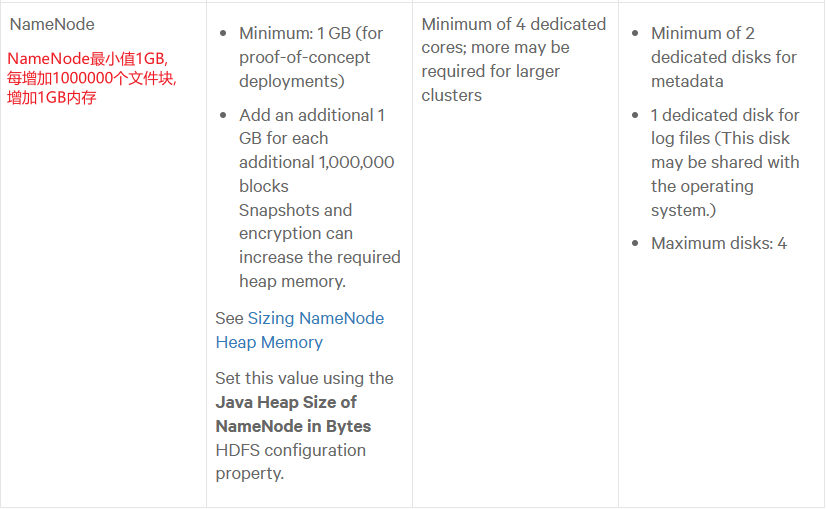

hadoop fs -setrep 2 /sanguo/shuguo.txt副本数量记录在NameNode,不要设置超过节点数量的副本,设置超过节点数,最多也只是总节点数量的副本,不会超过DataNode节点数, 如果设置8个副本,如果DataNode节点数有8个,才会有8个副本

总结:命令太多不一一列举了,同centos系统一样,只是前面加了hadoop fs, 很容易记住

原文地址:https://blog.csdn.net/qq_33919114/article/details/134546043

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_3230.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。