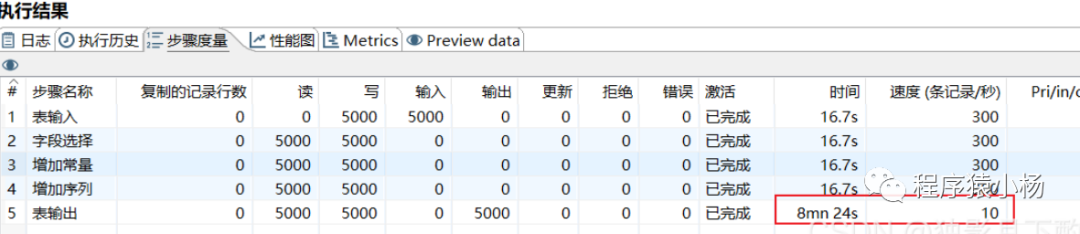

背景:在往mysql数据库中进行抽取清洗转换数据的时候,发现表的数据量大的时候,对表的读、写操作的速度很慢,并且是达到一定数据量以后速度会特别慢,数据量小的时候读的速度是很快。

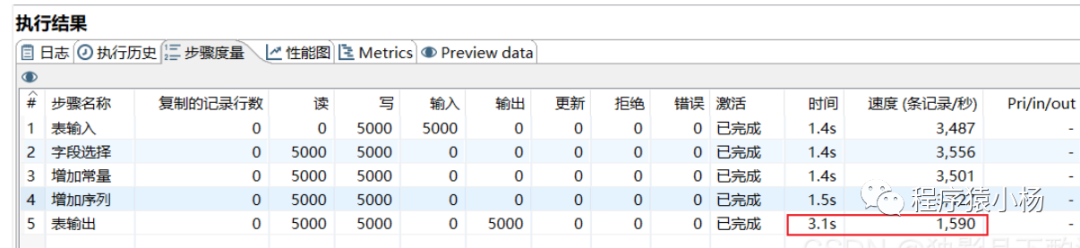

读写数据速度测试:5000条数据读写速度测试:8min24s 即 504s

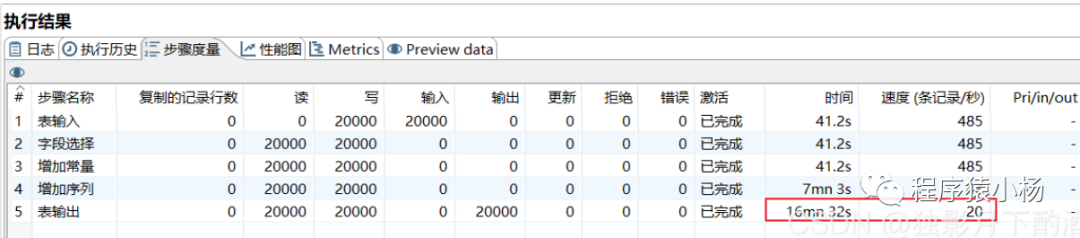

20000条数据读写速度测试: 16min32s 即 992s

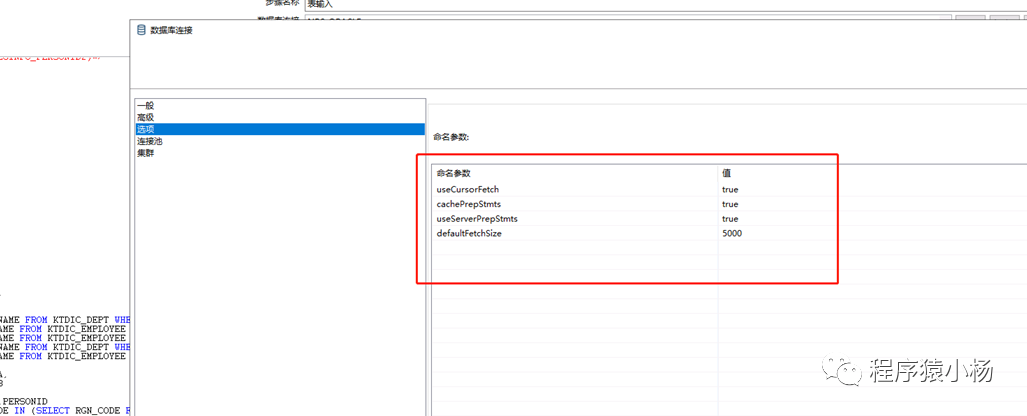

| 命名参数 | 值 | 参数说明 |

| useCompression | TRUE | |

| rewriteBatchedStatements | TRUE | 让数据库重排Insert语句,合并多条插入语句成为一条,提交插入效率 |

| useServerPrepStmts | FALSE | 让数据库重排Insert语句,合并多条插入语句成为一条,提交插入效率 |

改变后速度:

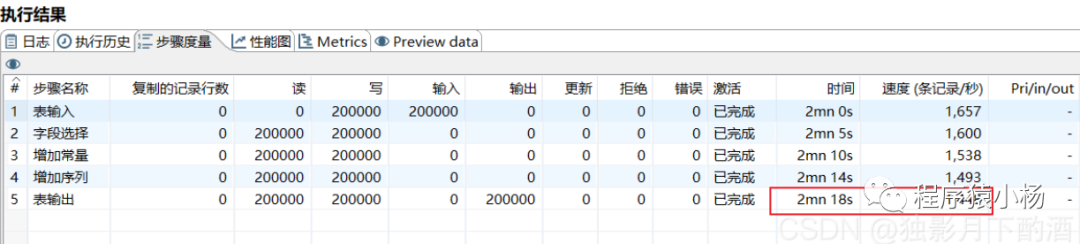

200000条数据读写速度测试: 2min18s 即138s

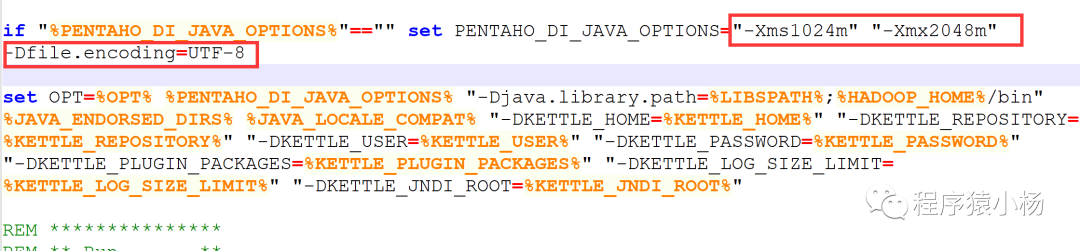

-Xmx1024m:设置JVM最大可用内存为1024M。-Xms512m:设置JVM初始内存为512m。此值可以设置与-Xmx相同,以避免每次垃圾回收完成后JVM重新分配内存。

必须注意:-Xmx必须小于等于系统内存的1/4,要不然会报错,-Xms不大于-Xmx。当系统内存为4G时-Xmx不能大于1G,当系统内存为8G时或更大时,java(JDK)版本必须是64位的才能识别出来,此时-Xmx可以为2G或更高。个人建议内存设置不要超出整个服务器内存的2/3。

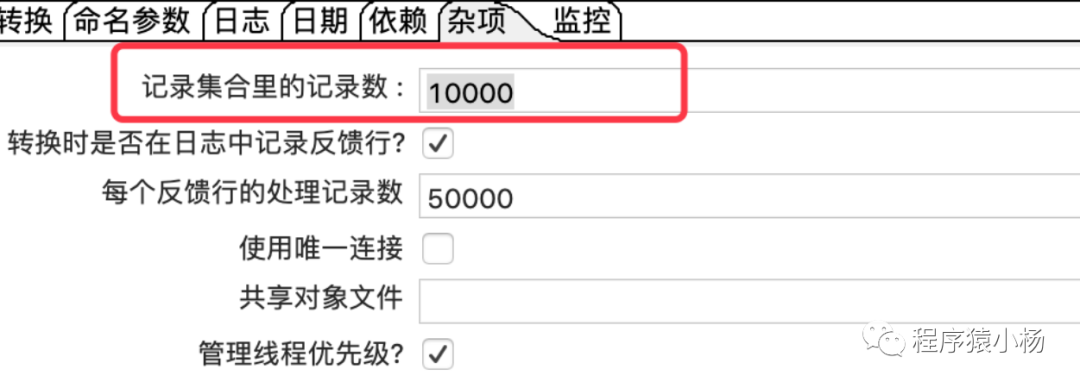

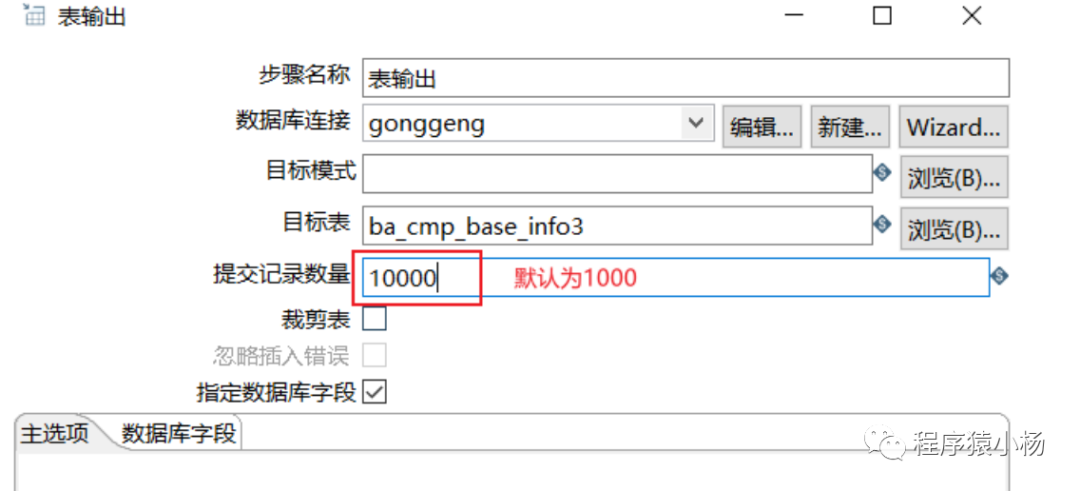

2、提交记录数量更改为10000,即每次提交10000条记录(前提是没有并发的设置,或错误后被插入/更新执行)

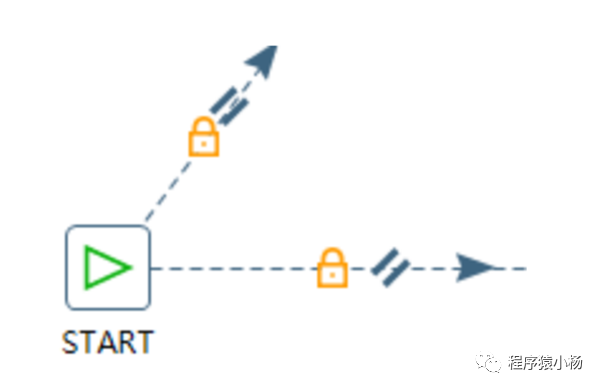

方法:start设置多个并发任务,鼠标右击start,选RUN Next Entries in Parallel

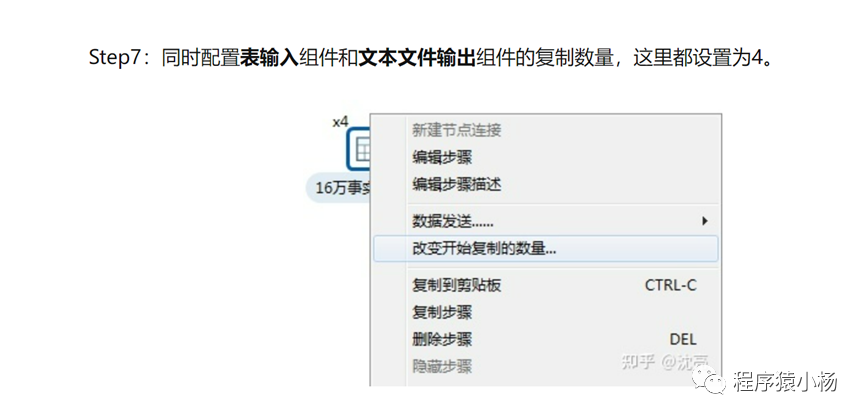

特别注意:在多线程”insert/update”场景中,如果更新的key并非唯一,则有可能产生死锁(多个线程一次更新同一行的数据),因此设置并发的时候最好关键字是主键或唯一字段,插入更新的提交数量建议设置为1。

1、增加读的操作

三、总结

1、检查连接数据库的驱动版本,要做到jar包的版本和数据库版本接近;

?autoReconnect=true&failOverReadOnly=false3、创建数据库连接的参数中必须加上以下三个参数:(用于增加数据写入速度)

useServerPrepStmts=falserewriteBatchedStatements=trueuseCompression=true

4、创建数据库连接,如果使用的连接池,必须设置maxIdl值较大:

5、必须根据kettle软件所在的硬件,修改spoon.bat(window)或spoon.sh(linux)的内存大小:

更多优秀文章,请扫码关注个人微信公众号或搜索“程序猿小杨”添加。

原文地址:https://blog.csdn.net/qq_35989920/article/details/130401215

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_33080.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!