爬虫是一种自动化程序,用于从互联网上获取数据。它能够模拟人类浏览网页的行为,访问网页并提取所需的信息。爬虫在很多领域都有广泛的应用,例如数据采集、信息监控、搜索引擎索引等。

import requests

# 设置要爬取的网页链接

url = "https://example.com"

# 发送请求,获取网页内容

response = requests.get(url)

content = response.text

# 打印网页内容

print(content)

在这个示例中,我们使用了requests库来发送GET请求并获取网页的内容。我们将目标网页的链接存储在url变量中,通过requests.get(url)发送请求并得到response响应对象。使用response.text可以获取网页的内容,最后通过print语句将网页内容打印出来。

请注意,在实际使用爬虫时,需要遵守相关网站的使用协议和法律法规,尊重网站的隐私政策和使用条款,避免对目标网站造成不必要的干扰或侵犯其合法权益。另外,为了提高爬虫的效率和稳定性,可能需要了解更多关于HTTP请求、网页解析和数据处理等方面的知识。

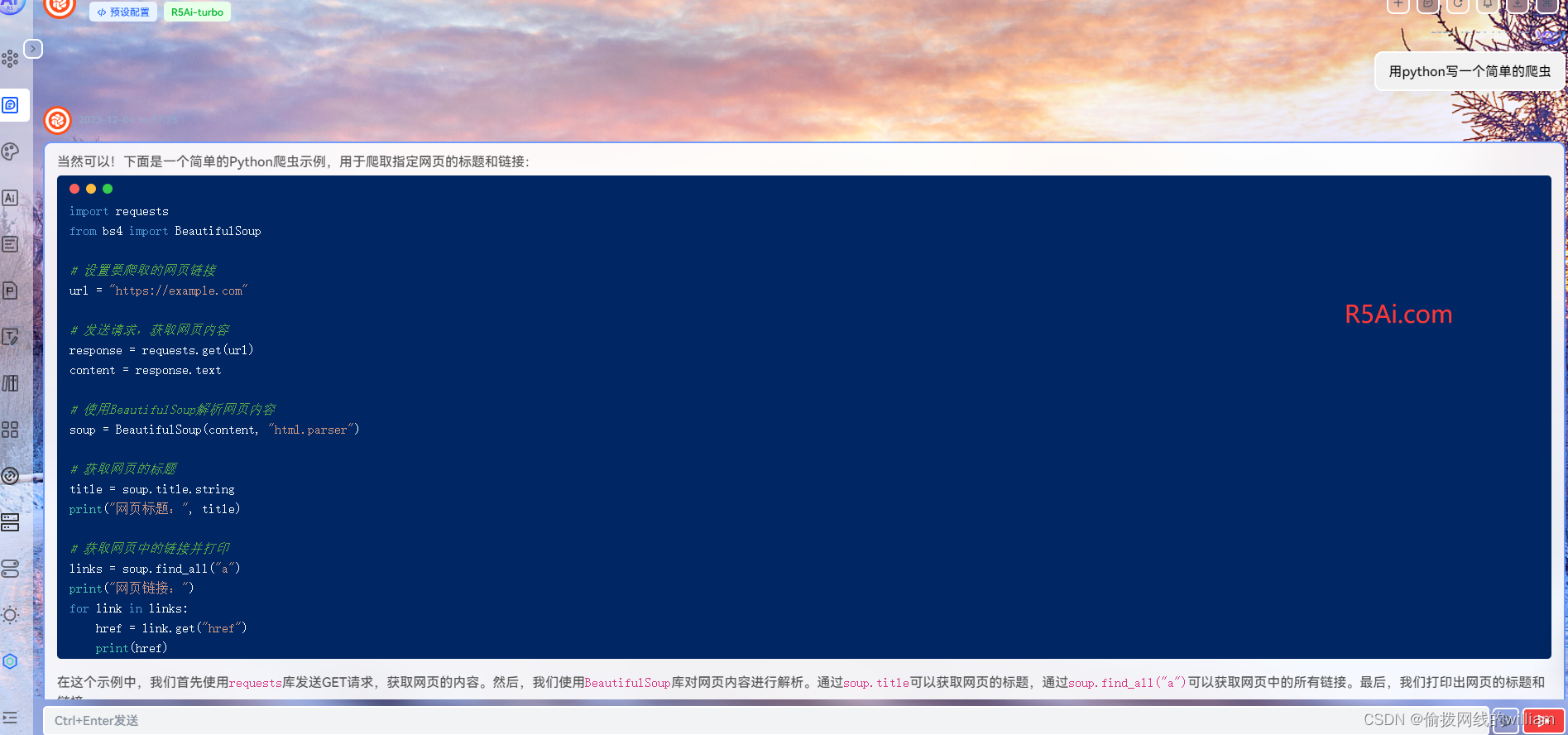

下面是一个简单的Python爬虫示例,用于爬取指定网页的标题和链接:

import requests

from bs4 import BeautifulSoup

# 设置要爬取的网页链接

url = "https://example.com"

# 发送请求,获取网页内容

response = requests.get(url)

content = response.text

# 使用BeautifulSoup解析网页内容

soup = BeautifulSoup(content, "html.parser")

# 获取网页的标题

title = soup.title.string

print("网页标题:", title)

# 获取网页中的链接并打印

links = soup.find_all("a")

print("网页链接:")

for link in links:

href = link.get("href")

print(href)

在这个示例中,我们首先使用requests库发送GET请求,获取网页的内容。然后,我们使用BeautifulSoup库对网页内容进行解析。通过soup.title可以获取网页的标题,通过soup.find_all(“a”)可以获取网页中的所有链接。最后,我们打印出网页的标题和链接。

请注意,爬取网页的行为需要遵守网站的使用规定和相关法律法规。在实际使用中,请确保您的爬虫行为合法,并且尊重网站的隐私政策和使用条款。

原文地址:https://blog.csdn.net/weixin_47059371/article/details/134784416

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_39816.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!