本文介绍: 注意,在实际的边的实现方式中,并不是以邻接矩阵来进行实现的,这是因为在图的更新中,用邻接矩阵进行更新所占用的时间开销相对大,二是因为领接矩阵占用的空间大(N方)。所以在实际实现中会采用2XN的存储结构,从而避免多余的存储开销。

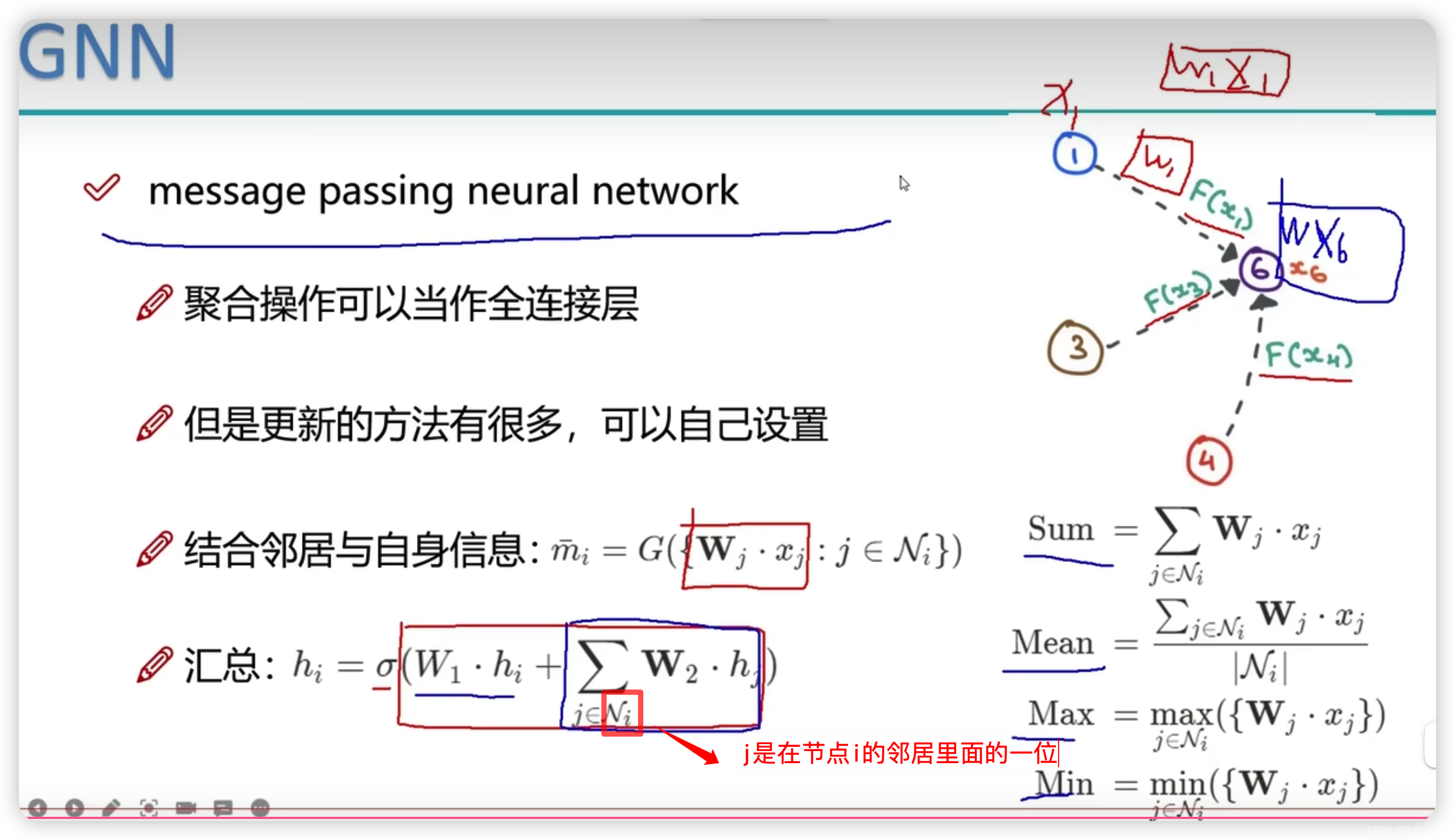

5.消息传递的计算方法

边的存放方式

注意,在实际的边的实现方式中,并不是以邻接矩阵来进行实现的,这是因为在图的更新中,用邻接矩阵进行更新所占用的时间开销相对大,二是因为领接矩阵占用的空间大(N方)。

所以在实际实现中会采用2XN的存储结构,从而避免多余的存储开销。

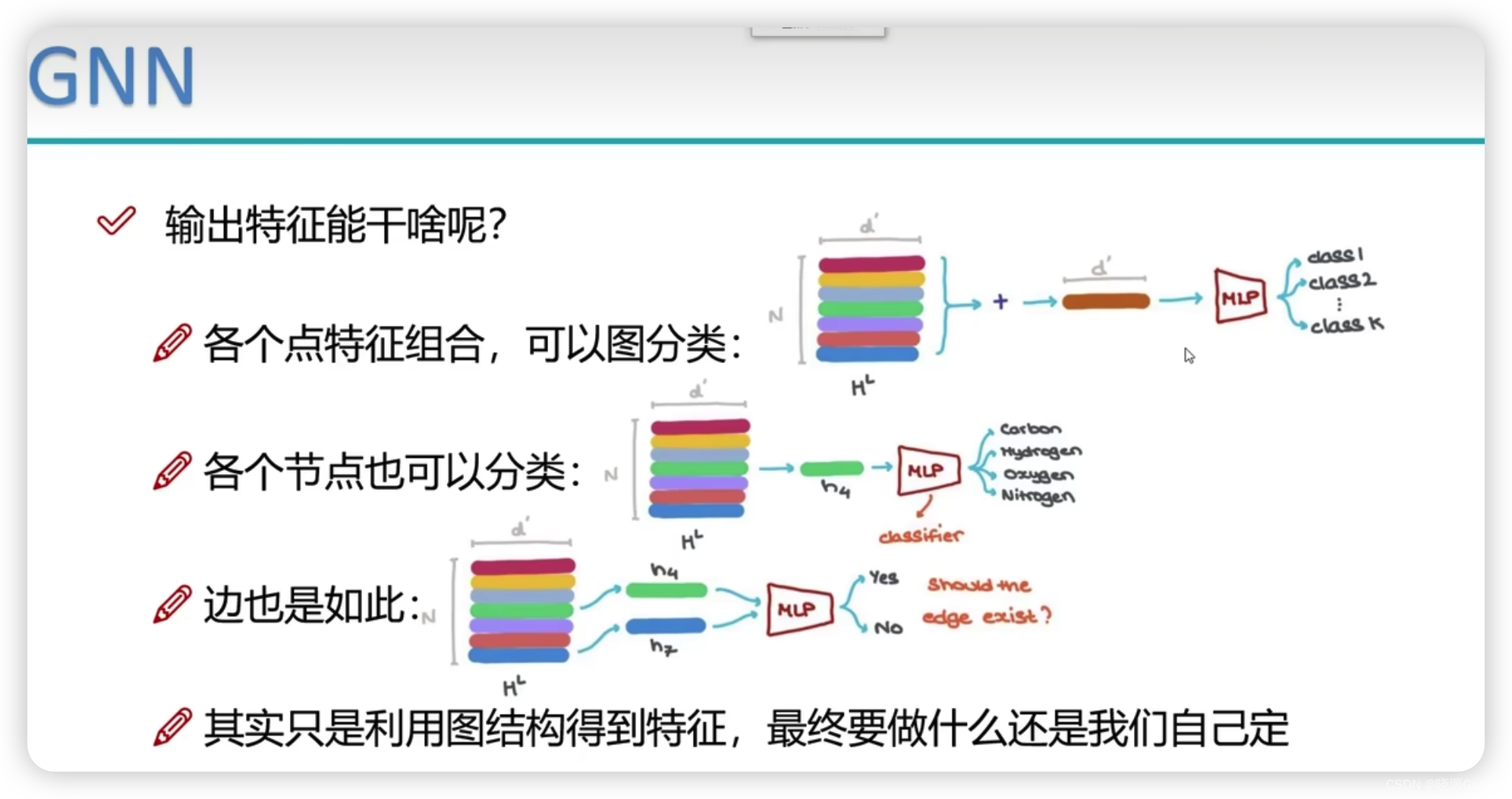

节点更新

在图神经网络中,某个节点的更新,不应该只关心自身的变化,还应该关心相邻节点与本节点的关系。

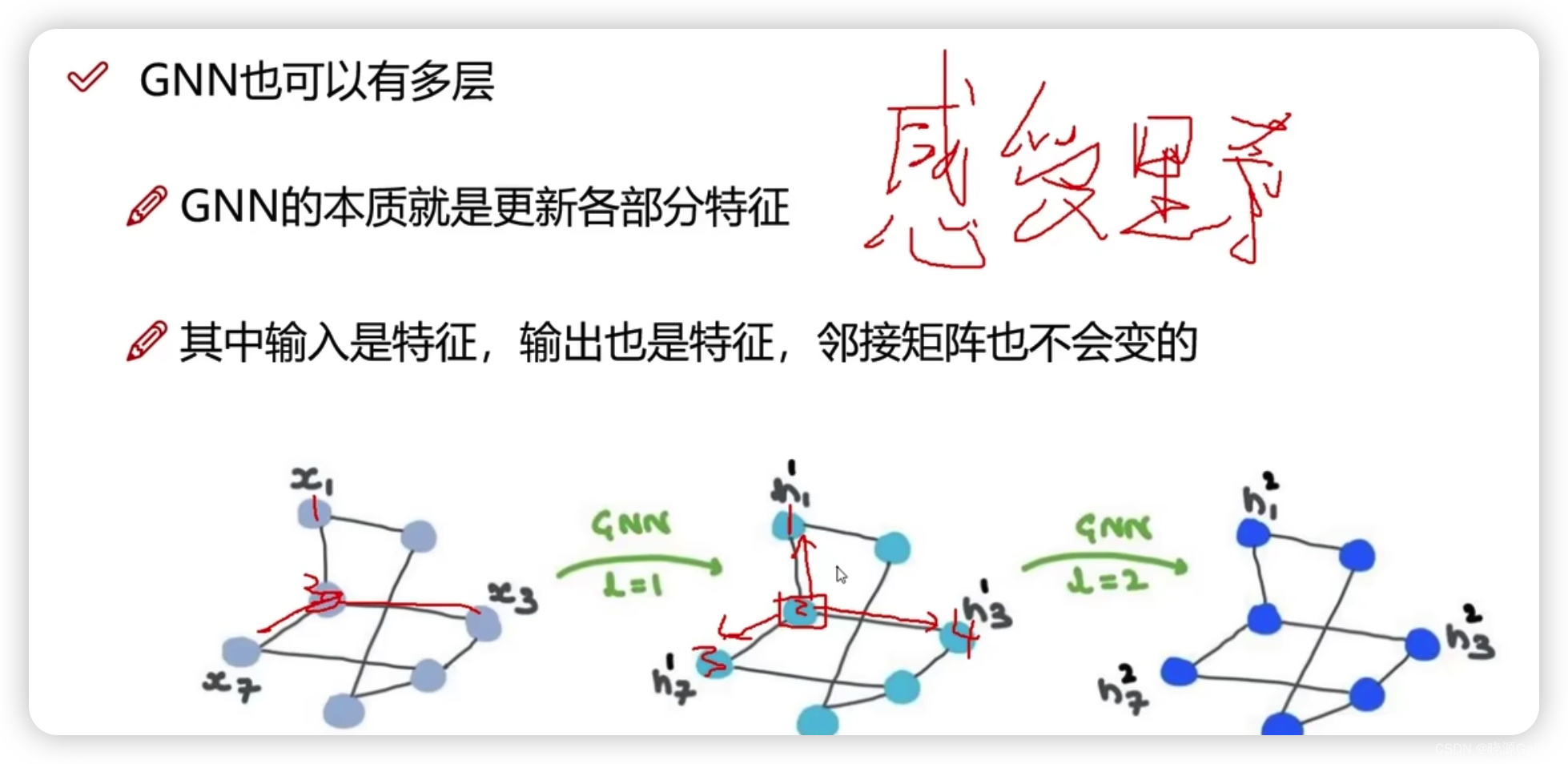

6.多层GNN的作用

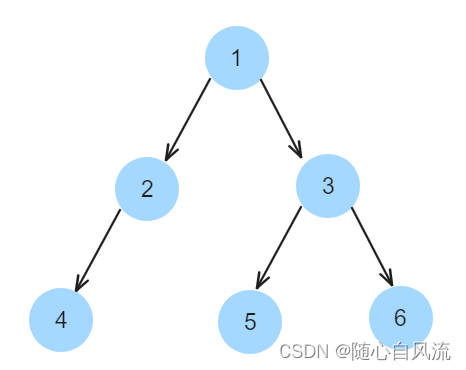

首先,多层GNN并不会破坏图的结构(拓扑关系/邻接结构)。

而多层GNN能使得本点上的特征信息,不断进行迭代(就好像计算机网络中rip,不断交换路由信息,来得到更远处的路由信息,从而最后收敛)

GCN是Graph Convolutional Network图卷积神经网络的缩写。

原文地址:https://blog.csdn.net/Fangyechy/article/details/135434359

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_52816.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。