❤️作者主页:小虚竹

❤️作者简介:大家好,我是小虚竹。2022年度博客之星评选TOP 10🏆,Java领域优质创作者🏆,CSDN博客专家🏆,华为云享专家🏆,掘金年度人气作者🏆,阿里云专家博主🏆,51CTO专家博主🏆

❤️技术活,该赏

❤️点赞 👍 收藏 ⭐再看,养成习惯

老规矩,文末有送书的规则~~

文章目录

零:前言

虚竹哥最近发现,当国外OpenAI的权力的游戏反转再反转的时候,国内的AI创业者们除了吃瓜之外也没闲着。

有很多程序员正在AIGC赛道中默默发财,有通过短视频做内容爆火,接广告的;有卖AI解决方案的;有卖AI课程的;也有卖AI产品,慢慢做大做强的…更不必说,那些拿下“人均年薪100万”大模型相关岗位的“赢家们”。

你看,拼多多杀入大模型,狂发年薪百万的大模型offer。vivo副总裁周围也表示目前vivo大模型的人才成本平均税后为100万元。而且通过今年的秋招,我们能看到,大平台都在找懂大模型的人,而NLP算法工程师、深度学习等岗位更是大模型人才市场里最为紧缺和急需的头批人才。

一、显然,率先拥抱AI的人,已经拿到了新世界的入场券。

虚竹哥希望能够帮助粉丝朋友们迅速地抓住机遇,吃上大模型时代红利,为此,带来了这本由新加坡科技研究局人工智能高级研究员黄佳编写的**《GPT图解大模型是怎样构建的》**。

不管你是NLP领域学生、研究人员,还是对ChatGPT和生成式模型有兴趣的人,亦或是基础不深,但是想入门AI的初学者,都别错过这本书!

要知道,市面上讲述大模型的书籍,大多采用百科全书式的呈现方法,为读者讲解现成的知识结论。 《GPT图解大模型是怎样构建的》 却是通过一问一答的方式,趣味诠释程序员们应该知道、可能好奇的ChatGPT和大模型的疑问、核心技术,梳理生成式语言模型的发展脉络。

在这本书里,黄佳老师将带领读者踏上一段扣人心弦的探索之旅,了解ChatGPT的前世今生,并能动手从0到1搭建语言模型。

二、谁说大模型只是一夕之间爆火的?每一次技术的演进都有它背后的故事

在20世纪40年代和50年代,人工智能的概念开始浮现,但直到1956年的 达特茅斯会议 上,它才成为一个独立的学科领域。

达特茅斯会议吸引了许多计算机科学家、数学家和其他领域的研究者,他们聚集在一起讨论智能机器的发展前景。他们的共同目标是在计算机上实现人类智能的各个方面,为现代人工智能研究开辟了道路。从那时起,人工智能领域不断发展,涌现出了大量的理论、技术和应用。

人工智能(Artificial Intelligence,AI)技术有两大核心应用:计算机视觉(Computer Vision,CV)和自然语言处理 (Natural Language Processing,NLP)。而在 AI 技术发展里程碑中,前期的突破多与 CV 相关, 如 CNN 和 AlexNet ;而后期的突破则多与 NLP 相关,如 Transformer 和 ChatGPT。

从发端,到寒冬,到发展,到二次寒冬,再到深度学习时代的崛起,最后到如今的ChatGPT辉煌时代。可以说,AI技术的发展并不是一帆风顺的:盛夏与寒冬交错,期望和失望交融。

自然语言处理技术也是如此。

这本书在谈论关于语言模型的原理和代码以外,最耐人寻味的便是余老师对自然语言处理技术演进的科普以及何为语言?信息又如何传播?

同时他让读者了解到:自然语言处理技术的演进过程包含一些独属于它的微妙细节。而对这个过程的体会,能够让我们对自然语言处理技术有更深的领悟。

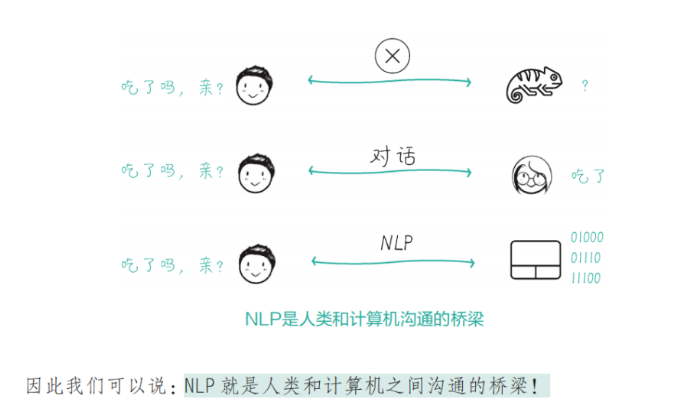

比如,对于NLP的定义,黄佳老师在书中是这样描述的:

“自然语言处理是人工智能的一个子领域,关注计算机如何理解、解释和生成人类语言。NLP 的核心任务,就是为人类的语言编码并解码,只有让计算机能够理解人类的语言,它才有可能完成原本只有人类才能够完成的任务。因此我们可以说:NLP 就是人类和计算机之间沟通的桥梁!”

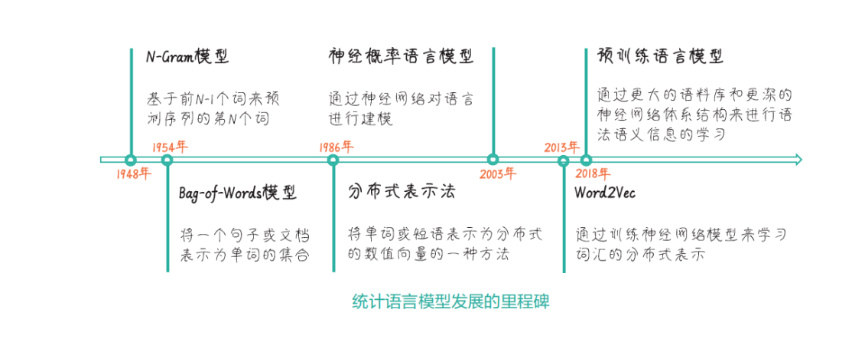

再比如,对于NLP 技术的演进过程,黄佳老师将其分为4个阶段,使用了 4 个词语来概括它们,分别是起源、基于规则、基于统计、深度学习和大数据驱动,厘清了它们的传承关系。

基于规则和基于统计的语言模型是 NLP 技术发展的关键节点,而大规模语言模型的诞生又进一步拓展了 NLP 技术的应用范围。

过去的十余年,语言模型的算法层出不穷。这本书的可贵之处在于它能够追本溯源,既让读者学会了语言模型的经典与主流算法,也让读者见证了其发展脉络,引导读者思考自然语言处理技术是怎么一步一步走到今天的。

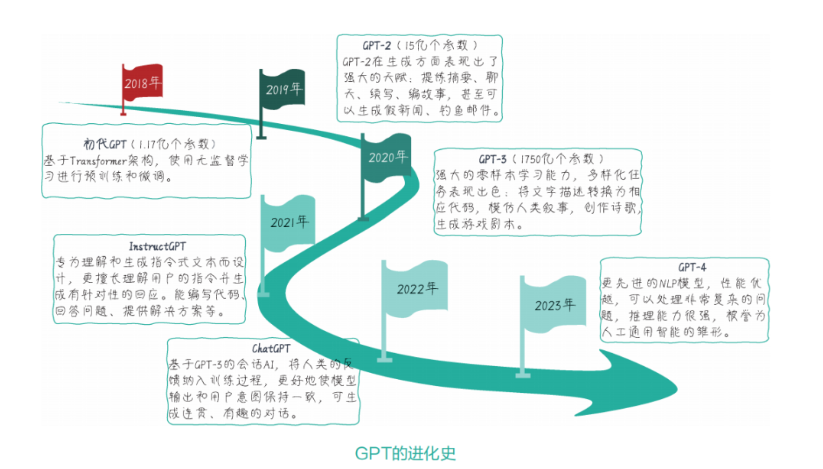

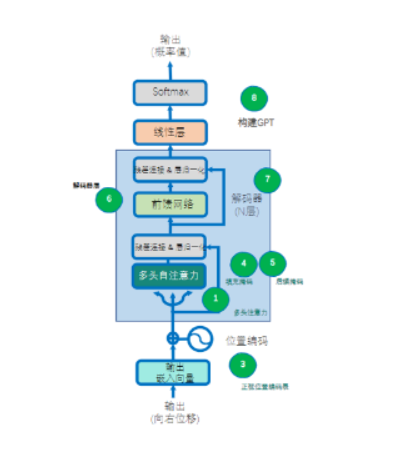

比如,书中精选了早期的N-gram以及基于浅层神经网络的NPLM进行详细讲解,并逐步过渡到基于深层网络的语言模型(生成式语言模型GPT)。GPT模型的深层网络不再采用CNN、RNN或者LSTM等结构,而是采用表达能力更强的Transformer,因此在讲解GPT模型时,黄佳老师更细致地讲解了“Transformer的思想是什么,其核心组件有哪些,为什么其表达能力更强”。

三、不明觉厉的大模型,怎么学习?好懂又好记的对话+图解方式

说到这里,想必大家已经从宏观上对 NLP 的发展、大型预训练模型的发展, 甚至从 ChatGPT 到 GPT-4 的发展有了一定的理解。

在这本书中,黄佳老师 会循着自然语言处理技术的演进过程,给读者讲透它的技术重点,并和大家一起实际操练一番,一步一步带你学透 GPT。

正如黄佳老师所说:“今天,在我们为 ChatGPT、GPT-4 等大模型的神奇能力而惊叹的同时,让我们对它们的底层逻辑与技术做一次严肃而快乐的探索。对我来说,这也是一次朝圣之旅,一次重温人工智能和自然语言处理技术 70 年间艰辛发展的旅程。”

从 N-Gram、词袋模型(Bag-of-Words,BoW)、Word2Vec(Word to Vector,W2V)、神经概率语言模型(Neural Probabilistic Language Model,NPLM)、循环神经网络(Recurrent Neural Network,RNN)、Seq2Seq(Sequence-to-Sequence,S2S)、注意力机制(Attention Mechanism)、Transformer、BERT 到 GPT 的技术,其中凝聚了多少位了不起的大牛的知识和心血,对于许多程序员而言,自行学习其中的原理和代码也是比较麻烦和有难度的。

对于已有基础的程序员尚且如此,何况是零基础的小白呢?

这套书令人惊喜的是它试图通过一问一答的教学方式,加上图文并茂的讲解,关注初学者学习中的真实问题,一一回答,讲解语言模型,对技术进行解码。

比如,在介绍N-Gram时:

正文每个小节以小冰的提问为线索,以最新热点为引入,以公司同事在不同时间、不同场景中的对话为讲述方式,深入浅出地剖析大模型相关的知识,讲解语言模型和算法背后的意义。

小冰是一个充满好奇心的初学者,是生活于当下的你我他。她的提问正是我们的疑问点,她那不太完美的回答正是我们目前的认知。而咖哥则是一位博学多才、幽默风趣且喜欢答疑解惑的技术大咖。他的特别发言也被“附”在书中,记录对应的原理和代码,专业解答相关问题。

在小冰和咖哥一问一答的演绎下,黄佳老师将晦涩难懂的知识用通俗易懂的语言表述出来,将抽象概念具体化,轻松风趣地解答初学者可能会对大模型感到好奇的种种问题。

在翻阅这本书时,像下面这些章节名也令人印象深刻:

序章 看似寻常最奇崛,成如容易却艰辛

第 1 课 高楼万丈平地起:语言模型的雏形 N-Gram 和简单文本表示 Bag-of-Words

第 2 课 问君文本何所似:词的向量表示 Word2Vec 和 Embedding

第 3 课 山重水复疑无路:神经概率语言模型和循环神经网络

第 4 课 柳暗花明又一村:Seq2Seq 编码器 – 解码器架构

第 5 课 见微知著开慧眼:引入注意力机制

第 6 课 层峦叠翠上青天:搭建 GPT 核心组件 Transformer

第 7 课 芳林新叶催陈叶:训练出你的简版生成式 GPT

第8课 流水后波推前波:ChatGPT基于人类反馈的强化学习

第9课 生生不息的循环:使用强大的GPT-4 API

后 记 莫等闲,白了少年头

黄佳老师特意以**“古诗词+章节内容”**的形式为每个讲解不同语言模型的篇章命名,多为古诗词的改编,加上暗喻,用字数简短但是意蕴深厚的古诗词提炼大模型的特征、语言模型的发展脉络,让知识点直观、易懂、易记。

四、学习难度不低的大模型,如何构建?生动有趣的图画、独具匠心的项目设计和详尽的代码、数据集

黄佳老师 是新加坡科技研究局人工智能高级研究员,他主攻的方向为NLP大模型的研发与应用、持续学习、AI in FinTech、AI in Spectrometry Data。

他曾著有《零基础学机器学习》《数据分析咖哥十话》等多部畅销书籍,深耕数据科学领域多年,积累了丰富的科研项目和政府、银行、能源、医疗等领域AI项目落地实战经验。

因此,在本书中,他不拘泥于理论的堆砌,而是带领读者从基础到进阶,从理论模型到实战剖析,让读者真正明白大模型是怎样构建的。

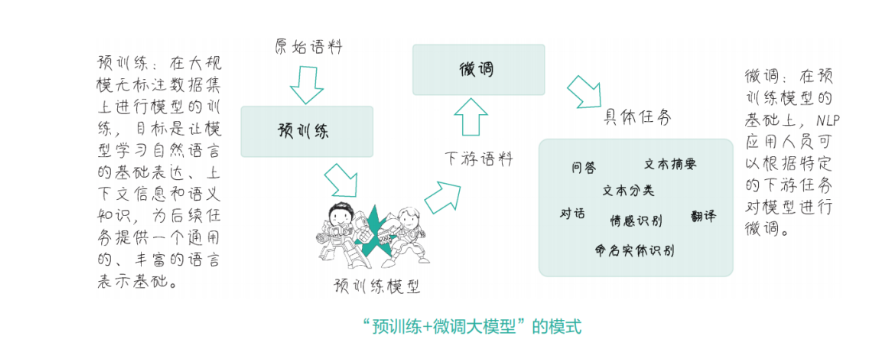

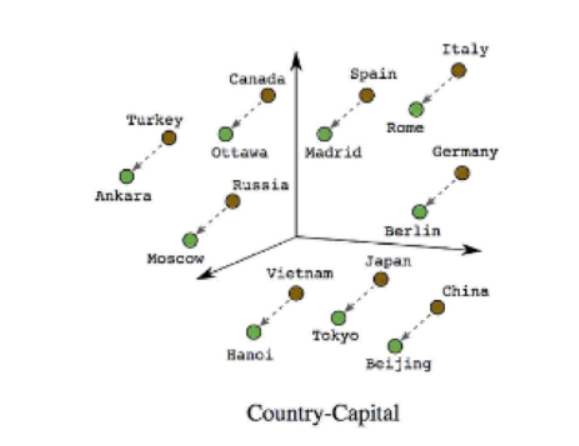

比如,ChatGPT属于大语言模型的一类,那么黄佳老师首先会在书中通俗地讲解“什么是语言模型,什么是大语言模型”,在讲解语言模型时,会引出词向量、词嵌入等NLP领域几个最常用的概念,以及经典方法Word2Vec。

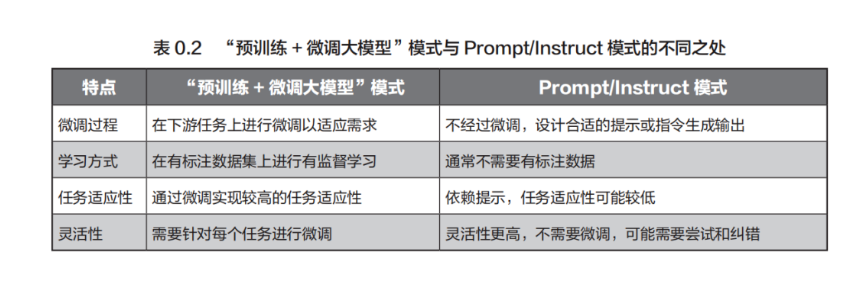

这时候,好文配好图,为大模型的教学锦上添花就十分重要了。插图作为技术书籍的重要组成部分,也是让初学者能更加直白地汲取知识的一种手段。

此次,书中的插画抓住黄佳老师讲解的技术精髓,在诠释技术原理的同时做到了生动与幽默。除了插图以外,书中还有大量表格,尽可能地帮助读者理解相关问题。

图文并茂的讲解方式 能让读者快速了解相关技术知识,而手把手的代码实战能让读者轻松上手搭建大模型,更何况这本书二者兼备。

黄佳老师会在书中根据技术发展的脉络讲解多个实战项目,以生动活泼的笔触将枯燥的技术细节化作轻松幽默的故事和缤纷多彩的图画,一步一代码加注释手把手教学读者进行实战。

项目一:N-Gram构建

项目二:Word2Vec构建

项目三:NPLM(Neural Probabilistic Language Model)构建

项目四:Seq2Seq架构

项目五:注意力机制

项目六:Transformer架构

项目七:WikiGPT

项目八:miniChatGPT

令人惊喜的是,本书还提供实例配套资源代码和实例数据集等资源,这有助于读者更好地理解书中的概念和实践技巧。通过实例代码,初学者可以直接尝试和运行代码,通过实践来加深对书中内容的理解。而实例数据集则帮助读者在处理真实数据时进行实践操作,从而更好地掌握相关技术。

虚竹哥看了这本书后,不由感慨:这多有意思啊!在攀登技术新峰的奇妙之旅中,我们不仅能深入理解自然语言处理技术的核心原理,还能自己动手,从零开始搭建起一个又一个语言模型,成就感满满!

虚竹哥相信,无论你是在校学生还是人工智能从业者,这本书都将成为一盏明灯,照亮你探索人工智能无限奥秘的道路!

五、参考文献:

1.生成式预训练语言模型:理论与实战 – 深蓝学院 – 专注人工智能与自动驾驶的学习平台;

2.奥特曼离职后,OpenAI的竞争对手争相挖走员工;

3.微软希望获得OpenAI董事会席位。

六、粉丝福利

回馈粉丝们的支持,送《GPT图解大模型是怎样构建的》实体书给4位粉丝。一起学习!

福利0

虚竹哥直接送2本好书,参与好评送书~

参与好评送书:随机抽取2位幸运读者,送一本《GPT图解大模型是怎样构建的》实体书

统计截止时间:2024/01/17 19:00:00

请中奖的读者统计截止时间过后7天内私信虚竹哥收货地址,过期奖励作废哈!

福利1

来虚竹哥送书的朋友圈点赞,点赞送书~

虚竹哥开放好友位 :传送门–》

第8个好友和第88个好友点赞的,2位幸运读者,各送一本《GPT图解大模型是怎样构建的》实体书

统计截止时间:2024/01/17 19:00:00

请中奖的读者统计截止时间过后7天内私信虚竹哥收货地址,过期奖励作废哈!

购书传送门–》《GPT图解大模型是怎样构建的》

我是宠粉的虚竹哥,请继续支持我,哈哈哈~

原文地址:https://blog.csdn.net/shi_hong_fei_hei/article/details/135601268

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_57914.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!