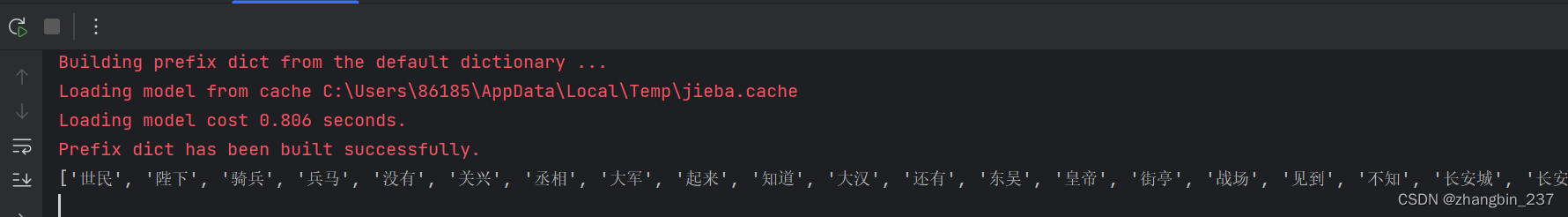

本文介绍: jieba分词主要有3种模式:1、精确模式:jieba.cut(文本, cut_all=False)2、全模式:jieba.cut(文本, cut_all=True)3、搜索引擎模式:jieba.cut_for_search(文本)

1、精确模式:jieba.cut(文本, cut_all=False)

2、全模式:jieba.cut(文本, cut_all=True)

3、搜索引擎模式:jieba.cut_for_search(文本)

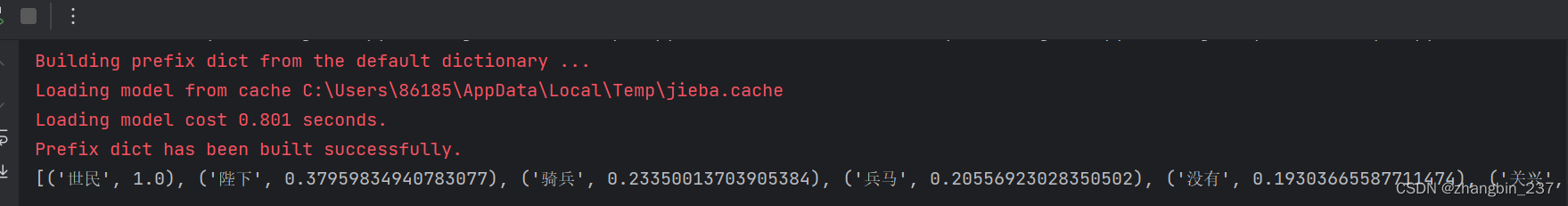

jieba.analyse.textrank(txt,topK=20, withWeight=False)allowPOS:是否指定关键词词性(名词、形容词、动词),默认为空,也就是不筛选

import jieba.analyse

import jieba

import chardet

import wordcloud

# 文件路径

path = 'C:\Users\86185\PycharmProjects\pythonProject\practice\txt'

file='lsm.txt'

#指定文件

txt_url=path+'\'+file

#打开文件,这一次打开主要是为了获取编码格式

with open(txt_url, 'rb') as f:

cont = f.read()

encoding = chardet.detect(cont)['encoding']

if encoding == 'GB2312':

encoding = 'gbk'

elif encoding == None:

encoding = 'utf-8'

f.close()

#打开文件内容

with open(txt_url, encoding=encoding) as f:

txt = f.read()

txt_word=jieba.cut_for_search(txt)

#print(list(txt_word))

txt_main=jieba.analyse.textrank(txt,topK=20, withWeight=False)

print(txt_main)

如果展示权重:

原文地址:https://blog.csdn.net/weixin_39407597/article/details/134668563

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_7455.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。