尽管全球目睹了OpenAI的权力斗争和大规模辞职,但作为AI领域的长期支持者,微软并没有放慢自己的人工智能努力。今天,由萨提亚·纳德拉领导的公司研究部门发布了Orca 2,这是一对小型语言模型,它们在零样本设置下对复杂推理任务的测试中,要么匹敌要么超越了体积是它们五到十倍的大型语言模型,包括Meta的Llama-2 Chat-70B。

这些模型分别具有70亿和130亿参数,是在几个月前展示了通过模仿更大、更有能力模型的逐步推理轨迹而展现出强大推理能力的原始13B Orca模型工作的基础上构建的。

微软的研究人员在一篇联合博客文章中写道:“通过Orca 2,我们继续展示改进的训练信号和方法可以让小型语言模型实现更强的推理能力,这通常只在更大的语言模型中找到。”

公司已经开源了这两个新模型,以进一步研究小型模型的开发和评估,这些模型可以像更大的模型一样表现出色。这项工作可以为企业(特别是资源有限的企业)提供更好的选择,以应对其目标用例,而无需在计算能力上投入过多。

了解更多 教小型模型如何推理 虽然像GPT-4这样的大型语言模型长期以来一直以其推理能力和解释复杂问题的能力给企业和个人留下深刻印象,但它们的小型对应物大多缺乏这种能力。微软研究院决定通过对Llama 2基础模型进行微调来解决这一差距,使用高度定制的合成数据集。然而,研究人员训练小型模型采用不同的解决策略来应对不同的任务,而不是训练模型去复制更有能力模型的行为——这是一种常用的模仿学习技术。这个想法是,更大模型的策略可能并不总是适用于小型模型。例如,GPT-4可能能够直接回答复杂的问题,但一个小型模型在没有那种能力的情况下,可能会受益于将同一任务分解成几个步骤。

研究人员在今天发表的一篇论文中写道:“在Orca 2中,我们教授模型各种推理技术(逐步、回忆然后生成、回忆-推理-生成、直接回答等)。更重要的是,我们旨在帮助模型学会确定每项任务最有效的解决策略。”该项目的培训数据是从一款更有能力的教师模型中获取的,以这样的方式教导学生模型处理两个方面:如何使用推理策略以及何时准确地使用它来处理手头的任务。

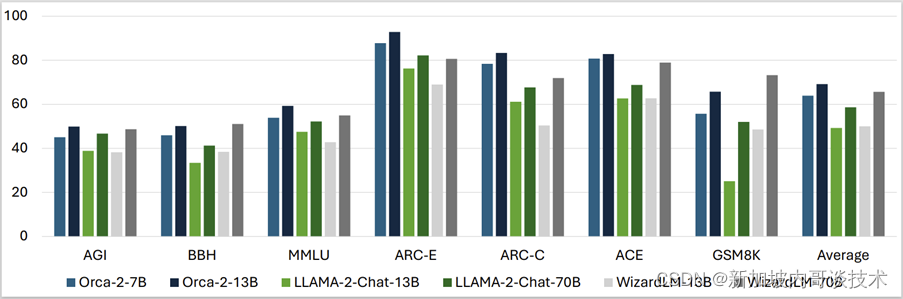

Orca 2在较大模型中的表现更佳 在零样本设置下的15项多样化基准测试(包括语言理解、常识推理、多步骤推理、数学问题解决、阅读理解、总结和真实性等方面)中,Orca 2模型取得了惊人的结果,其表现大多与体积是它们五到十倍的模型相匹敌或超越。所有基准测试结果的平均值显示,Orca 2的7B和13B在Llama-2-Chat-13B和70B以及WizardLM-13B和70B上表现更好。只有在GSM8K基准测试中,它包含了8.5K高质量的小学数学问题,WizardLM-70B比Orca模型和Llama模型做得更好。

Orca 2基准测试结果 Orca 2基准测试结果 虽然这种表现对于可能希望使用小型、高性能模型进行经济高效的商业应用的企业团队来说是个好消息,但重要的是要注意,这些模型也可能继承其他语言模型以及它们所基于的基础模型的普遍限制。

微软补充说,创建Orca模型的技术甚至可以用于其他基础模型。

“尽管它有几个限制……,Orca 2在未来发展的潜力是显而易见的,尤其是在提高小型模型的推理能力、专业化、控制和安全性方面。使用精心筛选的合成数据进行后期培训被证明是这些改进的关键策略。随着更大的模型继续表现出色,我们与Orca 2的合作标志着在语言模型的应用和部署选项多样化方面迈出了重要的一步。”研究团队写道。

更多小型高性能模型即将涌现 随着开源Orca 2模型的发布和该领域的持续研究,可以肯定地说,更多高性能的小型语言模型可能会在不久的将来出现。

就在几周前,中国最近成为独角兽的01.AI,由资深人工智能专家李开复创立,也在这一领域迈出了重要的一步,发布了一款支持中英文的340亿参数模型,其性能超过了70亿的Llama 2和180亿的Falcon对手。该初创公司还提供了一个经过6亿参数训练的较小选项,在广泛使用的AI/ML模型基准测试中表现尚可。

Mistral AI,这家成立六个月的巴黎初创公司,因其独特的Word Art标识和创纪录的1.18亿美元种子轮融资而成为头条新闻,也提供了一款70亿参数的模型,其性能超过了更大的产品,包括Meta的Llama 2 13B(Meta较小的新型号之一)。

原文地址:https://blog.csdn.net/2301_79342058/article/details/134614096

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_944.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!