这些天我忽然有个需求,要更新迭代一个场景的检测模型,甲方爸爸提供的新数据集是监控视频形式的(因为拍视频确实更加的方便),而我训练模型确实要标注好的图片形式。

根据这些条件的话,思路应该是要这样的:首先使用现有的最新一个模型输入视频进行检测,检测结果以每帧图片的形式进行保存,以及每帧图片对应的label。将图片和label用标注工具打开如labelme等进行可视化调整模型标注好的数据(这样比每张图片直接从0开始标注要快),再将这些标注好的数据加入之前的数据中进行训练。

保存图片形式

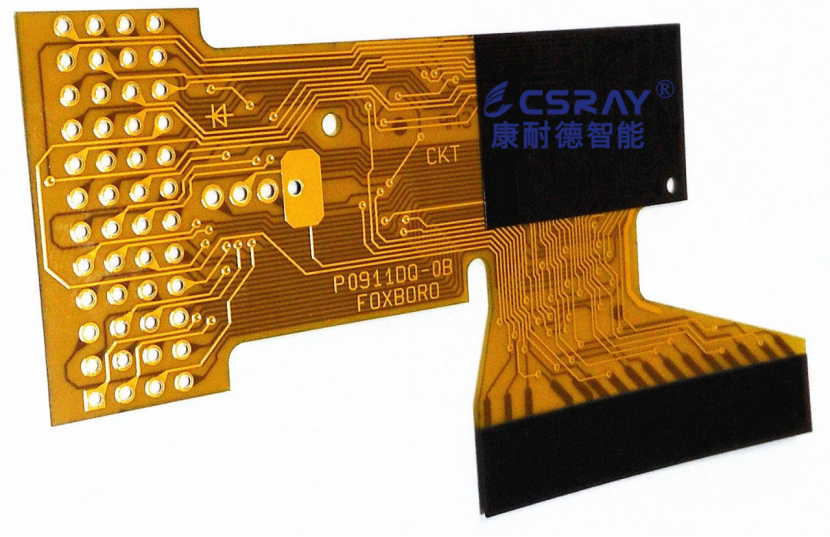

这个流程可能会有几处有些障碍,一个是模型检测生成的label的yolo格式数据转化成labelme格式的数据以及调整好之后labelme格式的数据再转回yolo训练格式的数据,这个问题的解决及对应的代码写在我之前的文章中;另一个就是yolov5输入的是视频时输出的也同样是个视频,且是带有检测结果的视频(带有实时检测框的视频),如图:

而我们想要的是原图进行训练,保存的是原图及对应的label。解决方法如下:

在detect.py代码里的Process predictions中添加如下两行的代码:

e_save = os.path.splitext(save_path)[0] + f'_{frame}' + '.jpg'

cv2.imwrite(e_save, im0)

设置帧率

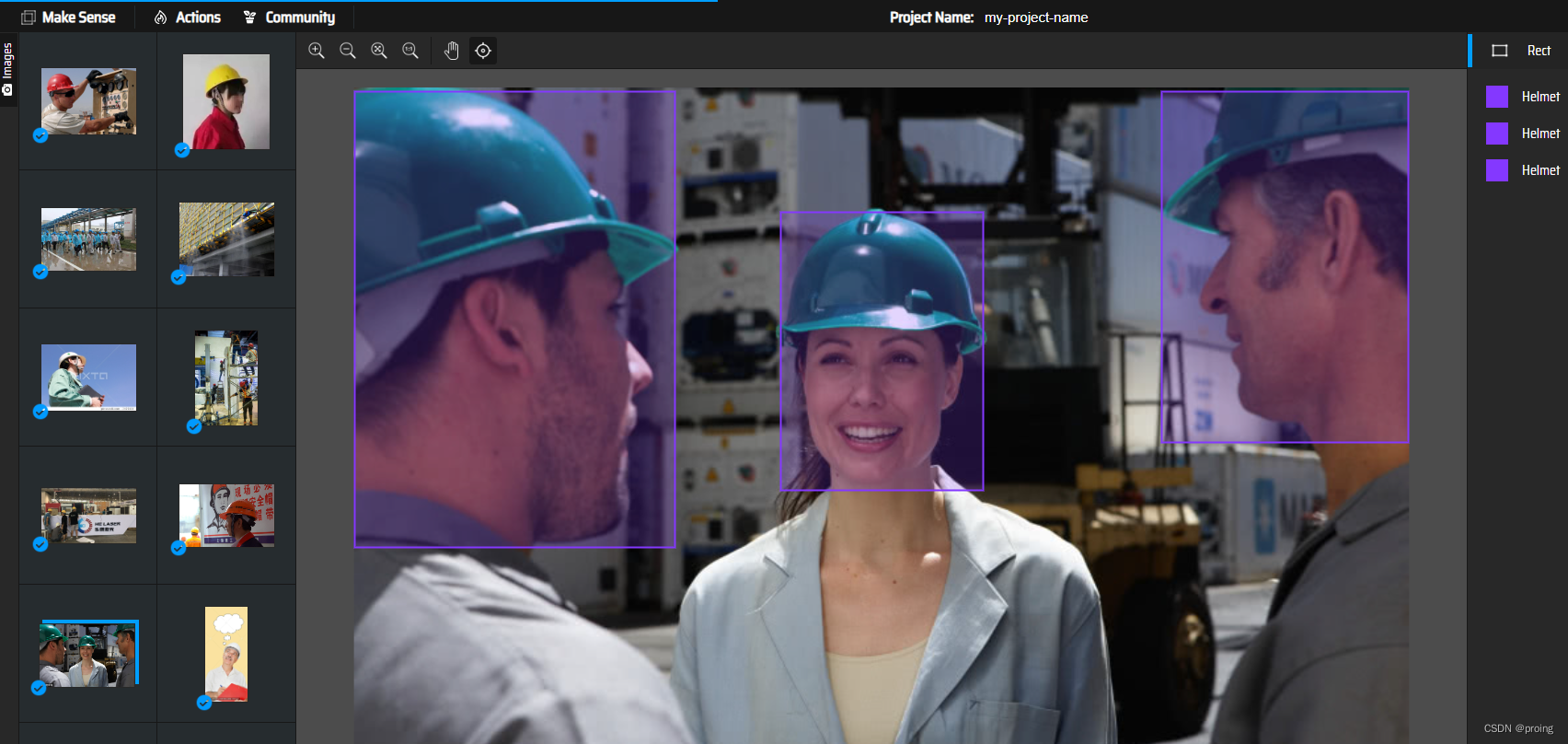

看了一下保存的图片,会发现一个问题,基本上每张图片会重复几十次。所以如果不是高速移动的目标的话每帧都保存会有大量几乎重复的图片,每张都拿来训练是没必要的且浪费修改label的时间,所以下面设置每隔几帧保存一次。

detect.py中前向推理部分的代码结构大概是这样的:

for path, img, im0s, vid_cap in dataset:

# ... 一些前期的代码 ...

# 运行检测

img = torch.from_numpy(img).to(device)

img = img.float() # uint8 to fp16/32

img /= 255.0 # 0 - 255 to 0.0 - 1.0

if img.ndimension() == 3:

img = img.unsqueeze(0)

# ... 一些中间的代码,可能有模型推理的部分 ...

# 后处理

# ...

# 在这里添加代码,确保只在每25帧执行检测

if vid_path:

current_frame += 1

if current_frame % 25 == 0:

# 执行你的检测代码

# ...

# ... 一些后期的代码 ...

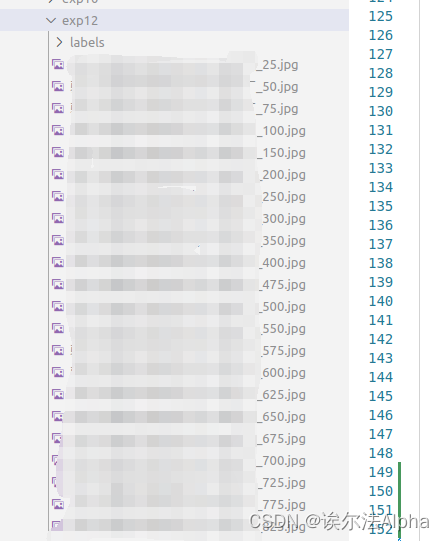

运行结果如图:

这样就减少了很多重复图片。

写在最后:

我觉得csdn是一个能学到技术的地方,那是因为很多大佬的无私奉献。我的每一条博文都是粉丝才可见,若是你们看了觉得我不值得你们关注,取关无可厚非。但是为什么就是有很多人收藏了我的博文然而又取消关注呢,我觉得让我很不舒服,我希望各位看管都是高素质人群,尊重一下创作者辣!不然越来越多这样的行为会打击分享技术的积极性,谢谢!

原文地址:https://blog.csdn.net/weixin_45354497/article/details/134582765

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_1034.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!