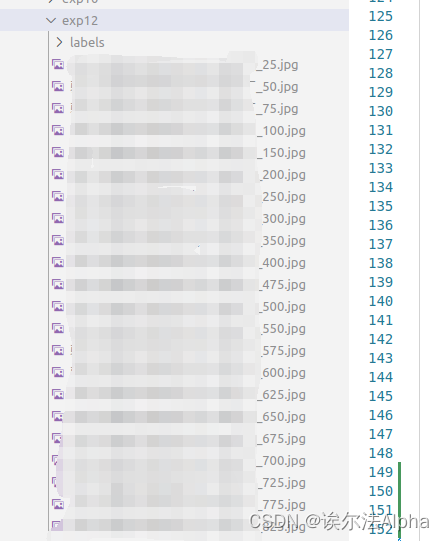

保存图片形式

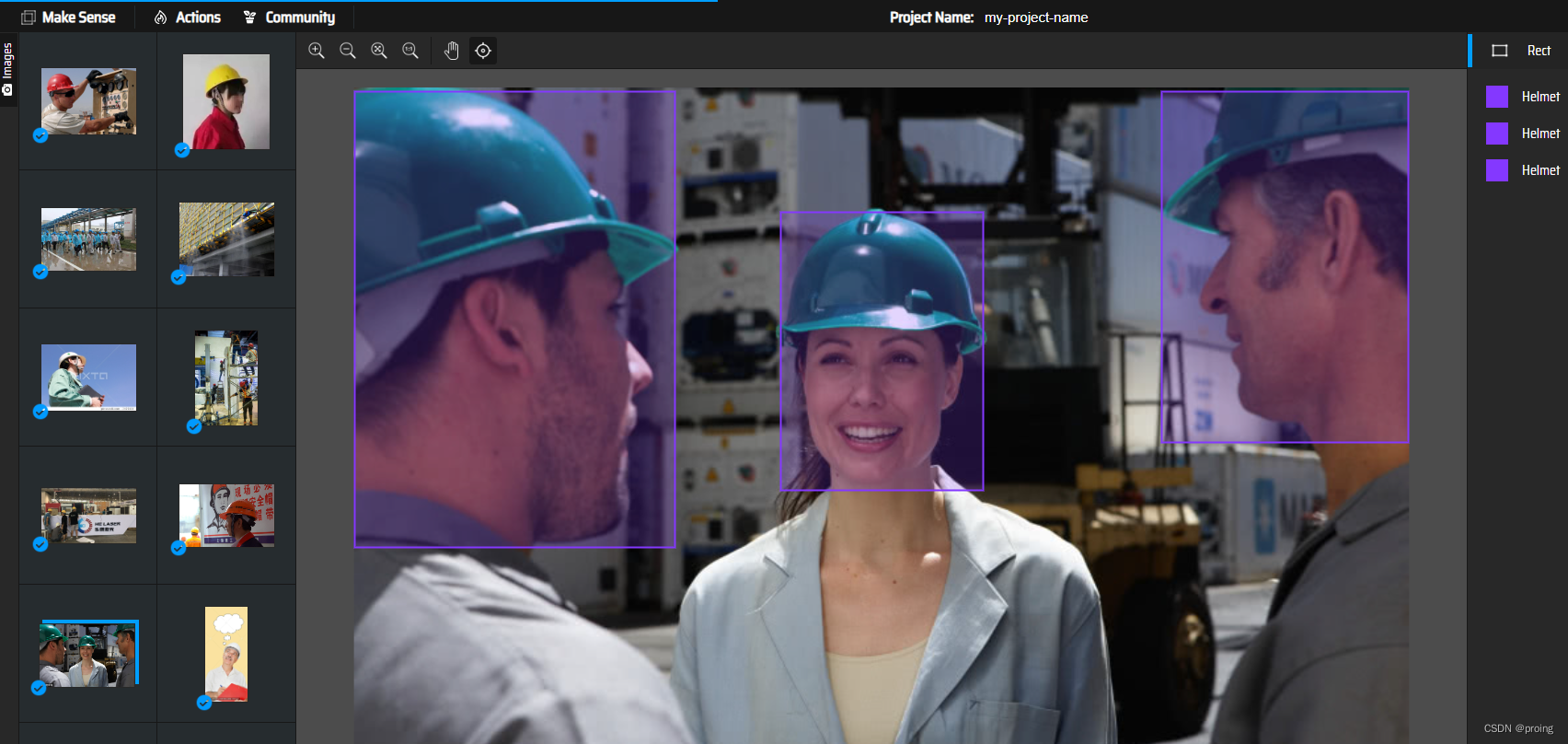

这个流程可能会有几处有些障碍,一个是模型检测生成的label的yolo格式数据转化成labelme格式的数据以及调整好之后labelme格式的数据再转回yolo训练格式的数据,这个问题的解决及对应的代码写在我之前的文章中;另一个就是yolov5输入的是视频时输出的也同样是个视频,且是带有检测结果的视频(带有实时检测框的视频),如图:

而我们想要的是原图进行训练,保存的是原图及对应的label。解决方法如下:

在detect.py代码里的Process predictions中添加如下两行的代码:

设置帧率

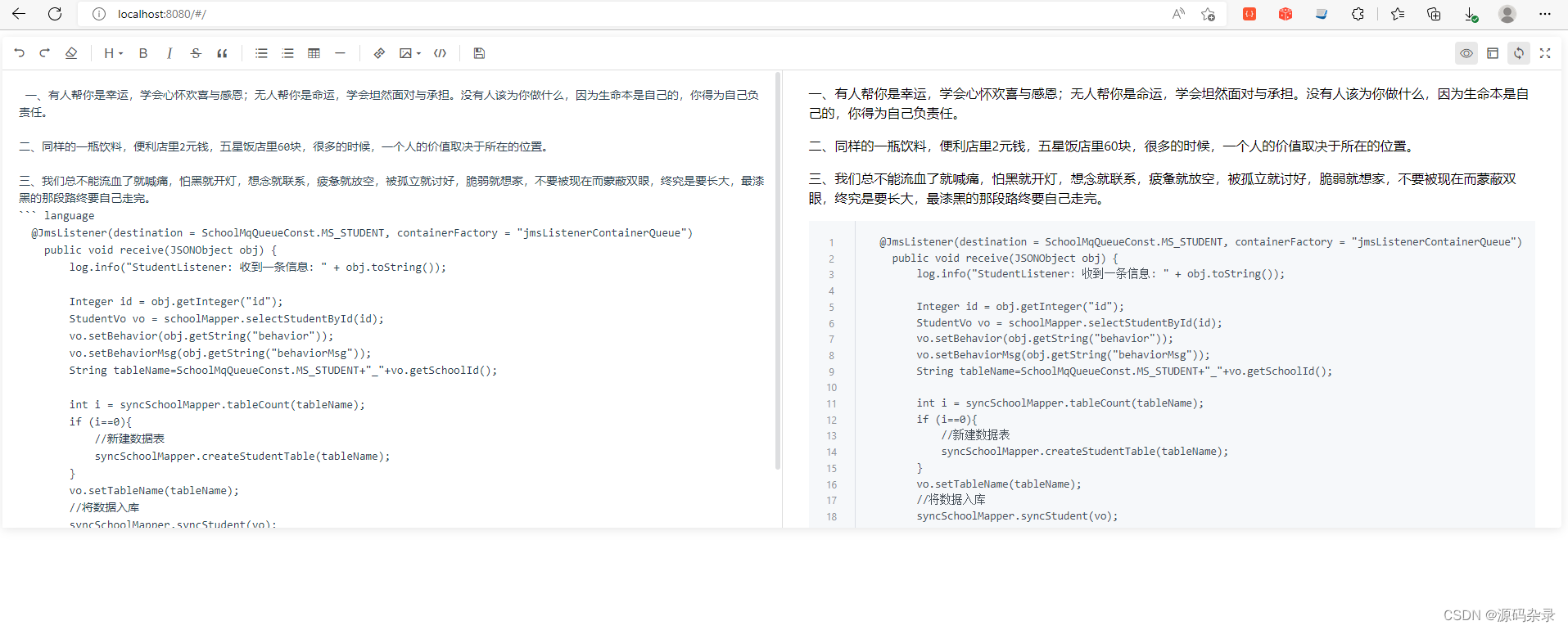

detect.py中前向推理部分的代码结构大概是这样的:

运行结果如图:

这样就减少了很多重复图片。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。