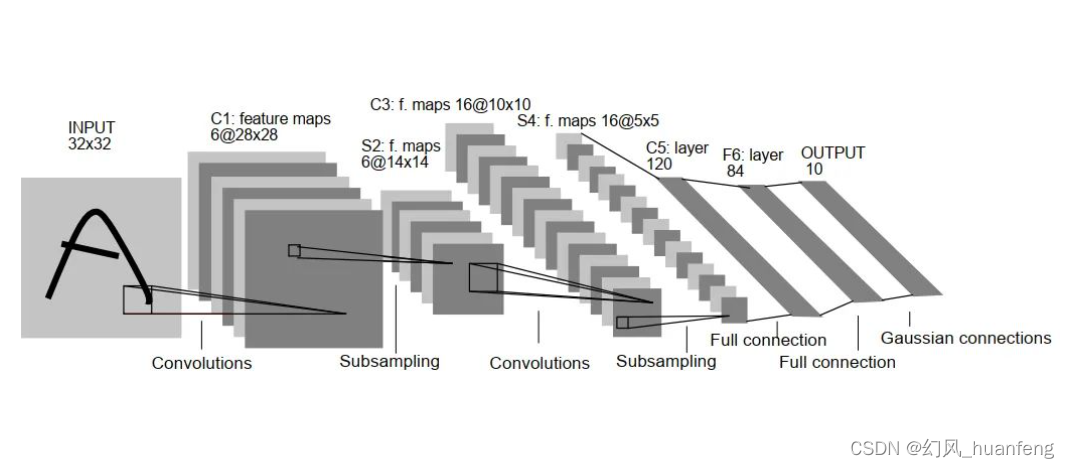

LeNet

假设你有一张 32×32×1 的图片,然后使用 6 个 5×5的过滤器,步幅为 1,padding 为 0,输出结果为 28×28×6。图像尺寸从 32×32 缩小到 28×28。

然后进行池化操作,使用平均池化,过滤器的宽度为 2,步幅为 2,图像的尺寸,高度和宽度都缩小了 2 倍,输出结果是一个14×14×6 的图像。

接下来又是卷积层,用一组 16 个 5×5 的过滤器,新的输出结果有 16 个通道,所以这个图像从 14 到 14 缩小到了10×10。

然后又是池化层,高度和宽度再缩小一半,输出一个 5×5×16 的图像。

将所有数字相乘,乘积是 400。下一层是全连接层,在全连接层中,第一个全连接层有120个神经元,然后还有一个全连接层有84个神经元,最后一步就是利用这 84 个特征得到最后的输出,我们还可以在这里再加一个节点用来预测 y^的值, y^有 10 个可能的值,对应识别 0-9 这 10 个数字。LeNet-5 网络在输出层使用了另外一种,现在已经很少用到的分类器。

LeNet,只有约 6 万个参数,当时人们并没有使用 padding,或者总是使用 valid 卷积,这就是为什么每进行一次卷积,图像的高度和宽度都会缩小。这个神经网络中使用 sigmoid 函数和 tanh 函数,而不是ReLu 函数。经典的 LeNet-5 网络在池化后进行了非线性

原文地址:https://blog.csdn.net/huanfeng_AI/article/details/134657557

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_4405.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!