本文介绍: 卷积层块的基本单位是卷积层后接最大池化层:其中卷积层用来识别图像里的空间模式,比如线条和物体的局部。同时卷积层保留输入形状,使得图像的像素在高和宽两个方向上的相关性均得到了有效的识别。另外一方面,卷积层通过滑动窗口将同一卷积核与不同位置的输入重复计算,从而避免参数尺寸扩大。而池化层则用来降低卷积层对位置的敏感性。

LeNet

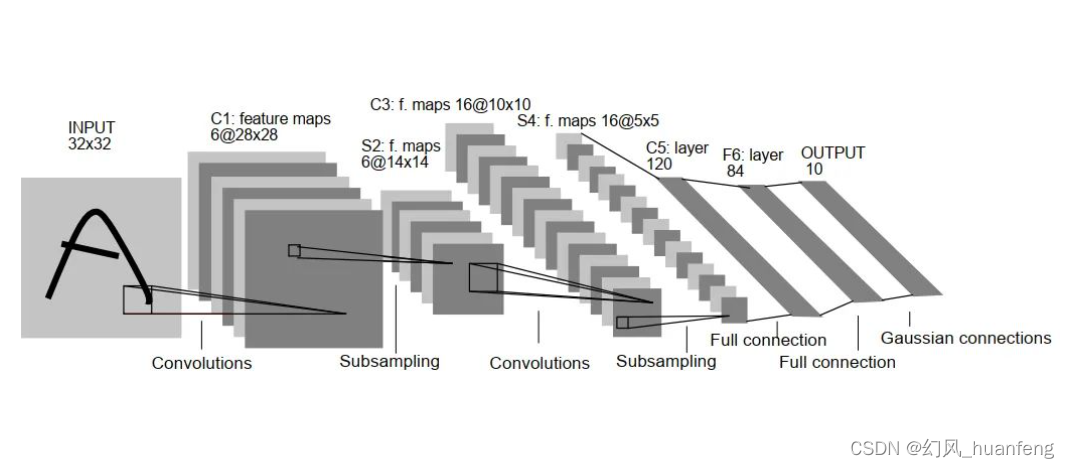

假设你有一张 32×32×1 的图片,然后使用 6 个 5×5的过滤器,步幅为 1,padding 为 0,输出结果为 28×28×6。图像尺寸从 32×32 缩小到 28×28。

然后进行池化操作,使用平均池化,过滤器的宽度为 2,步幅为 2,图像的尺寸,高度和宽度都缩小了 2 倍,输出结果是一个14×14×6 的图像。

接下来又是卷积层,用一组 16 个 5×5 的过滤器,新的输出结果有 16 个通道,所以这个图像从 14 到 14 缩小到了10×10。

然后又是池化层,高度和宽度再缩小一半,输出一个 5×5×16 的图像。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。