本文介绍: groupby分组与聚合、分层索引、设置是否包含NaN、排除组键,星巴克零售店铺数据下载,星巴克零售店铺directory.csv数据获取,groupby用法详解,pandas分组与聚合,groupby如何使用

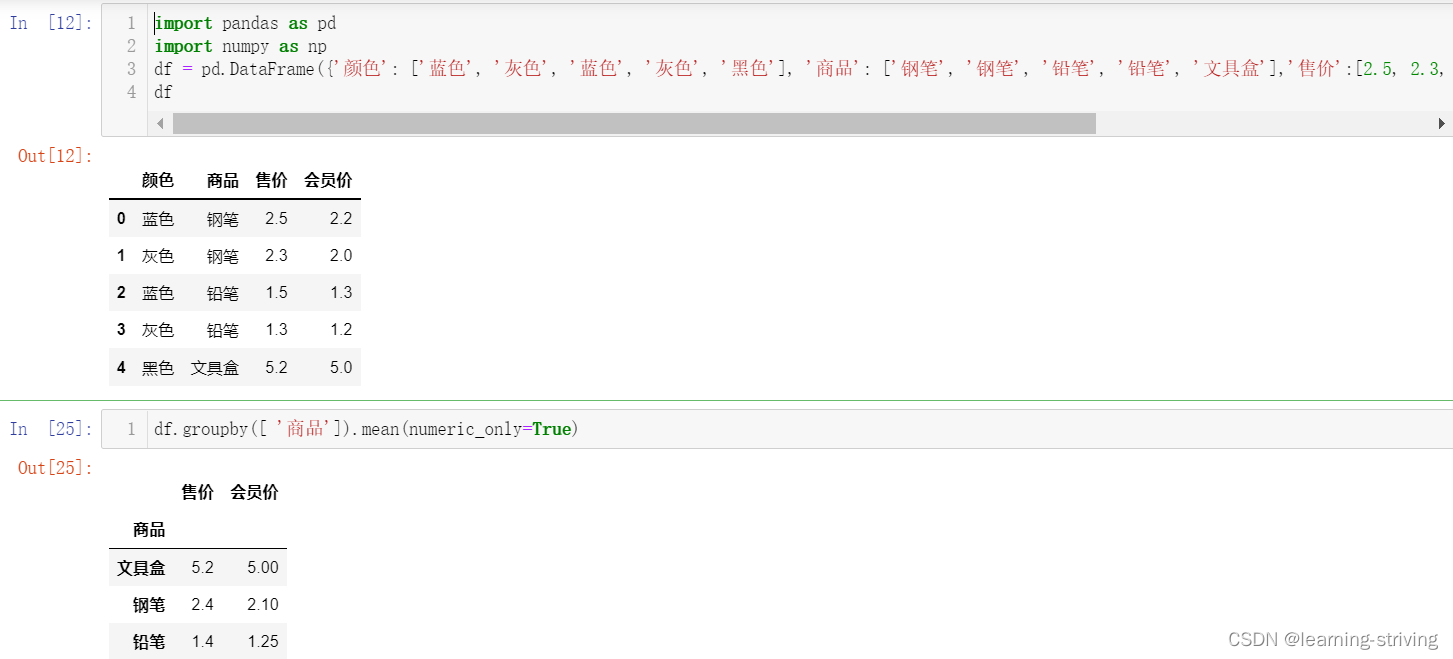

一、groupby分组与聚合

分组与聚合通常是分析数据的一种方式,通常与一些统计函数一起使用,查看数据的分组情况

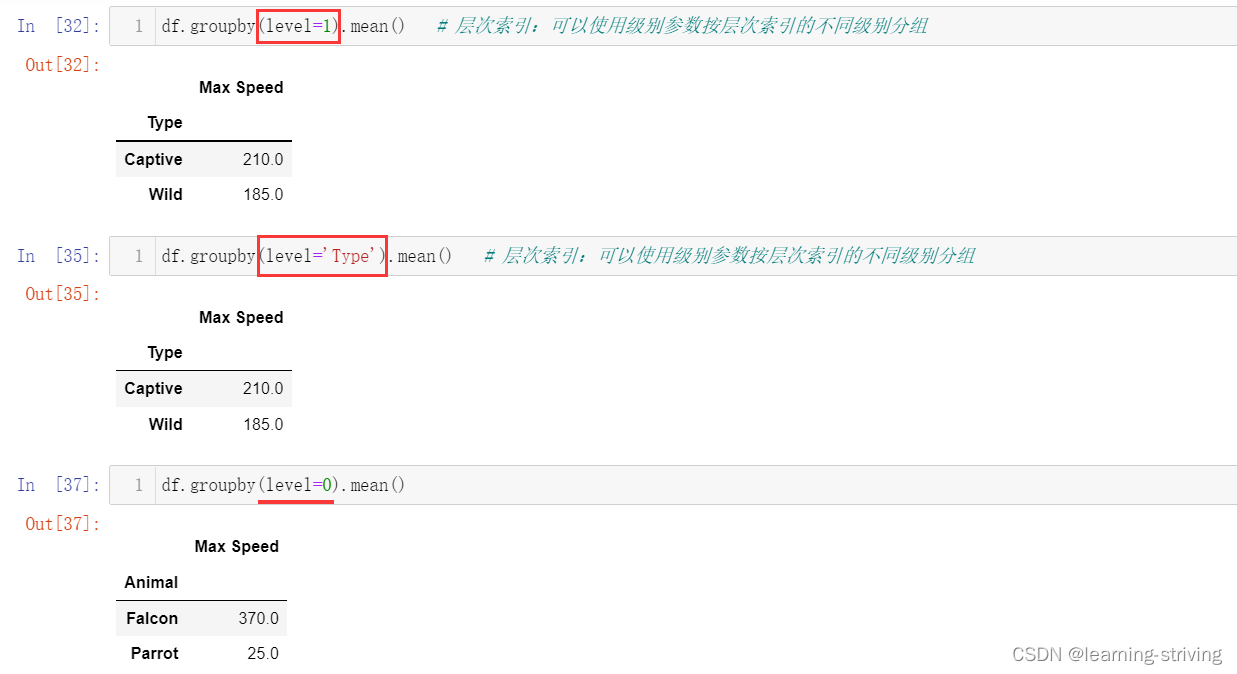

二、分层索引

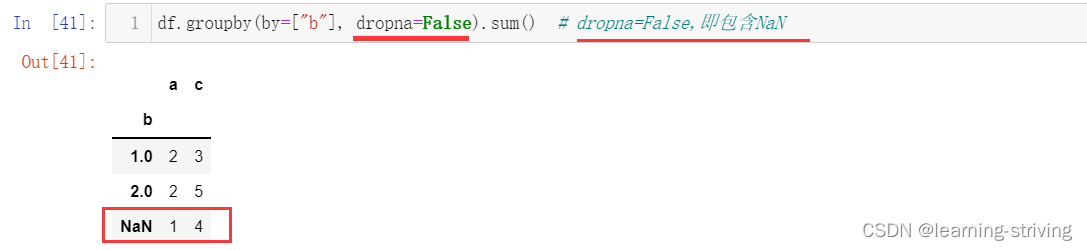

三、设置是否包含NaN

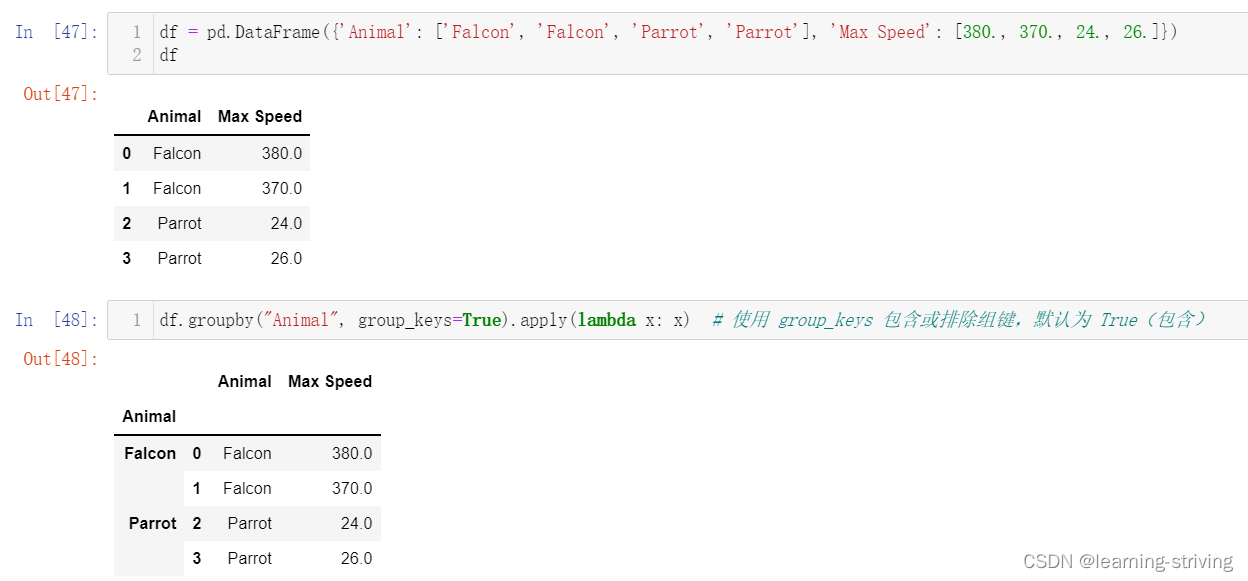

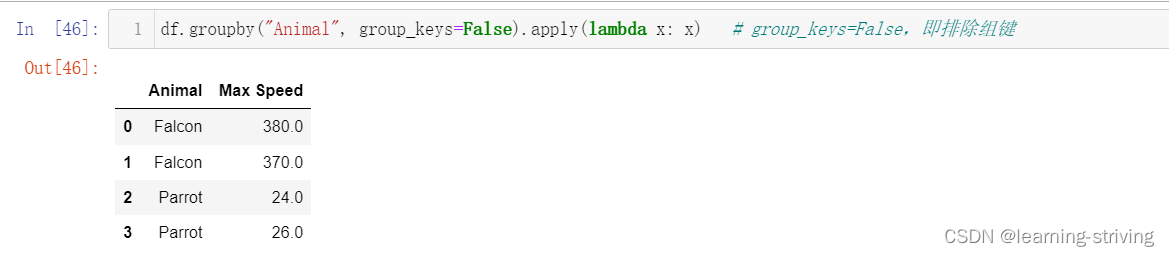

四、排除组键

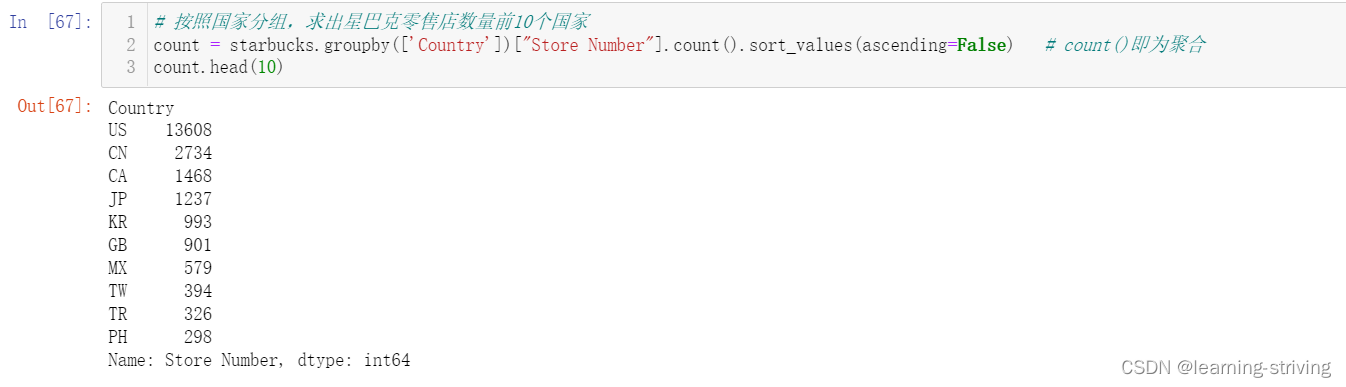

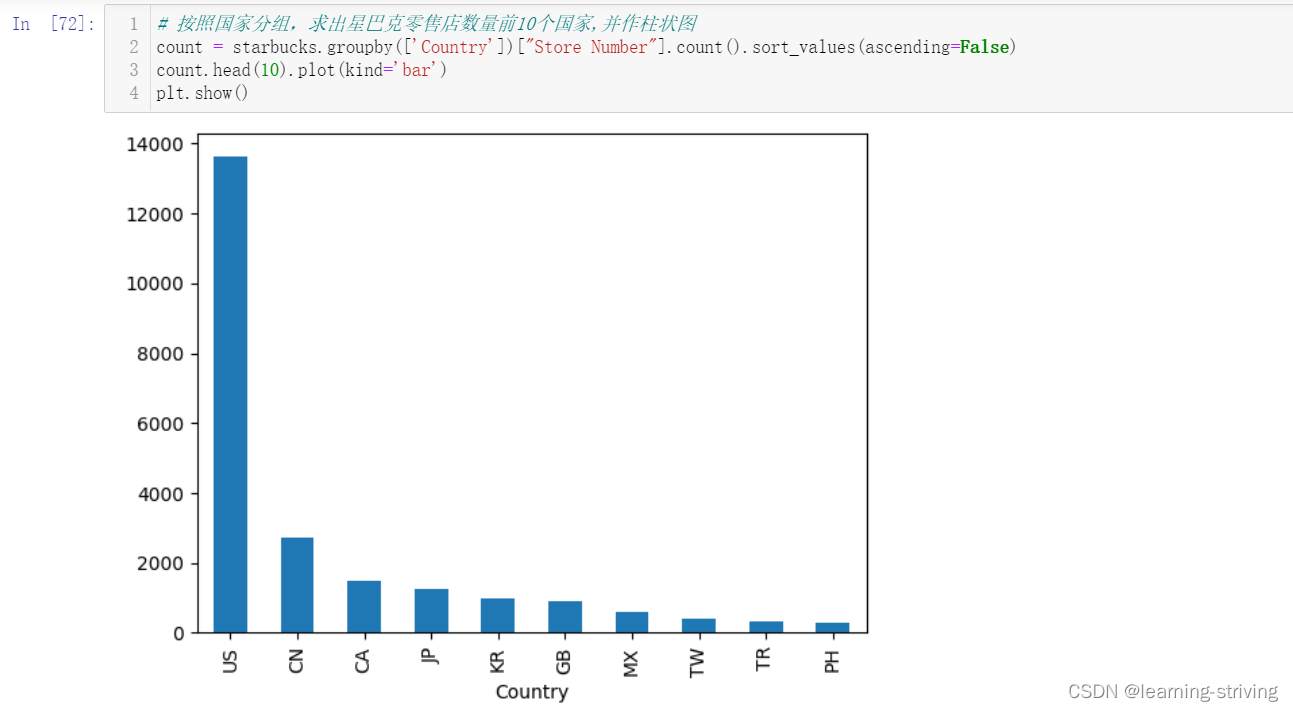

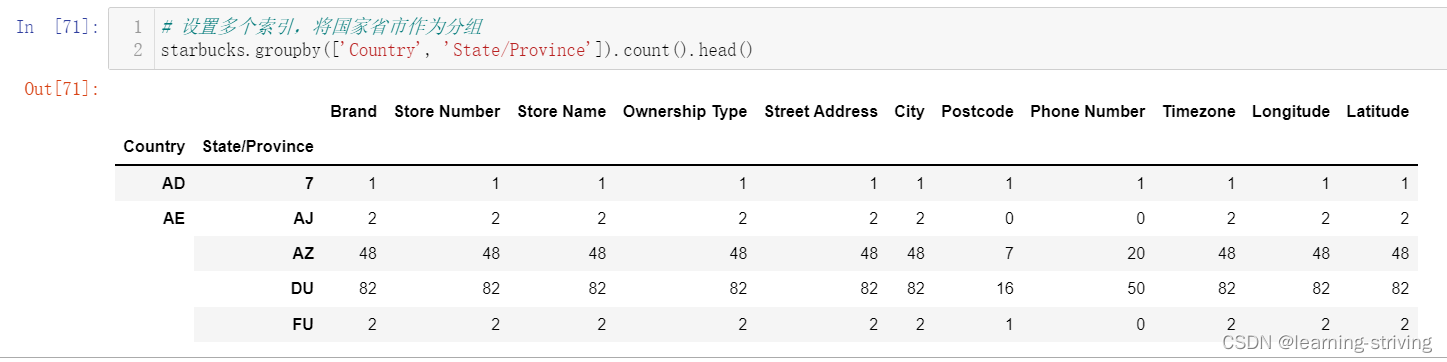

五、星巴克零售店铺数据

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。