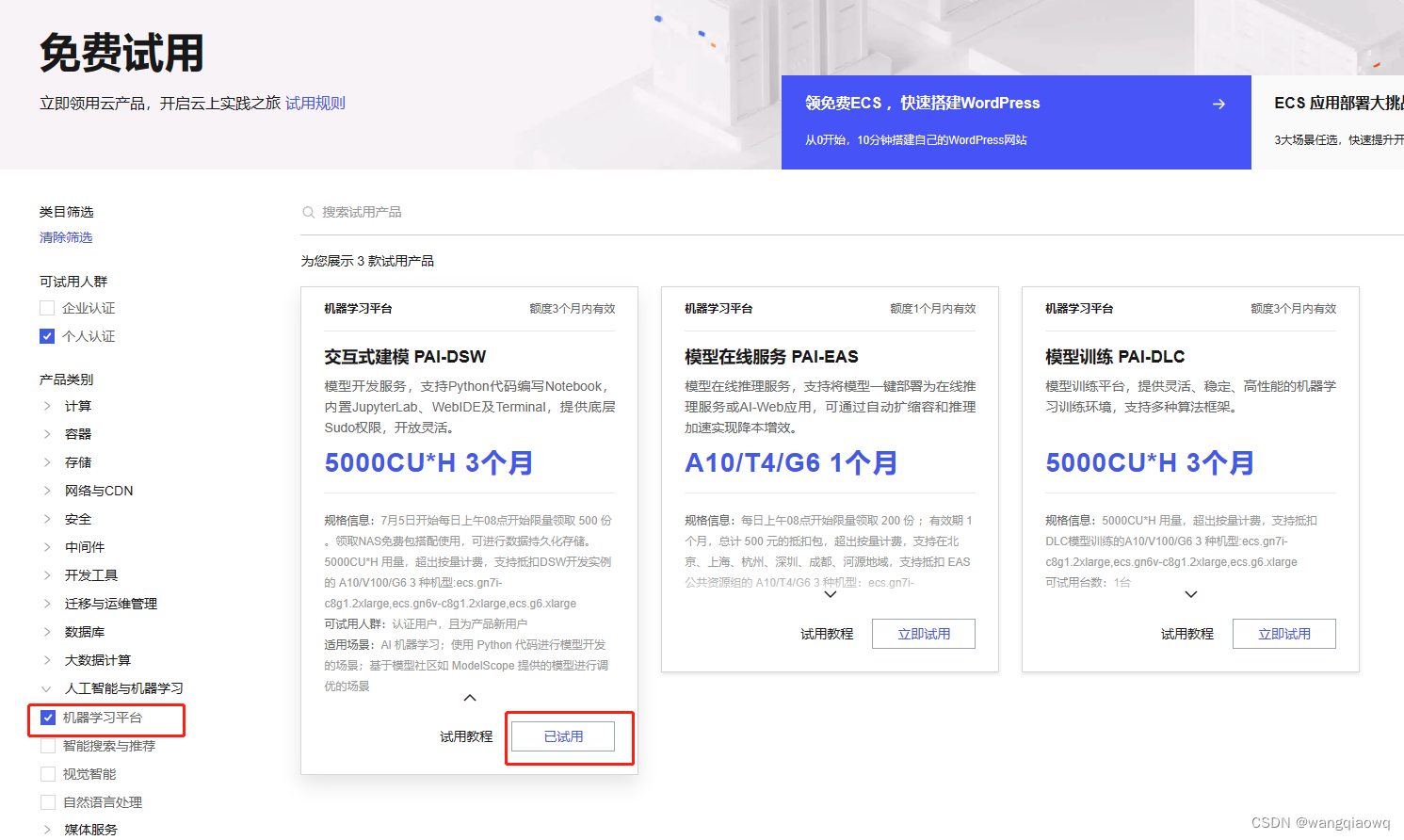

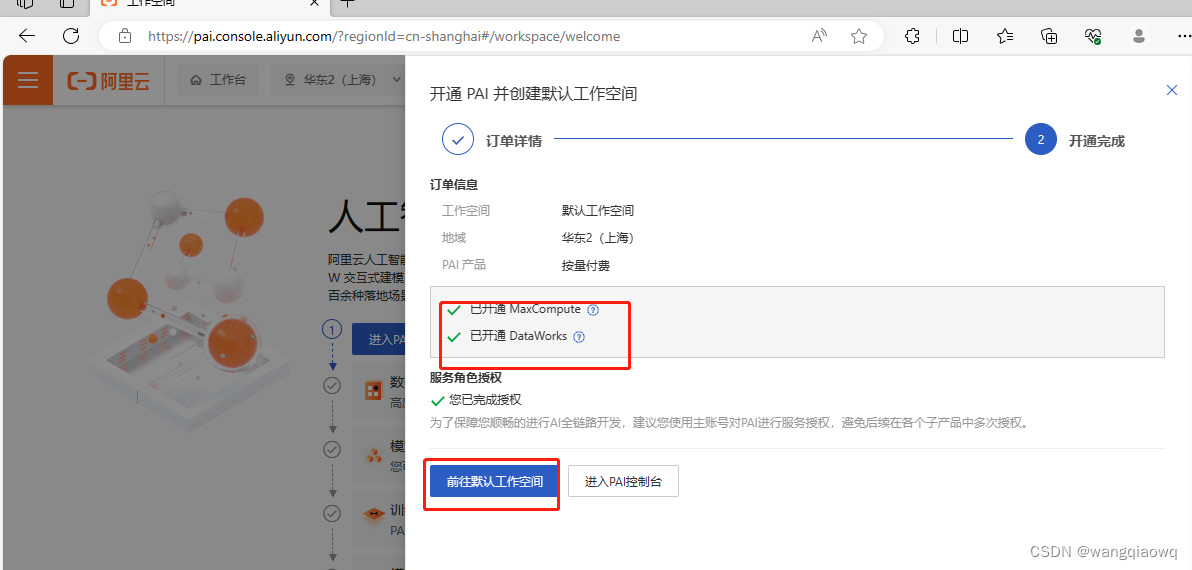

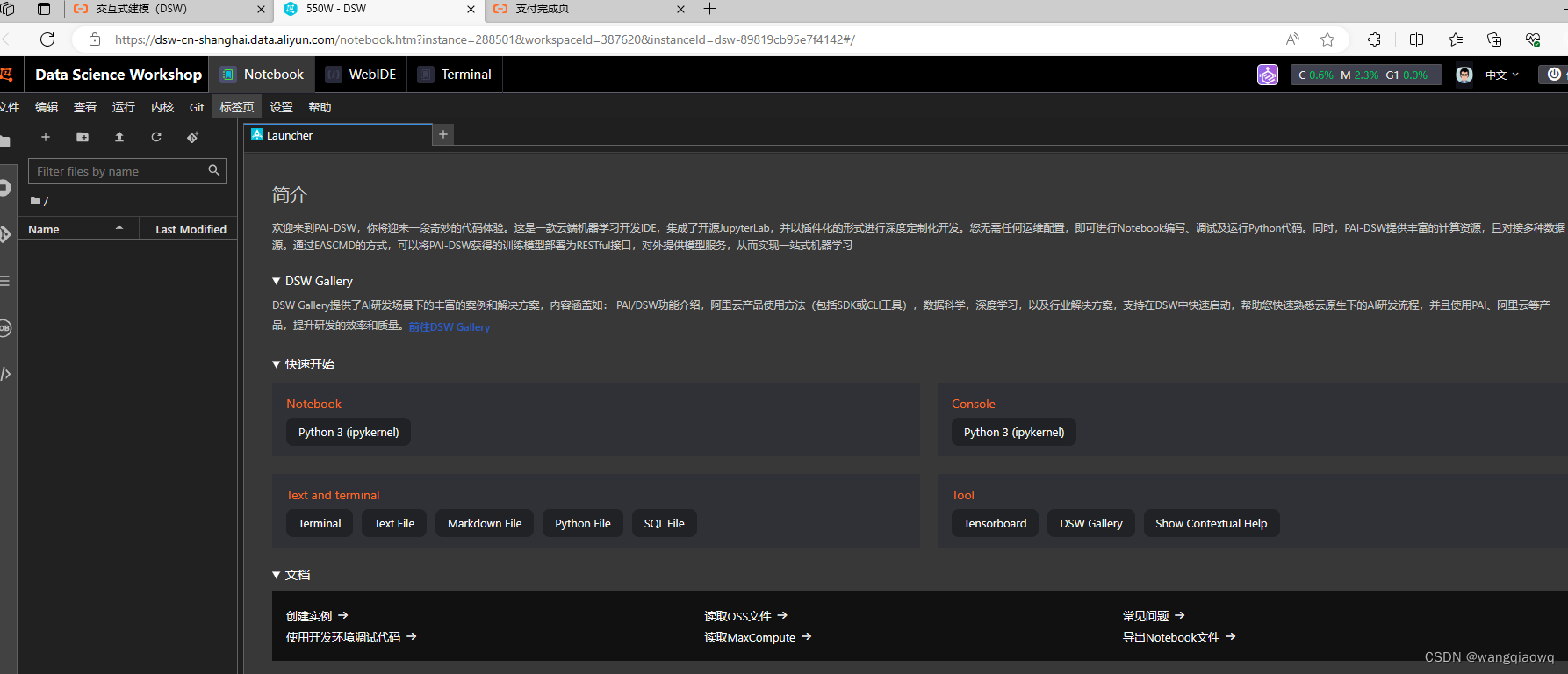

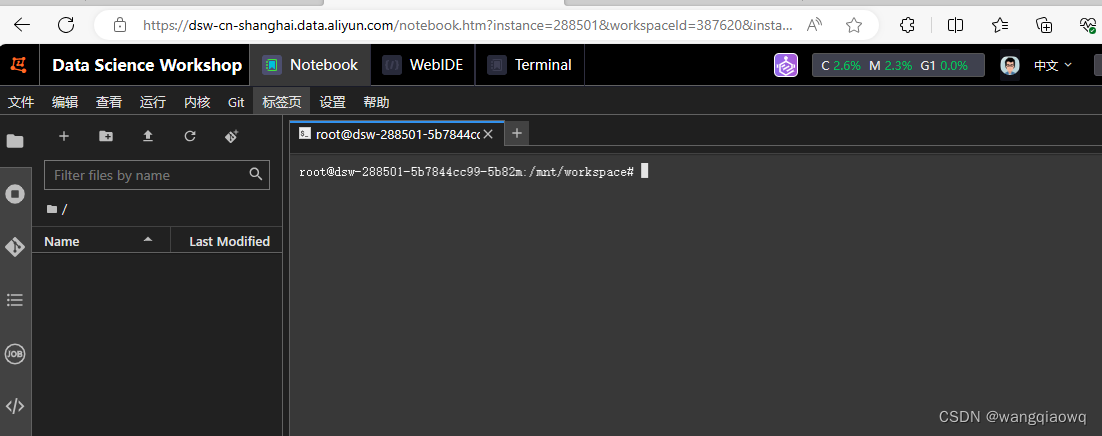

本文介绍: 其他的不支持,这里注意!V100 性能更好,但我们测试使用没必要,就选 A10 就行,A10 显卡每小时消耗6.991计算时,如果不关机持续使用大概可以使用30天。输入实例名称,就叫它 550W 吧~,GPU 选择 A10 或者 V100 都行,我打开的时候只有V100 了 支持资源包抵扣。1、在阿里云上申请注册及登录并完成认证。进入工作空间 宣交互式建模(DSW)2、登录阿里云 免费试用 页面。

参考:【大模型-第一篇】在阿里云上部署ChatGLM3-CSDN博客

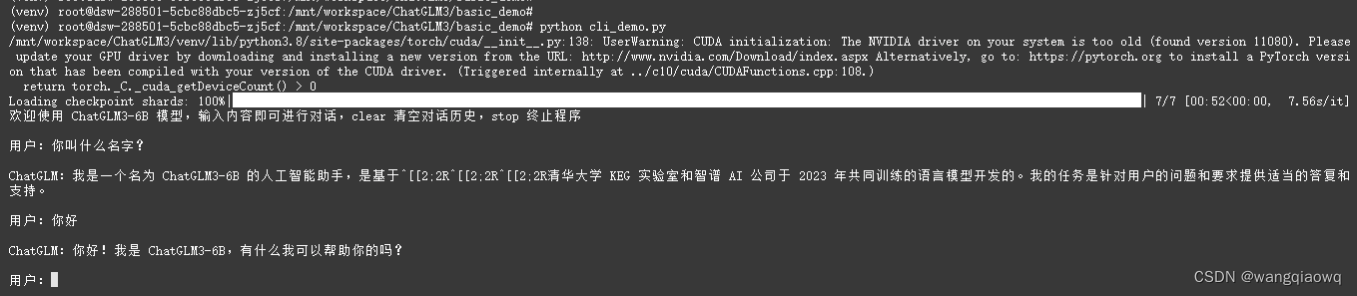

ChatGLM 是一个开源的、支持中英双语的对话语言模型,由智谱 AI 和清华大学 KEG 实验室联合发布,基于 General Language Model (GLM) 架构,具有 62 亿参数。ChatGLM3-6B 更是在保留了前两代模型对话流畅、部署门槛低等众多优秀特性的基础上增加了更多特性。

虽然,目前 ChatGLM 比 GPT 稍有逊色,但是,在部署后可以完全本地运行,完全由自己掌控!

ChatGLM-6B 减少显存与内存占用

全量模型运行加载 GPU运行模式下需要13GB显存+14G内存,CPU运行模式下需要28GB内存,如果你电脑没这么大显存或者内存,可以通过加载量化模型减少显存与内存占用

参考:使用 CPU 本地安装部署运行 ChatGLM-6B 获得自己的专属 AI 猫娘 — 秋风于渭水 (tjsky.net)

硬件与软件准备

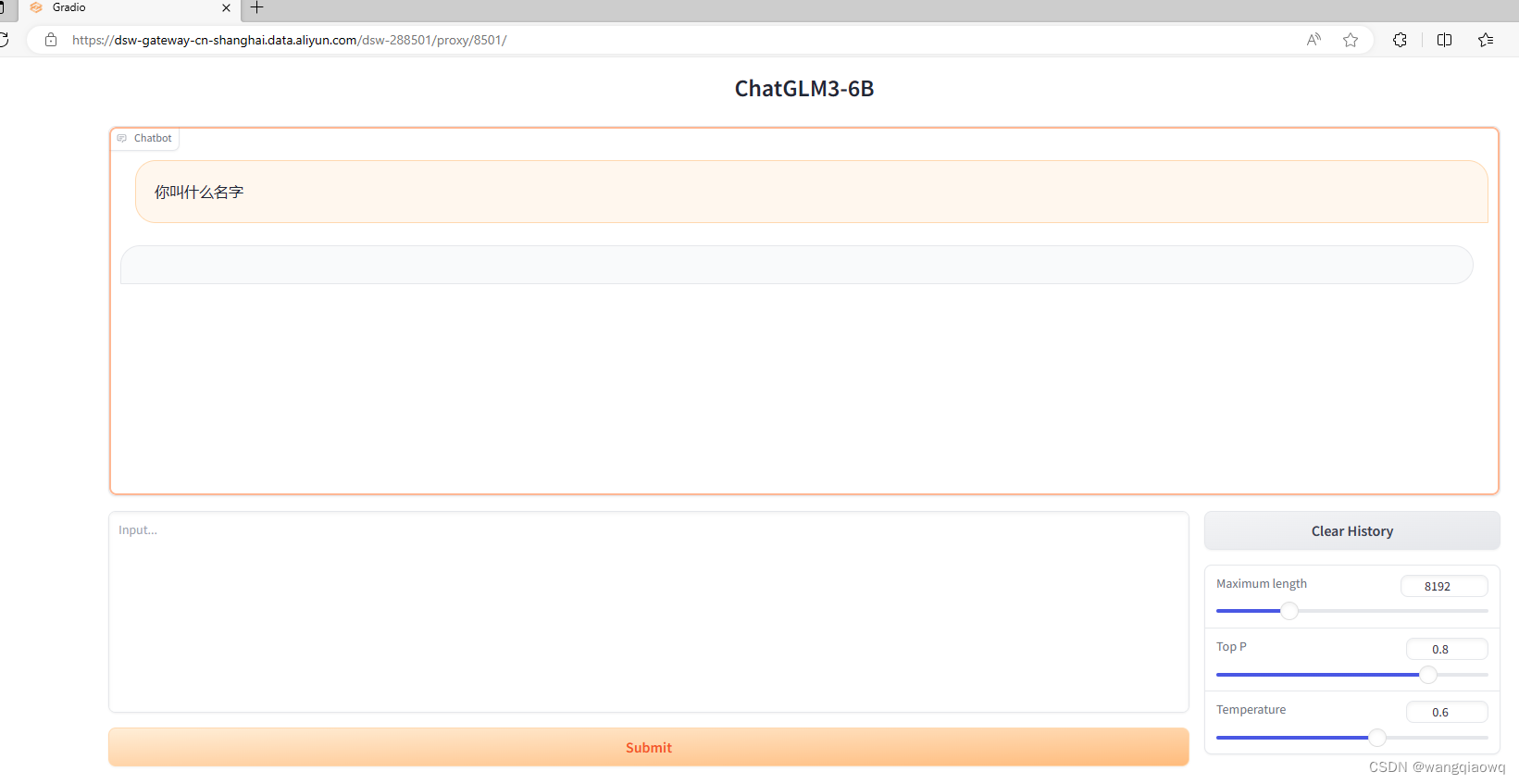

二、部署GLM3

2、git下载GLM3

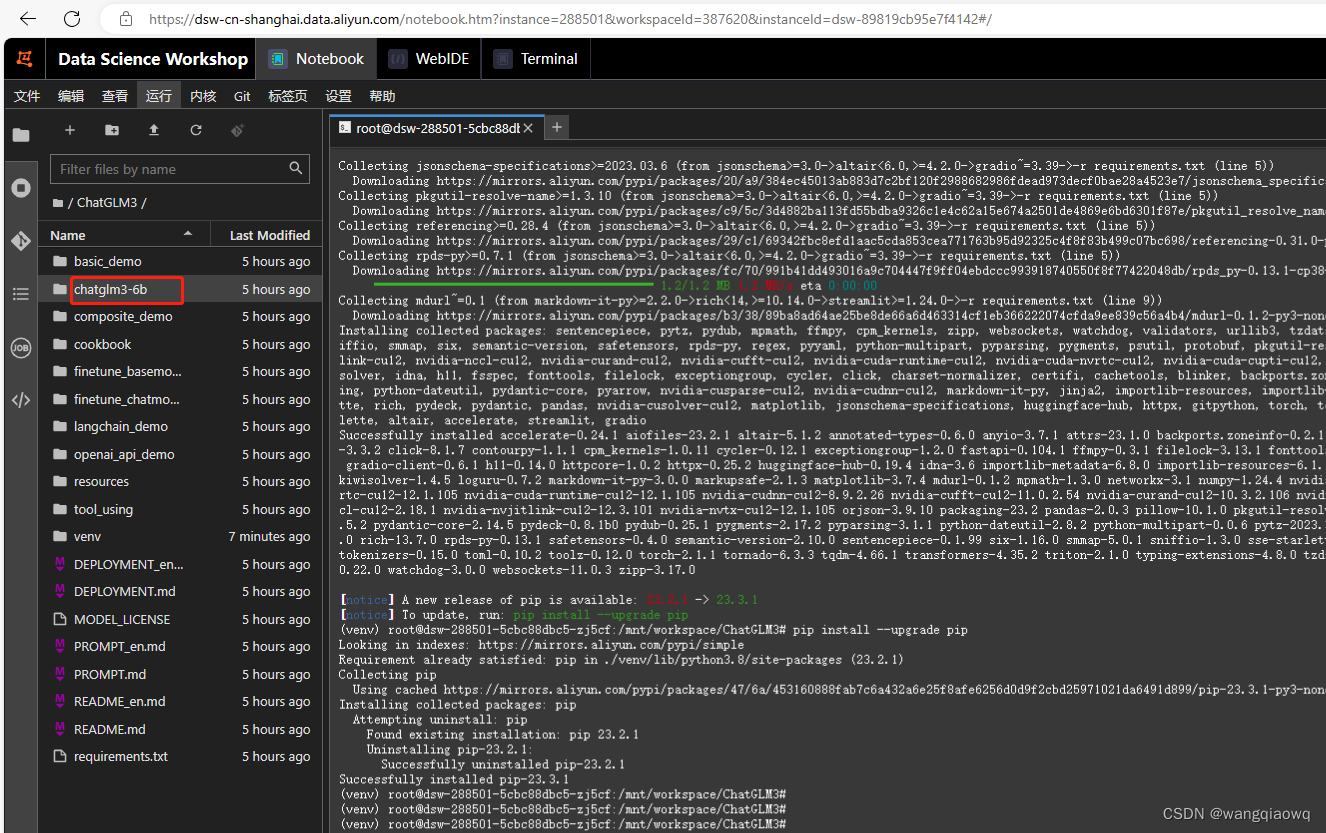

2.1 git clone下载GLM3仓库

2.1.1首先git clone下载GLM3仓库,并切换到这个文件夹下

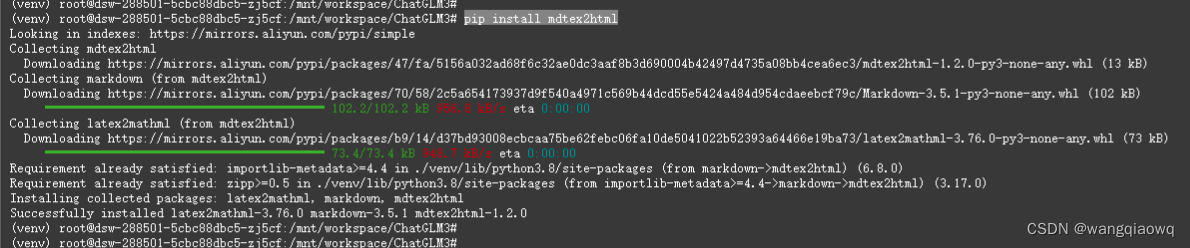

2.1.2 然后使用 pip 安装依赖:

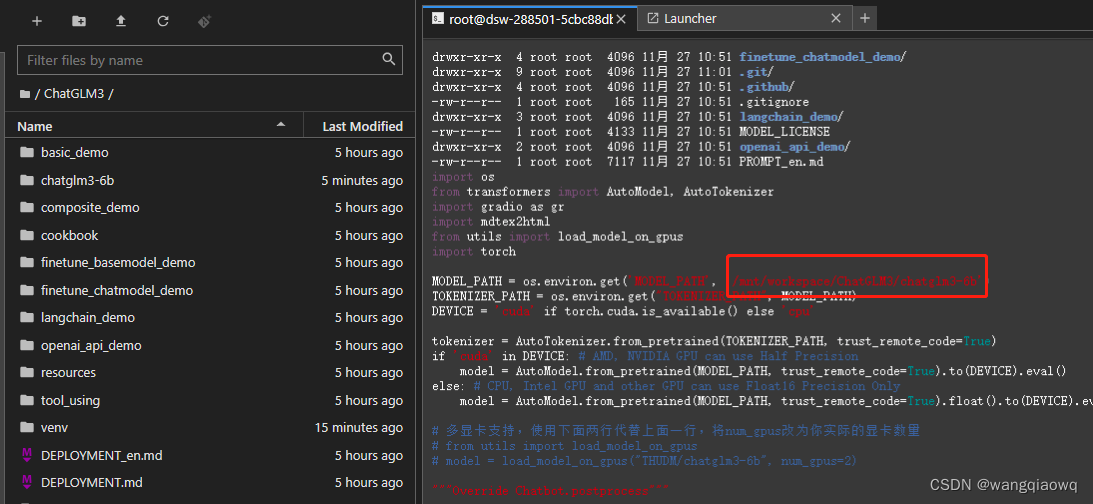

3、修改变量路径并启用

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。