简介

在不断发展的人工智能和机器学习领域,深度学习技术由于其处理复杂和高维数据的能力而获得了巨大的普及。在各种深度学习模型中,堆叠自动编码器[1]作为一种多功能且强大的工具脱颖而出,用于特征学习、降维和数据表示。本文探讨了堆叠式自动编码器在深度学习领域的架构、工作原理、应用和意义。

自动编码器:简要概述

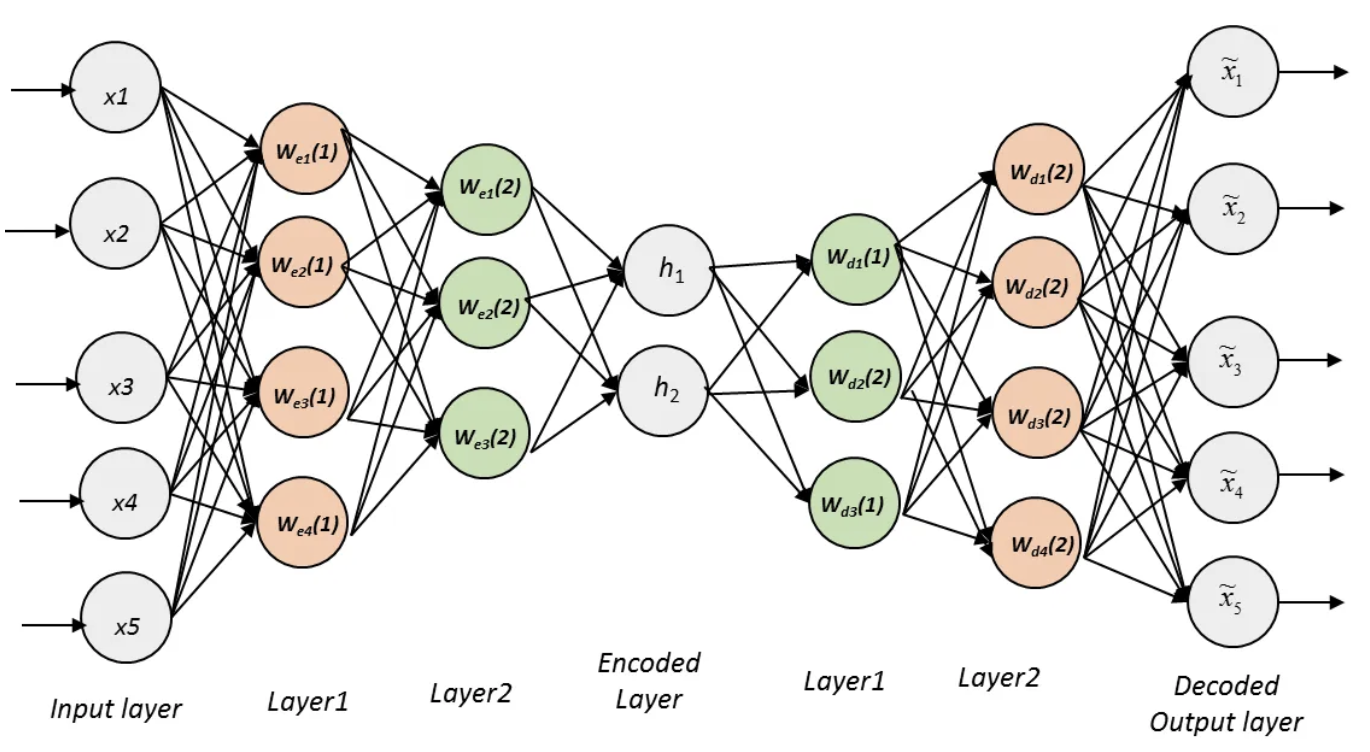

自动编码器的核心是神经网络模型,旨在对数据进行编码和解码,本质上模仿数据压缩和重建的过程。它们由将输入数据映射到低维潜在空间表示的编码器网络和从该表示重建输入数据的解码器网络组成。自动编码器背后的中心思想是学习保留最显着特征的输入数据的压缩表示。这使得它们对于降维、去噪和特征学习等任务非常有用。

单层自动编码器 vs. 堆叠式自动编码器

单层自动编码器虽然对于简单任务有效,但在捕获许多现实世界数据集中存在的复杂和分层特征方面存在局限性。堆叠式自动编码器通过将多层自动编码器级联在一起形成深层架构来解决这一限制。这些层从数据中学习越来越抽象和复杂的特征,从而创建层次表示。本质上,堆叠自动编码器是多层神经网络,旨在捕获数据中复杂的模式和表示。

堆叠式自动编码器的工作原理

-

预训练:堆叠自动编码器的训练过程通常涉及两个阶段。在预训练阶段,每一层都作为单层自动编码器单独训练。此阶段初始化权重和偏差,使网络能够学习有用的特征表示。

-

微调:预训练后,将各层组合起来创建堆叠式自动编码器。然后使用反向传播和梯度下降对网络进行微调,以最小化重建误差,确保有效学习分层特征。

堆叠式自动编码器的应用

-

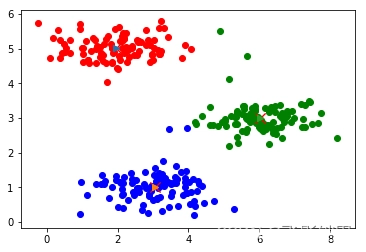

降维:堆叠自动编码器在降低高维数据集的维度方面非常有效,这使得它们在包括图像和文本数据在内的各个领域都很有价值。

-

异常检测:它们可通过重建数据并将其与原始数据进行比较来用于异常检测;差异表明存在异常。

-

图像和语音识别:堆叠式自动编码器已用于图像和语音识别任务,以学习鲁棒的特征表示,从而提高这些系统的性能。

-

自然语言处理:在 NLP 中,这些模型可以学习文本的分布式表示,从而实现更好的语言理解和生成。

-

协同过滤:堆叠自动编码器可以应用于推荐系统,通过学习用户和项目嵌入来提高推荐质量。

意义与挑战

堆叠自动编码器为深度学习做出了巨大贡献,并在推动该领域发挥了至关重要的作用。它们学习分层特征和处理高维数据的能力导致了各种应用的重大突破。然而,挑战仍然存在,例如需要大量标记数据和计算资源来训练深度架构。

Code

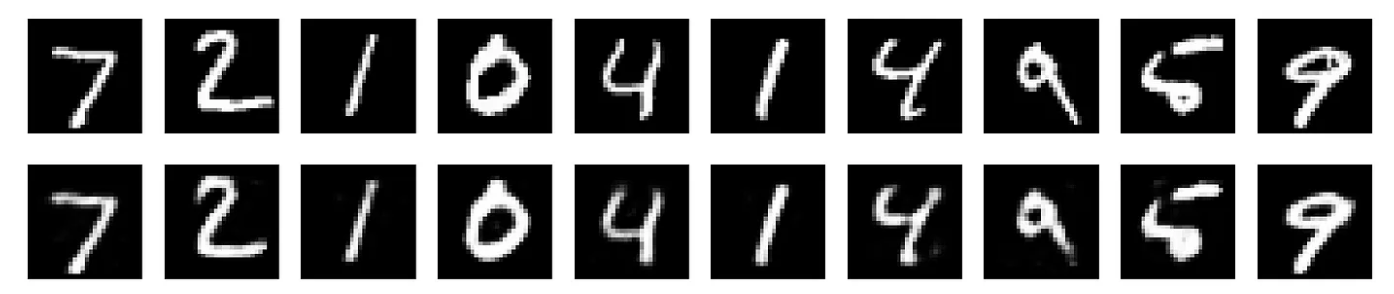

使用数据集和绘图为堆叠式自动编码器创建完整的 Python 代码需要多个库,并且可能会根据您选择的数据集而有所不同。在此示例中,我们将使用 MNIST 数据集,这是图像相关任务的常见选择。我们将在本示例中使用 Keras 和 Matplotlib。

# Import necessary libraries

import numpy as np

import matplotlib.pyplot as plt

from keras.datasets import mnist

from keras.models import Sequential

from keras.layers import Dense

from keras.optimizers import Adam

# Load and preprocess the MNIST dataset

(x_train, _), (x_test, _) = mnist.load_data()

x_train = x_train / 255.0

x_test = x_test / 255.0

# Flatten the data

x_train = x_train.reshape(x_train.shape[0], -1)

x_test = x_test.reshape(x_test.shape[0], -1)

# Define a Stacked Autoencoder model

autoencoder = Sequential()

# Encoder

autoencoder.add(Dense(128, input_shape=(784,), activation='relu'))

autoencoder.add(Dense(64, activation='relu'))

# Decoder

autoencoder.add(Dense(128, activation='relu'))

autoencoder.add(Dense(784, activation='sigmoid'))

# Compile the model

autoencoder.compile(optimizer=Adam(), loss='mean_squared_error')

# Train the autoencoder

autoencoder.fit(x_train, x_train, epochs=10, batch_size=128, shuffle=True, validation_data=(x_test, x_test))

# Plot the original and reconstructed images

decoded_imgs = autoencoder.predict(x_test)

n = 10 # Number of images to display

plt.figure(figsize=(20, 4))

for i in range(n):

# Original Images

ax = plt.subplot(2, n, i + 1)

plt.imshow(x_test[i].reshape(28, 28))

plt.gray()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

# Reconstructed Images

ax = plt.subplot(2, n, i + 1 + n)

plt.imshow(decoded_imgs[i].reshape(28, 28))

plt.gray()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

plt.show()

此代码演示了使用 MNIST 数据集的堆叠自动编码器。在运行此代码之前,您应该安装所需的库(Keras、Matplotlib)。调整模型架构和参数以适合您的特定数据集和任务。

总结

堆叠式自动编码器是一类功能强大的神经网络,它彻底改变了深度学习领域。它们擅长特征学习、降维和数据表示,这使得它们在广泛的应用中具有无价的价值。随着深度学习领域的不断发展,堆叠式自动编码器在释放复杂数据潜力方面的重要性怎么强调也不为过。

Reference

Source: https://medium.com/@evertongomede/unveiling-the-power-of-stacked-autoencoders-675de2ce4273