本文介绍: 爬虫,作为一种自动化从网络上抓取数据的程序,广泛应用于数据分析、信息提取以及竞争对手监控等领域。不同的实现方式和编程语言都能构建出高效的爬虫工具。在本文中,我们将深入介绍如何充分利用Kotlin和Fuel库,构建一个简单而强大的JD.com爬虫,以便迅速获取商品的各种信息,包括名称、价格和评分等。Kotlin是一门基于JVM的静态类型编程语言,以其简洁、高效、安全、跨平台等特点而著称。这门语言不仅适用于Android开发,还可用于服务器端和Web应用程序的开发。

概述

爬虫,作为一种自动化从网络上抓取数据的程序,广泛应用于数据分析、信息提取以及竞争对手监控等领域。不同的实现方式和编程语言都能构建出高效的爬虫工具。在本文中,我们将深入介绍如何充分利用Kotlin和Fuel库,构建一个简单而强大的JD.com爬虫,以便迅速获取商品的各种信息,包括名称、价格和评分等。

Kotlin是一门基于JVM的静态类型编程语言,以其简洁、高效、安全、跨平台等特点而著称。这门语言不仅适用于Android开发,还可用于服务器端和Web应用程序的开发。Fuel库作为一款轻量级的Kotlin HTTP客户端,提供了一套简洁易用的DSL(领域特定语言),使得发送HTTP请求和处理响应变得异常便捷。除此之外,Fuel还支持协程、异步操作、JSON处理以及文件上传等多种功能,以满足各种网络编程需求。

正文

1. 创建项目和添加依赖

首先,我们需要创建一个Kotlin项目,可以使用任何IDE或编辑器,如IntelliJ IDEA、VS Code等。然后,我们需要在项目的build.gradle文件中添加Fuel库的依赖,如下所示:

2. 定义数据类和常量

接下来,我们需要定义一个数据类,用来存储商品的信息,如下所示:

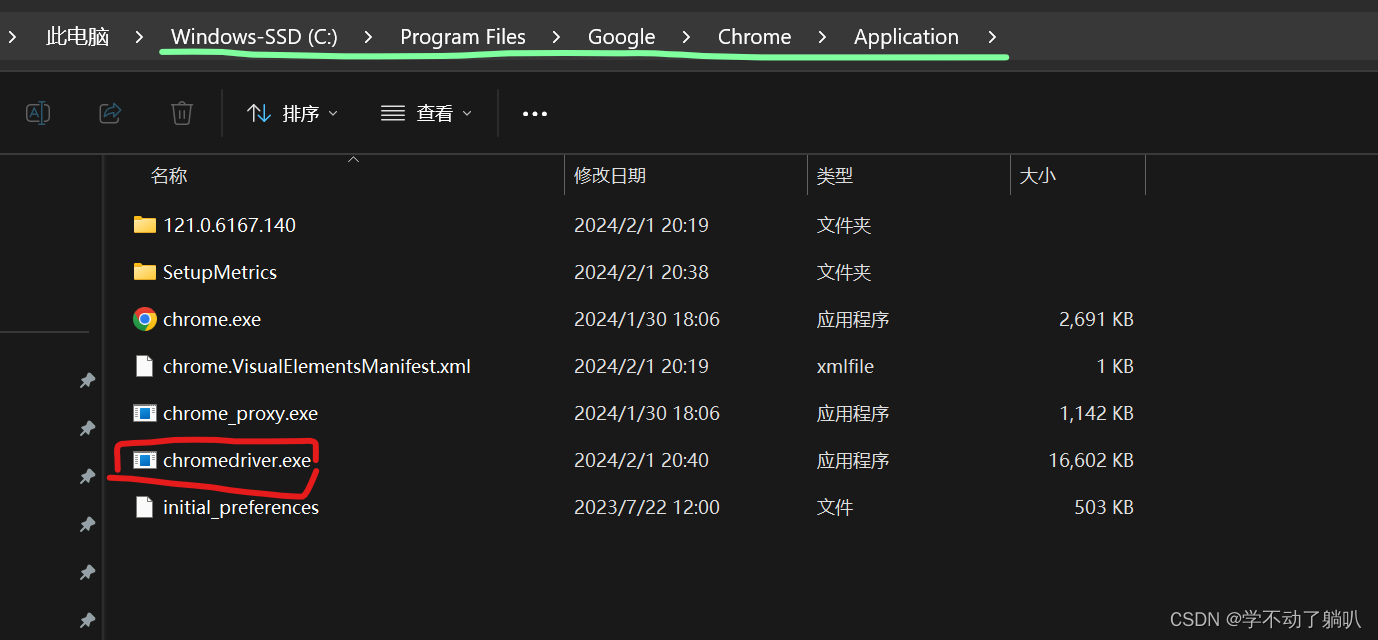

我们还需要定义一些常量,用来表示JD.com的域名、搜索接口、爬虫代理服务器等,如下所示:

3. 发送HTTP请求和解析响应

然后,我们需要编写一个函数,用来发送HTTP请求到JD.com的搜索接口,并解析响应中的商品信息,如下所示:

4. 使用多线程提高采集效率

最后,我们需要编写一个主函数,用来调用上面的函数,并使用多线程提高采集效率,如下所示:

结语

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。