分布式定时任务系列5:XXL-job中blockingQueue的应用

前几天上班的时候,收到运维的告警通知,安装XXL-job的服务器CPU飙高告警,让看一下。

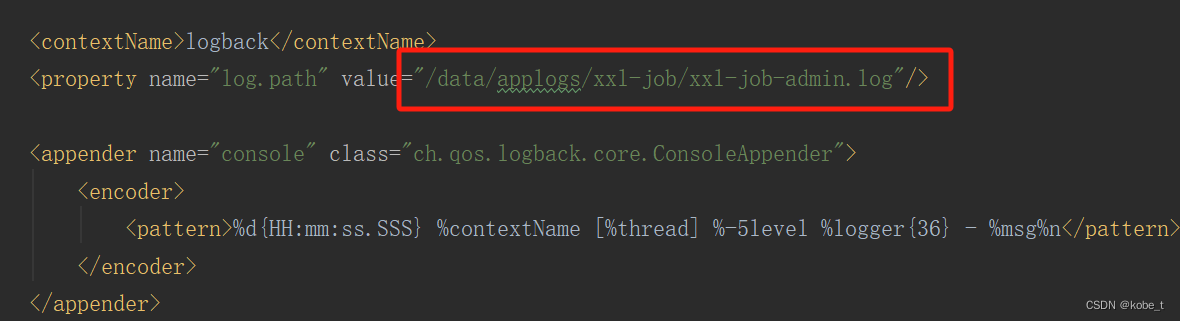

查了下xxl–job–admin的日志文件,目录在logback.xml:

通过讯问得知,有人手动清理过任务,即将无效的任务手动删除了:在xxl–job控制台创建了几个任务,后来业务变更,把代码里面的任务删除了,但是控制台任务没有删除,所以做任务清理。以前面的例子来进行说明

@Component

public class JobHandler {

@XxlJob("first_job")

public void firstJob() {

System.out.println("========================= first job========================= ");

}

}

执行一段时间后,代码中删除first_job,但是控制台任务不删除,执行一段时间后现删除。

但是这个正常的变更操作为什么会引起db出错呢?因为很有可能由于业务变动,先将代码中对应的任务删除的,而后再来清理XXL-job控制台的任务。

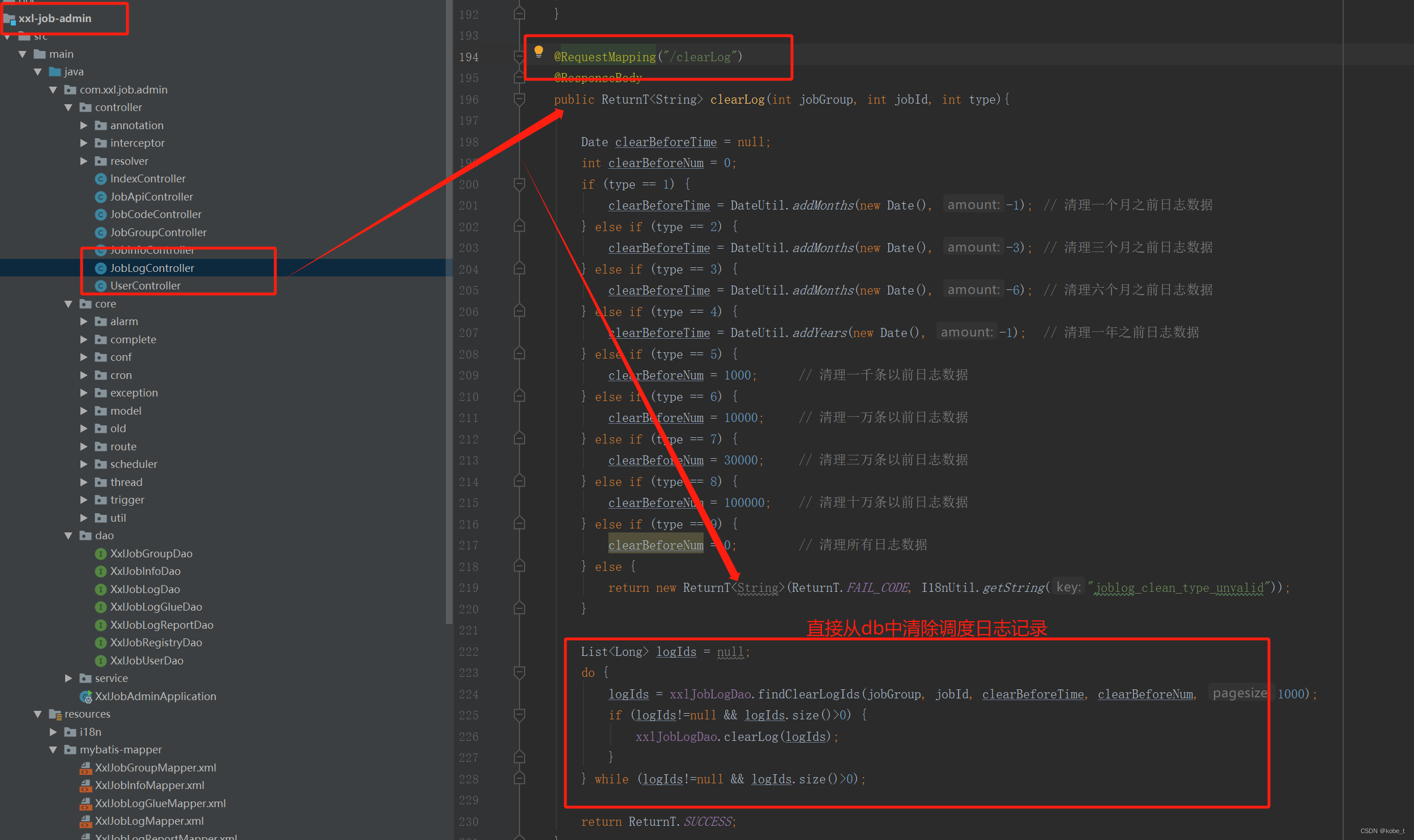

结合报错日志,翻看了一下源码,发现从XXL-job控制台删除任务的逻辑:

<delete id="delete" >

delete from xxl_job_log

WHERE job_id = #{jobId}

</delete>

可以通过看源码,看出它是根据界面选择的清理策略,发起一个http同步请求,做循环删除,也是比较粗暴:

原文地址:https://blog.csdn.net/weigeshikebi/article/details/134603531

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_13653.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!