本文介绍: 性能测试工具,可以在自己本子运行,看看自己本子性能如何:修复有问题的AOF文件,rdb和aof后面讲:修复有问题的dump.rdb文件:Redis集群使用:Redis服务器启动命令redis–cli:客户端,操作入口。

☆ redis之安装部署

☆ redis之基本使用

☆ redis之应用场景

☆ redis之源码制作rpm包

1、redis-6.2.12单机部署

1.1、redis-6.2.12下载安装

安装文档:https://redis.io/docs/getting-started/installation/install-redis-from-source/

下载地址:https://github.com/redis/redis

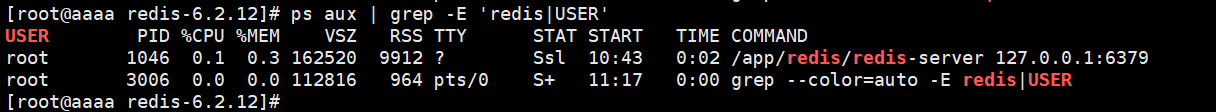

1.2、查看服务进程

2、redis-6.2.12主从+哨兵部署

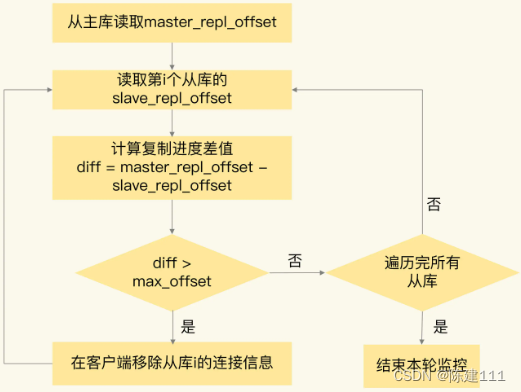

1、Slave启动成功连接到master后会发送一个sync命令

2、Master接到命令启动后台的存盘进程,同时收集所有接收到的用于修改数据集命令,

3、在后台进程执行完毕之后,master将传送整个数据文件到slave,以完成一次完全同步

4、全量复制:而slave服务在接收到数据库文件数据后,将其存盘并加载到内存中。

5、增量复制:Master继续将新的所有收集到的修改命令依次传给slave,完成同步

6、但是只要是重新连接master,一次完全同步(全量复制)将被自动执行

3、redis-6.2.12Cluster部署

1、Redis群集TCP端口

每个Redis群集节点都需要打开两个TCP连接。

1)用于为客户端提供服务的普通Redis命令执行端口,例如6379。

2)集群总线端口偏移是固定的,始终为10000,例如16379。(该端口用于集群总线,即使用二进制协议的节点到节点通信通道。节点使用集群总线进行故障检测,配置更新,故障转移授权等。客户端永远不应尝试与群集总线端口通信,但始终使用正常的Redis命令端口,但请确保在防火墙中打开两个端口,否则Redis群集节点将无法通信。)

1、Redis群集数据分片

4、redis提供的命令及工具

5、redis配置文件

6、redis的数据淘汰策略

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。