本文介绍: 工作原理:TextRank 使用基于图的算法来提取文本中最重要的句子或短语,这些句子或短语组成了文本的摘要。它主要基于共现关系计算节点(句子或短语)的权重,然后选择具有高权重的节点来构建摘要。BERT 是一种深度学习模型,可以学习文本的语义表示。智能摘要通常通过微调预训练的BERT模型来生成,BERT 在理解文本语义方面具有卓越的性能。它不仅可以提取关键信息,还可以生成更具语义的摘要。性能:TextRank 是一种传统的文本处理方法,性能通常取决于共现关系的质量和权重计算的准确性。

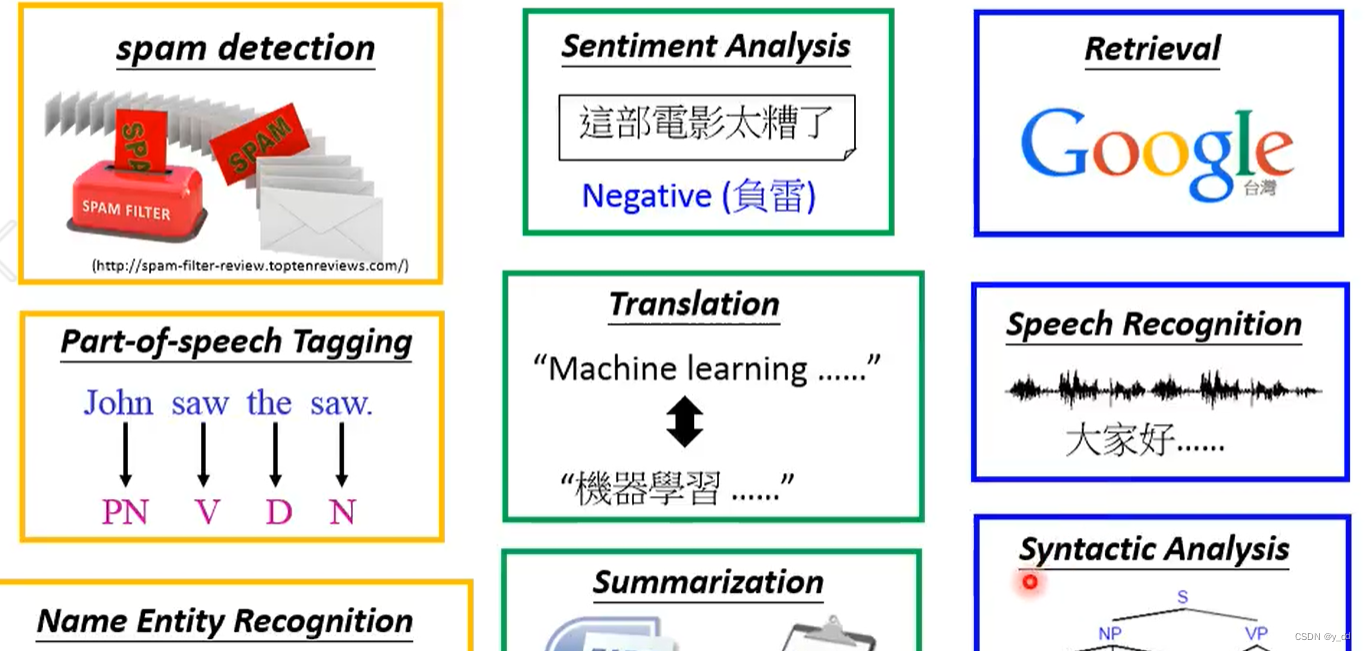

NLP基本知识

词嵌入&词向量

词嵌入(Word Embedding)是一种将单词或文本转化为向量表示的技术,它在自然语言处理(NLP)中广泛应用。词嵌入的目标是将文本数据映射到一个低维度的向量空间中,以便计算机可以更好地理解和处理文本信息。这些向量表示使得文本数据在数学上更易于处理,并且可以用于各种NLP任务,如文本分类、情感分析、机器翻译等。

词嵌入是NLP中的基本概念,它为文本数据提供了更具信息量和数学表达能力的表示形式,使得计算机可以更好地理解和处理文本信息。这对于许多自然语言处理任务至关重要。

对比学习

对比学习(Contrastive Learning)是一种机器学习方法,用于学习表示(representation learning)或特征,其核心思想是通过比较两个或多个样本的相似性来进行训练。在对比学习中,模型被要求将相似的样本映射到接近的点,而将不相似的样本映射到远离的点,从而使得相似性在表示空间中更加明确可见。

对比学习的主要应用包括图像、文本、语音等领域,以下是对比学习的一些关键概念和应用:

总之,对比学习是一种强大的表示学习方法,它可以帮助模型从数据中学习更具信息量的特征表示,特别适用于许多无监督或自监督学习任务。它已在计算机视觉、自然语言处理和语音处理等领域取得了重要的进展。

置信学习

抗噪训练

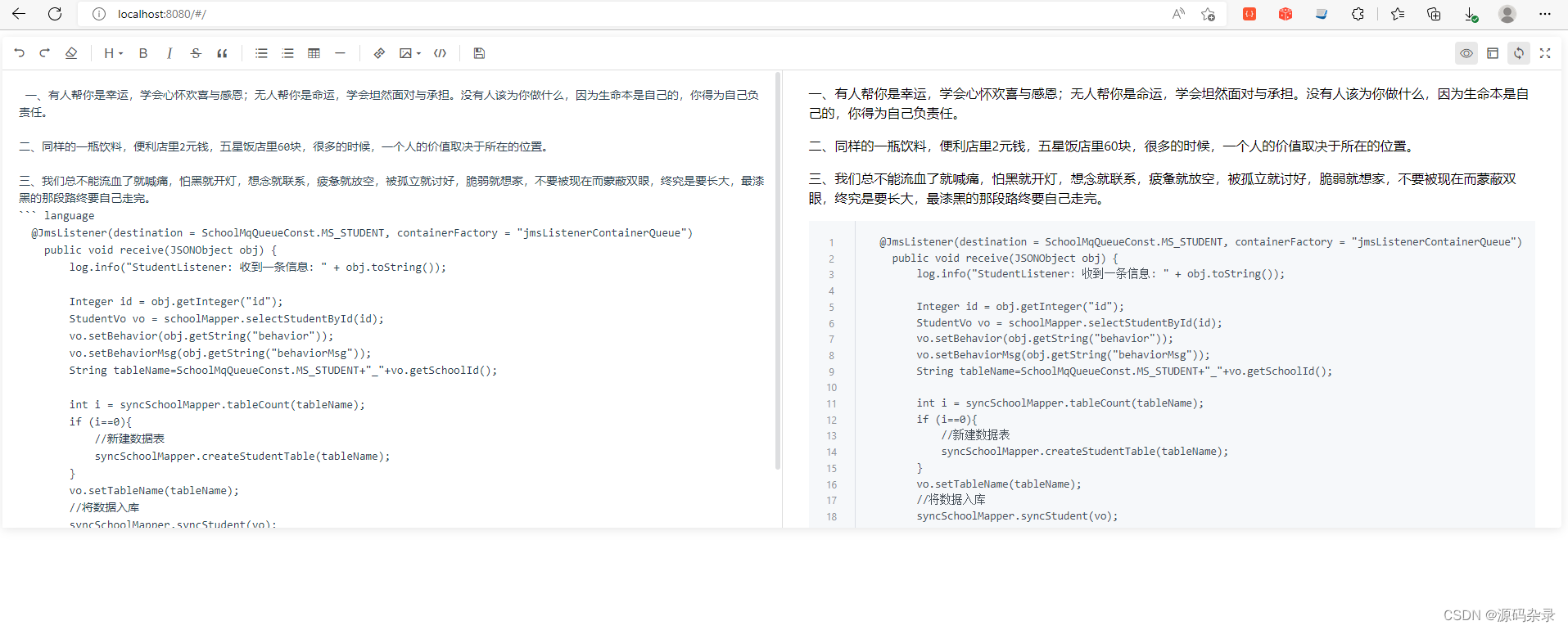

TextRank

TextRank的文本摘要和BERT的智能摘要区别

增量学习

在线学习

在线学习和增量学习区别

BERT学习

BERT的词嵌入

BERT应用

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。