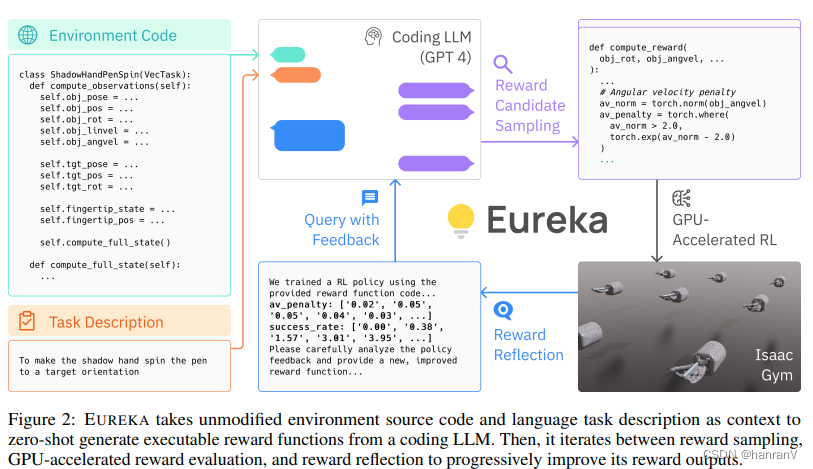

本文介绍: 大型语言模型(LLMs)在顺序决策任务中作为高级语义规划器表现出色。然而,利用它们来学习复杂的低级操控任务,例如灵巧的笔旋转,仍然是一个未解决的问题。我们弥补了这一基本差距,并提出了Eureka,这是一个由LLMs驱动的人类水平奖励设计算法。Eureka利用了最新LLMs的卓越能力,如零样本生成、代码编写和上下文中的改进,来执行奖励代码的进化优化。生成的奖励可以通过强化学习用于获取复杂技能。Eureka在没有任何特定任务提示或预定义奖励模板的情况下,生成了优于专家人工设计奖励的奖励函数。

一、论文速读

1.1 摘要

1.2 论文概要总结

相关工作

主要贡献

论文主要方法

实验数据

未来研究方向

二、论文精度

2.1 论文试图解决什么问题?

2.2 论文中提到的解决方案之关键是什么?

2.3 用于定量评估的数据集是什么?代码有没有开源?

2.4 这篇论文到底有什么贡献?

2.5 下一步呢?有什么工作可以继续深入?

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。