场景

一张手工维护的内部表,本来排查没有使用,然后删掉了,发现又需要使用,只能恢复这张表了。

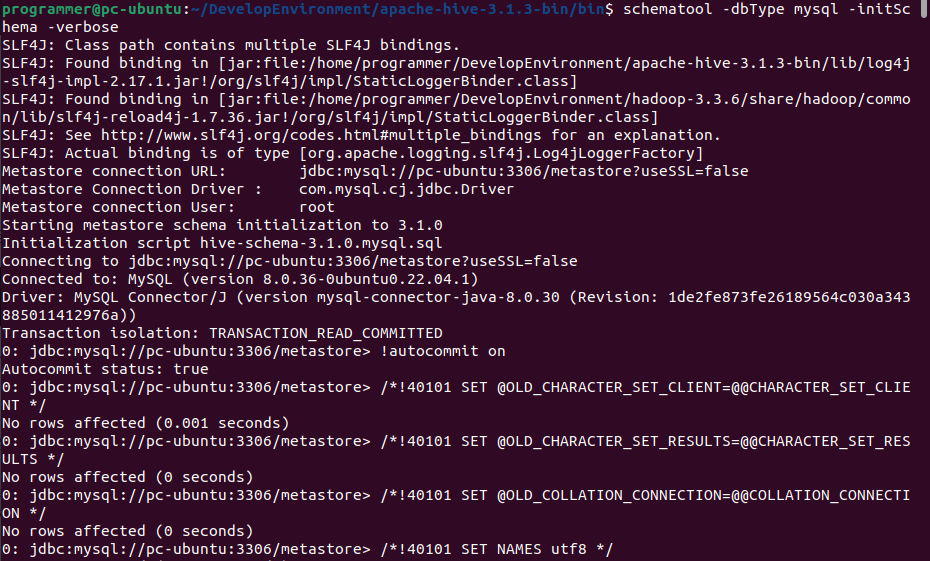

1.确认HDFS是否开启回收站功能

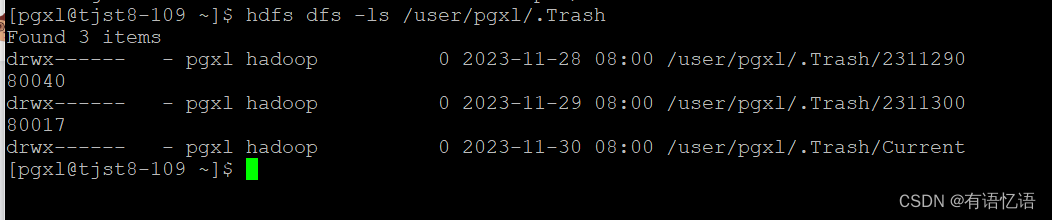

2.查看回收站中的数据

被删除的数据会放在删除数据时使用的用户目录下,如:使用pgxl删除的,那么删除的数据会放在如下目录:

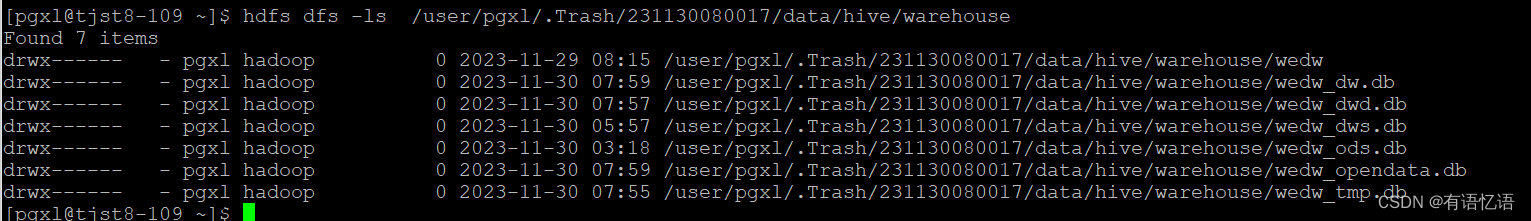

该目录下会有多个文件夹,每小时删除的数据放在不同文件夹下,目录如下:

3.将回收站的数据移动回表目录下

hive表数据存放的具体位置得看项目中hive的配置,默认放在/user/hive/warehouse下。公司生成环境放在/data下。

[pgxl@tjst8-109 ~]$ hdfs dfs -mv /user/pgxl/.Trash/231130080017/data/hive/warehouse/wedw_dw.db/yyf_styy_txynhis_record_settle_bill_detail_df/* /data/hive/warehouse/wedw_dw.db/yyf_styy_txynhis_record_settle_bill_detail_df/

4.将metastore的分区信息重新写入metastore

通过hdfs dfs –put或者hdfs api写入hive分区表的数据在hive中是无法被查询到的,因为这部分数据的元数据信息没有同步到metastore。如:

spark-sql> select count(1) from wedw_dw.yyf_styy_txynhis_record_settle_bill_detail_df;

0

可使用MSCK REPAIR TABLE命令重新检查一张表的元数据信息。

spark-sql> msck repair table wedw_dw.yyf_styy_txynhis_record_settle_bill_detail_df;

spark–sql> select count(1) from wedw_dw.yyf_styy_txynhis_record_settle_bill_detail_df;

1323423

原文地址:https://blog.csdn.net/qq_44696532/article/details/134715158

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_18387.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。