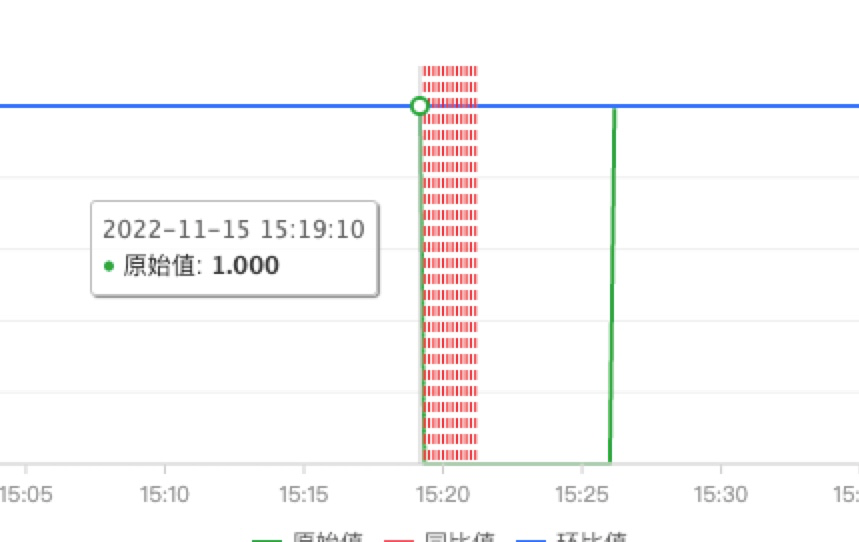

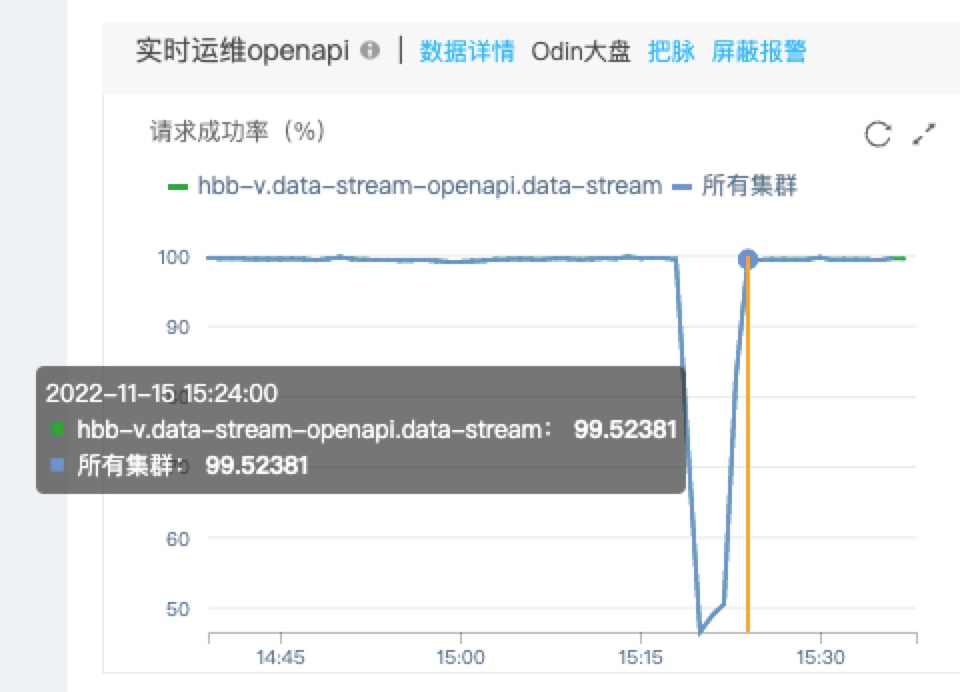

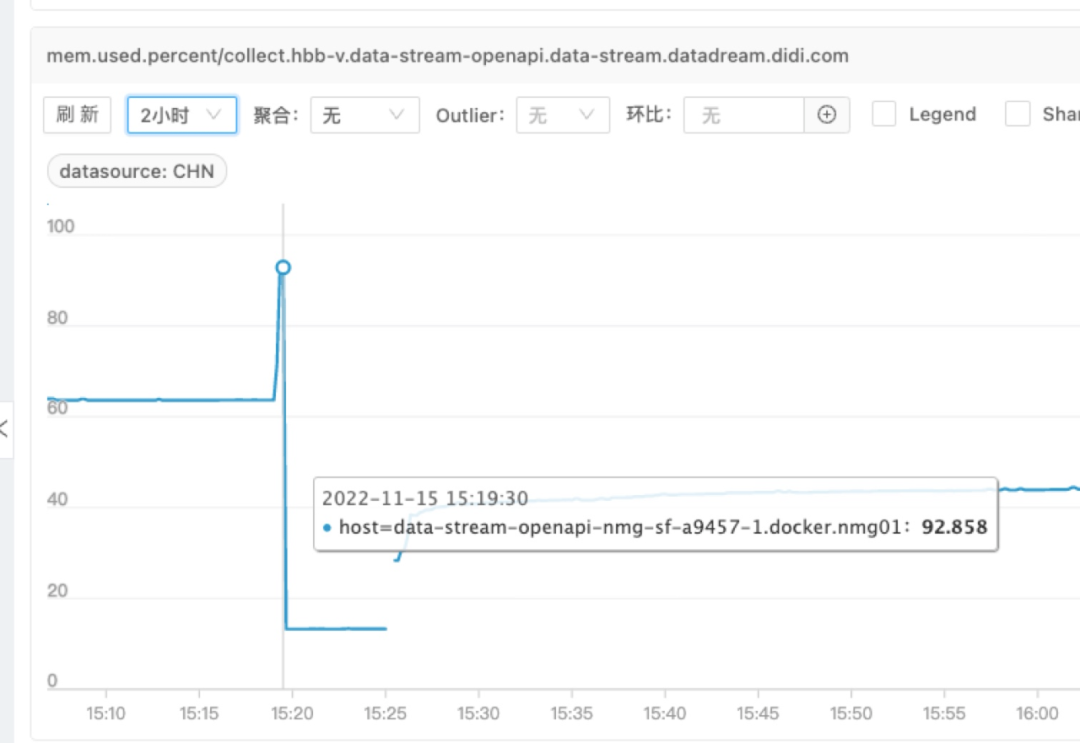

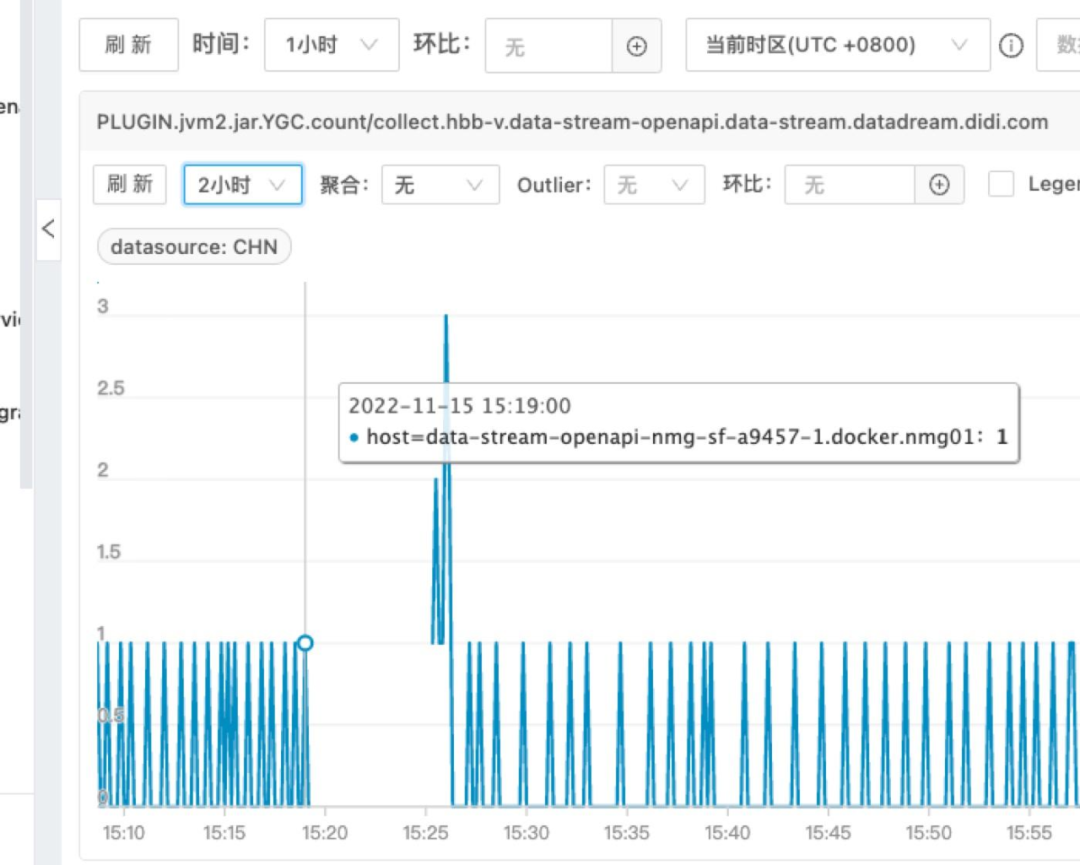

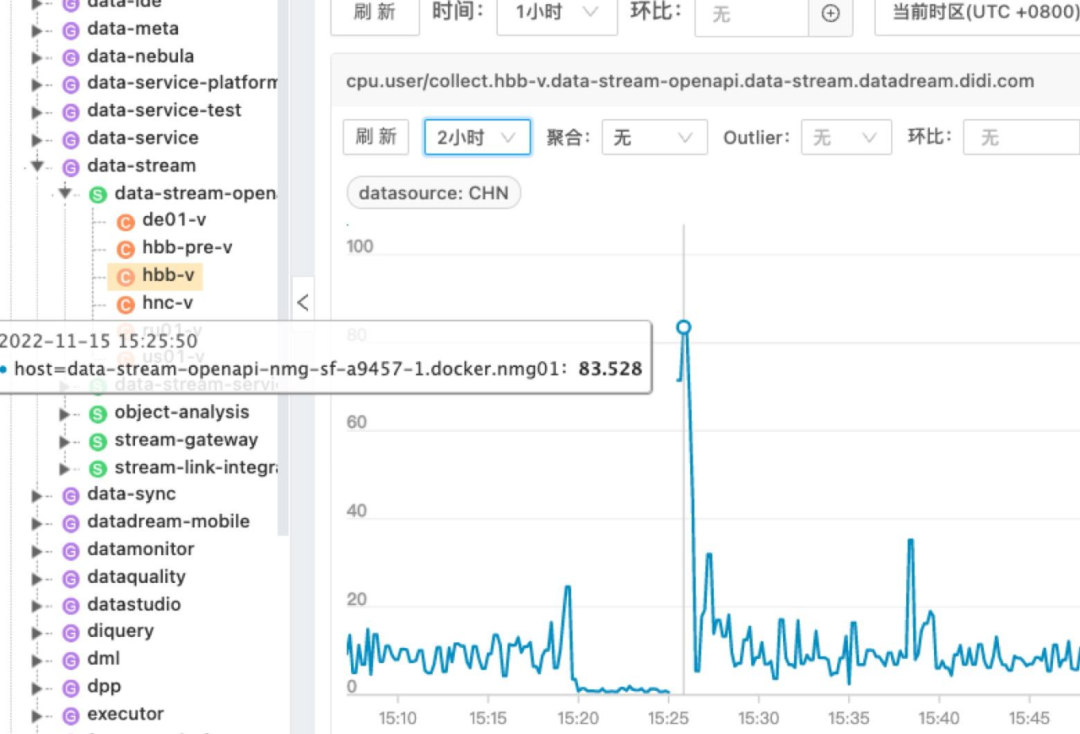

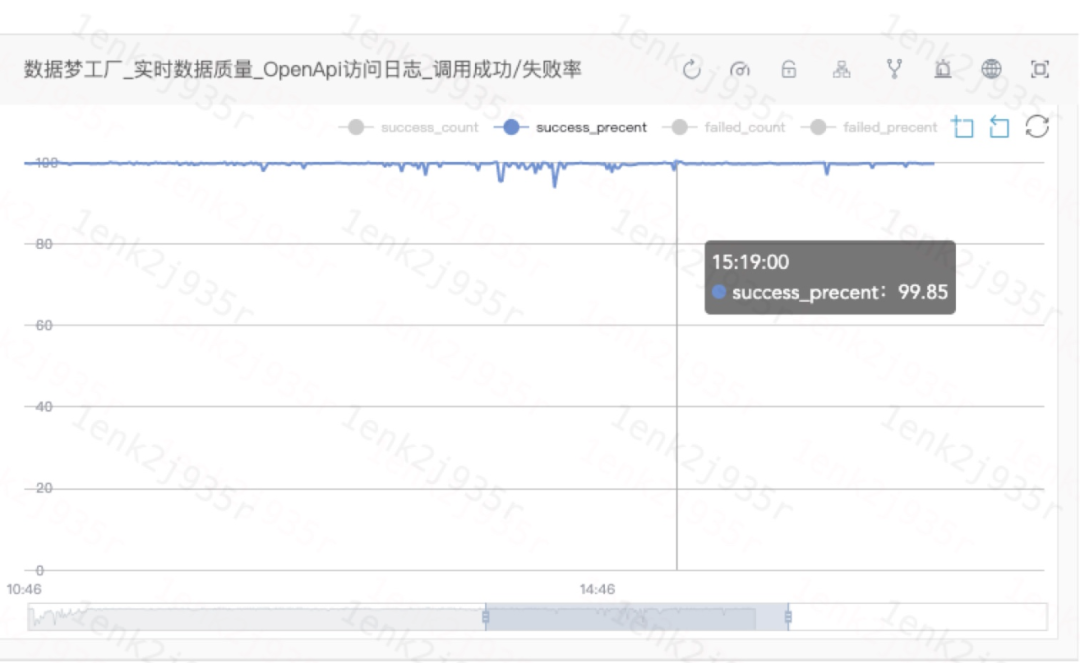

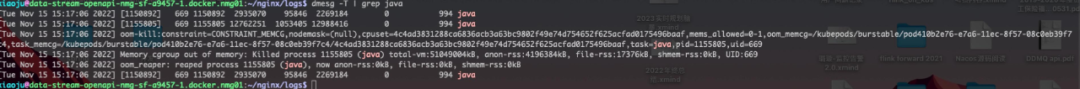

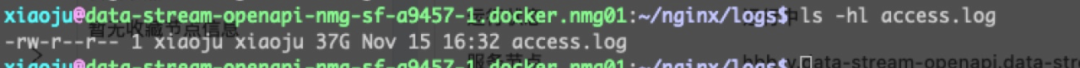

本文介绍: 一次端口告警,发现 java 进程被异常杀掉,而根因竟然是因为在问题机器上 vim 查看了 nginx 日志。下面我将从时间维度详细回顾这次排查,希望读者在遇到相似问题时有些许启发。时间线15:19 收到端口异常 odin 告警。状态:P1故障名称:应用端口8989指标:data–stream–openapi.port.8989主机:data–stream–openapi-nmg–sf-a9…

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。