一、Spark广播变量和累加器

1、广播变量

1)、广播变量理解图

2)、广播变量使用

3)、注意事项

不能,因为RDD是不存储数据的。可以将RDD的结果广播出去。

广播变量只能在Driver端定义,不能在Executor端定义。

在Driver端可以修改广播变量的值,在Executor端无法修改广播变量的值。

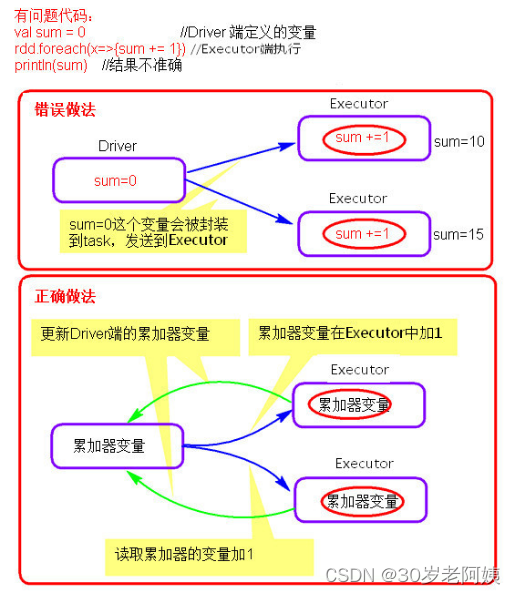

2、累加器

1)、累加器理解图

2)、累加器的使用

3)、注意事项

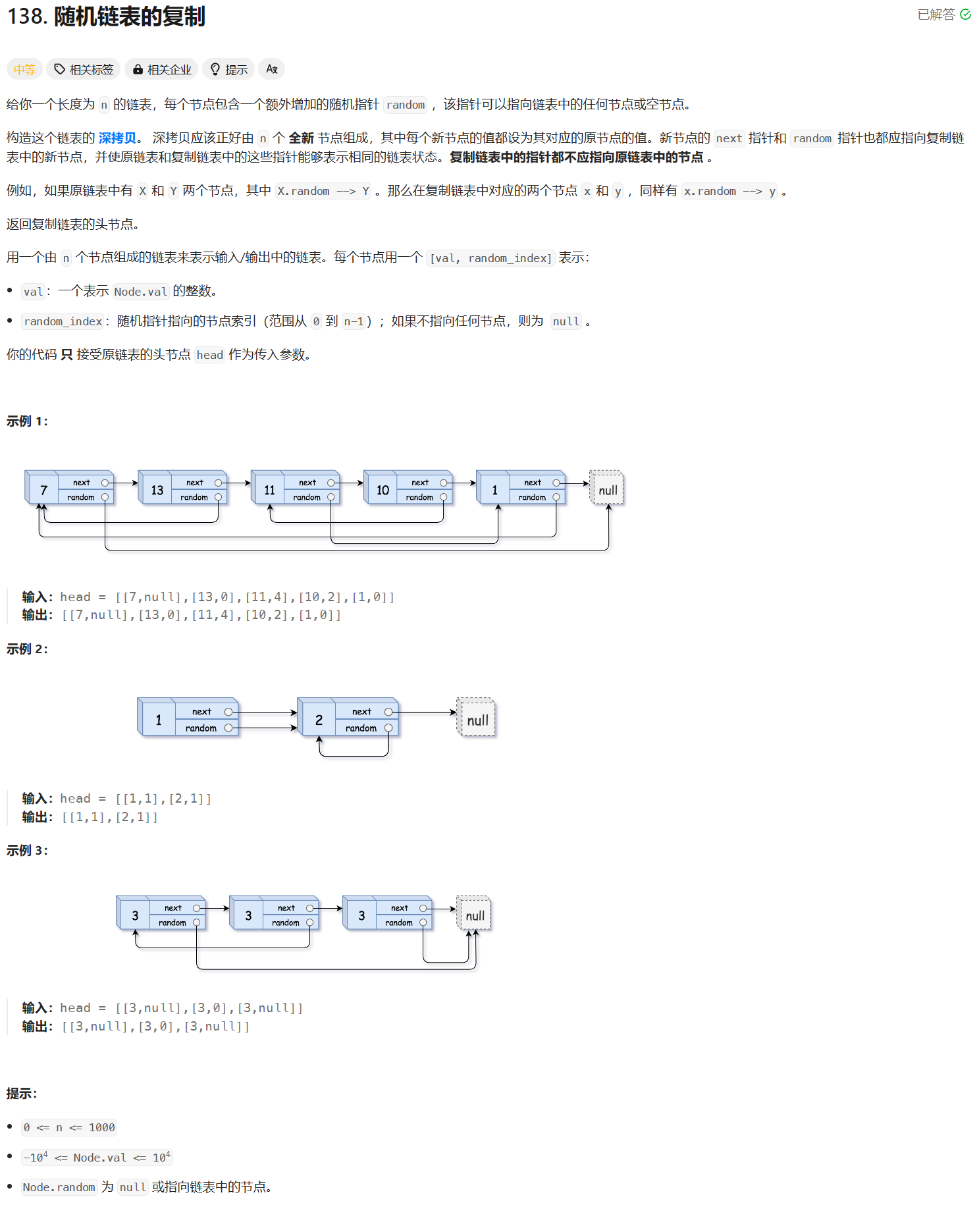

二、Spark weibui界面

1、SparkUI界面介绍

2、配置historyServer

1)、临时配置,对本次提交的应用程序起作用

2)、spark–default.conf配置文件中配置HistoryServer,对所有提交的Application都起作用

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。