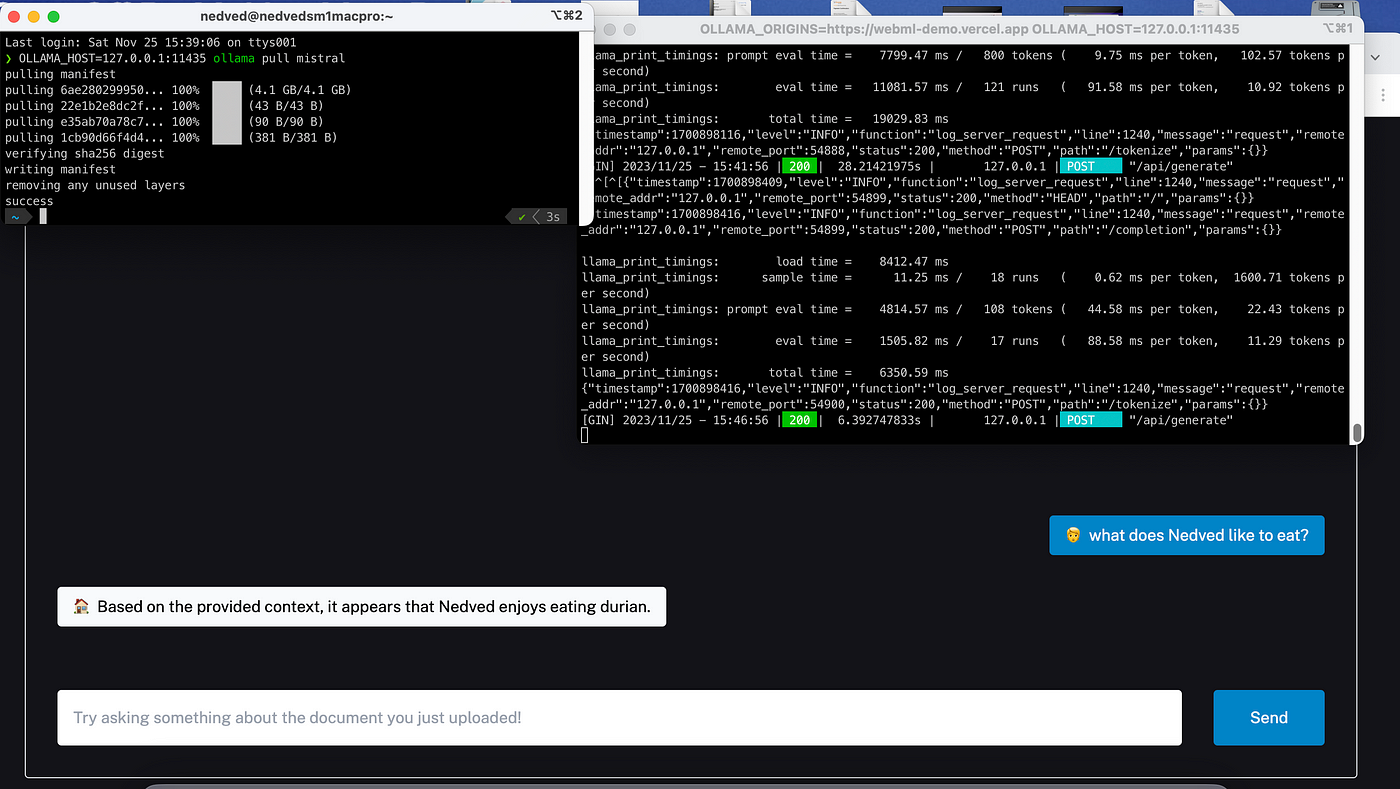

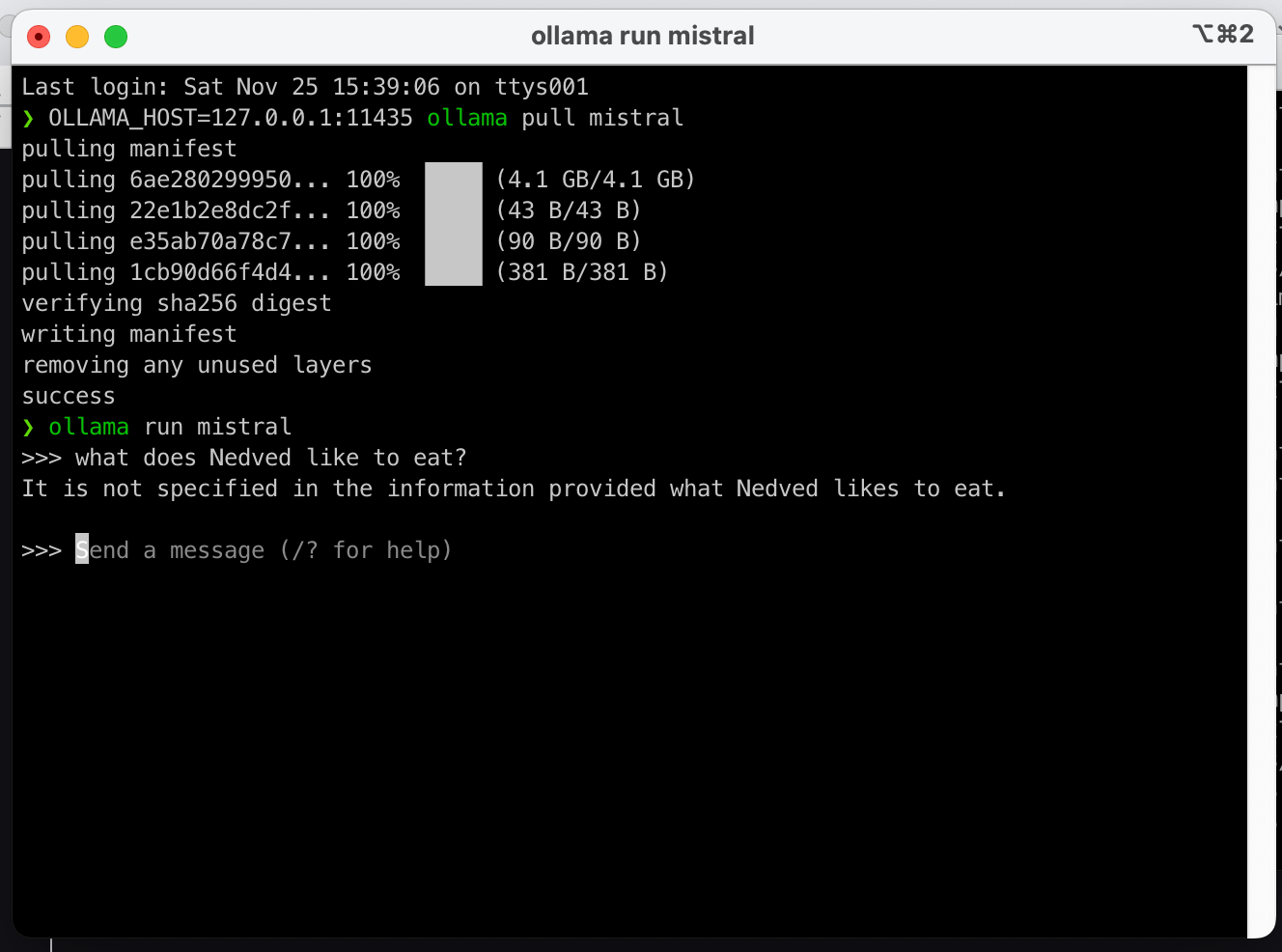

本文介绍: 订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。”, 在上传PDF文件后,你会看到基于PDF内容的回复。如果你直接向本地运行的Mistral提出同样的问题,你会得到以下回复。许多开源的小型语言模型已经发布,这使得在本地运行由SLMs驱动的客户端应用程序成为可能。Mac上尝试了这个方法,结果是令人鼓舞的。进行操作,接着上传之前准备好的PDF文件。安装完成后,加载Mistral。

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/

许多开源的小型语言模型已经发布,这使得在本地运行由SLMs驱动的客户端应用程序成为可能。有一个来自https://ollama.ai/blog/building-llm-powered-web-apps的有趣博客文章。我在我的M1 Mac上尝试了这个方法,结果是令人鼓舞的。

首先,从以下链接安装Ollama的Mac版本: Ollama

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。