本文介绍: 近期,stabilityAI发布了一个新的项目,是将图片作为基础,生成一个相关的小视频,本文主要是体验一下stable–video–diffusion的使用,以及对其使用方法进行简单的介绍。

0. 内容简介

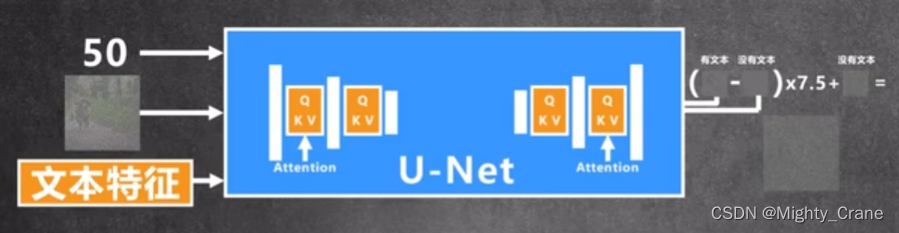

近期,stabilityAI发布了一个新的项目,是将图片作为基础,生成一个相关的小视频,其实也算是其之前研究内容的扩展。早在stable–diffusion的模型开源出来的时候,除了由prompt生成图片之外,也可以生成连续帧的短视频。

本文主要是体验一下stable–video–diffusion的使用,以及对其使用方法进行简单的介绍。具体原理相关内容并不是我的主要研究方法,也就不在此展开介绍了。

下面的这个小火箭就是项目的示例图片,生成视频之后,小火箭可以发射升空。

项目地址:

HF:https://huggingface.co/stabilityai/stable-video-diffusion-img2vid-xt

git:https://github.com/Stability-AI/generative-models

论文地址:

https://stability.ai/research/stable-video-diffusion-scaling-latent-video-diffusion-models-to-large-datasets

1. 运行环境

2. 模型下载

3. 代码梳理

3.1 修改yaml文件中的svd路径

3.2 修改DeepFloyDataFiltering的vit路径

3.3 修改open_clip的clip路径

3.4 代码总体结构

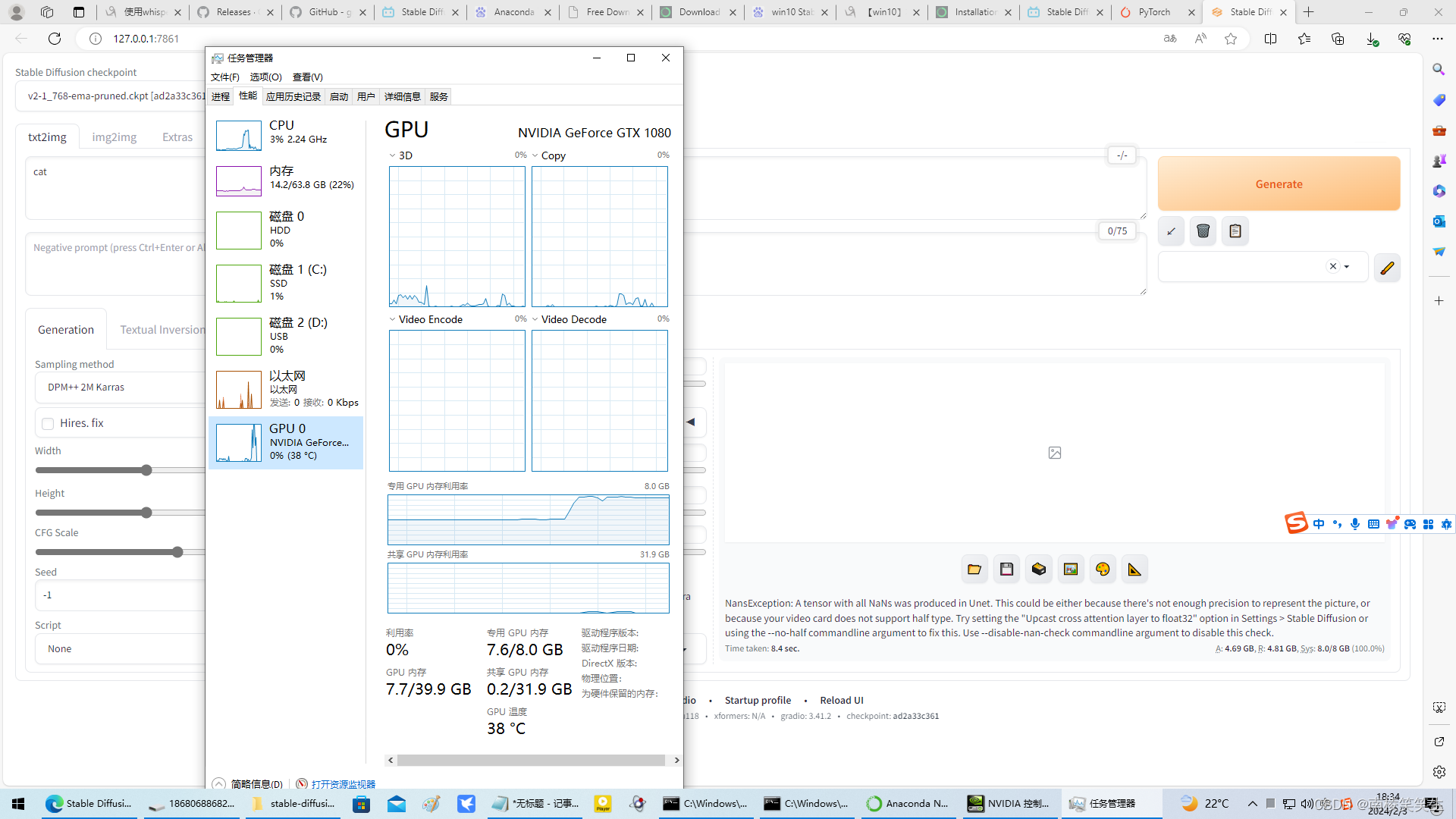

4. 资源消耗

5. 效果预览

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。