2)安装JDK

安装虚拟机(略)–1台即可,执行完毕下述内容,再克隆2台。

1-通过yum安装epel–release

2-关闭防火墙,关闭防火墙开机自启

3-创建other用户,并修改other用户的密码

4-配置others用户具有root权限,方便后期加sudo执行root权限的命令

5-在/opt目录下创建文件夹,并修改所属主和所属组

6-卸载虚拟机自带的JDK

7-重启虚拟机

8-使用固定IP

9-修改主机名,以下以kk 为例子

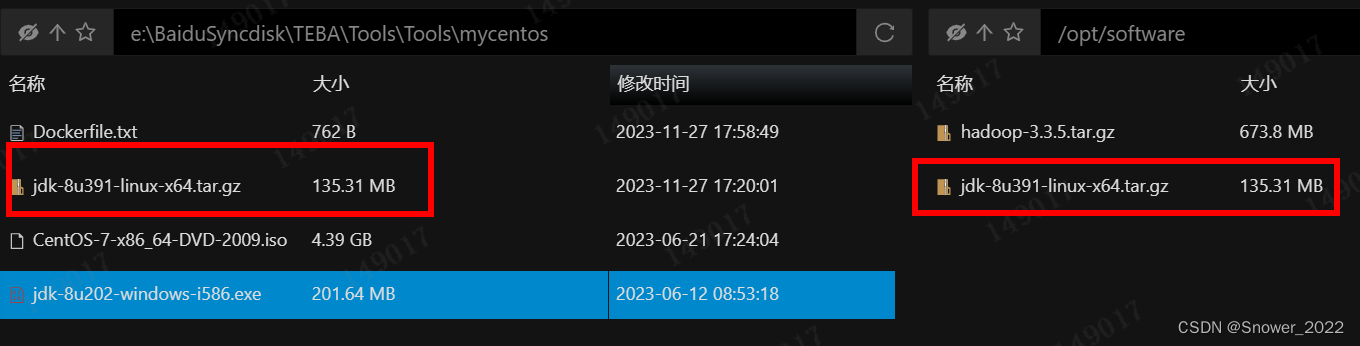

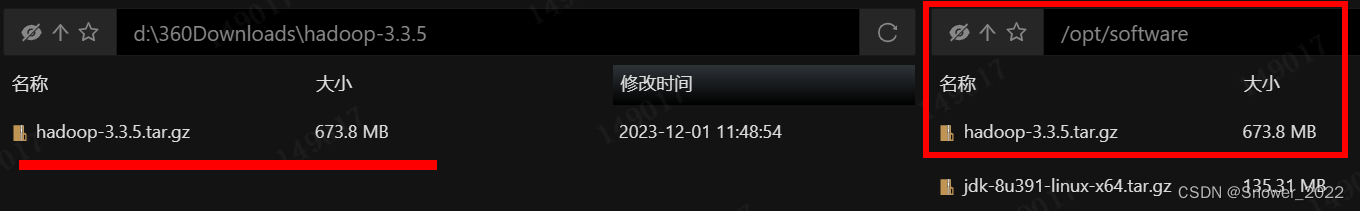

10-将JDK和hadoop 3.3.5 导入到opt目录下面的software文件夹下面

11-切换为配置的others 用户来做其他的操作

12-配置环境变量

13-hadoop 文件夹重要目录说明

14-克隆已经部署好的这台资源,修改克隆机的hostname即可。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。