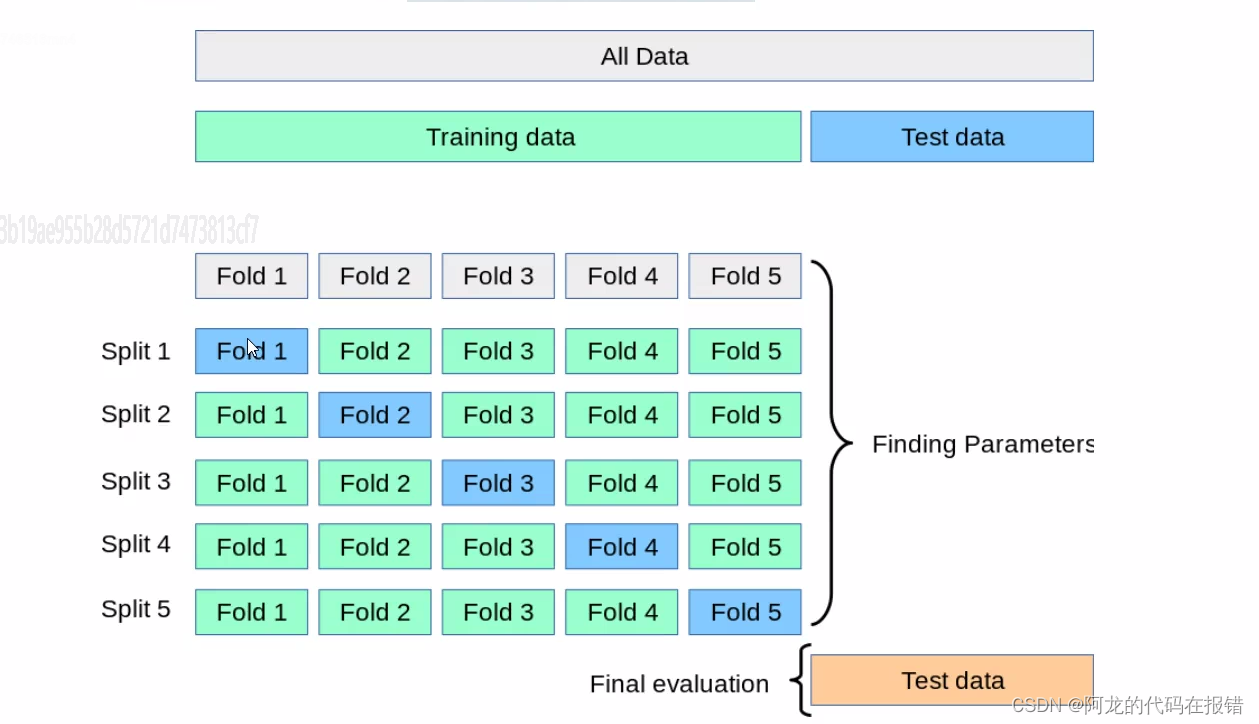

本文介绍: 是一种在机器学习中广泛使用的和方法。在训练模型时,我们通常将和,其中训练集用于训练模型,测试集用于评估模型的性能,但是这种方法可能会受到数据集的影响,导致苹果结果的。通过对数据集进行划分和评估,可以的评估模型的性能。交叉验证的常见方法是步骤如下:1、将数据集随机分成k个互不重叠的自己每个子集称为一个‘折’。2、对于每个折,执行以下操作:a.将当前折作为验证集,其余的折作为训练集b.使用训练集训练模型c.使用验证集评估模型性能(如计算分类准确率,均方误差等指标)

在此专栏的上一篇文章的基础上,进行交叉实验获取最佳的K值

上一篇文章:KNN算法案例-鸢尾花分类

数据拆分的过程:

交叉验证的常见方法是k折交叉验证(k-Fold Cross Validation)

步骤如下:

1、将数据集随机分成k个互不重叠的自己每个子集称为一个‘折’。

2、对于每个折,执行以下操作:

a.将当前折作为验证集,其余的折作为训练集

b.使用训练集训练模型

c.使用验证集评估模型性能(如计算分类准确率,均方误差等指标)

3.计算K次迭代中模型性能指标的平均值作为模型最终的苹果结果。

交叉验证的优点如下:

1.降低模型评估结果的方差:通过多次评估模型,交叉验证可以提供更稳定、更可靠的性能评估。

2.更充分的利用数据:交叉验证可以确保每个样本都被用于训练和验证,使得模型学习和评估更为全面

在算法调优中,交叉验证可以帮助我们找到最佳的超参数(如KNN中的K值)。我们可以尝试不同的的超参数组合。这种方法可以有效地防止过拟合,提高模型在新数据上的泛化性能。

前期导入包和加载数据以及切分数据

对超参数进行交叉验证筛选

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。