一. 单选题(共9题,49.5分)

二. 多选题(共9题,50.5分)

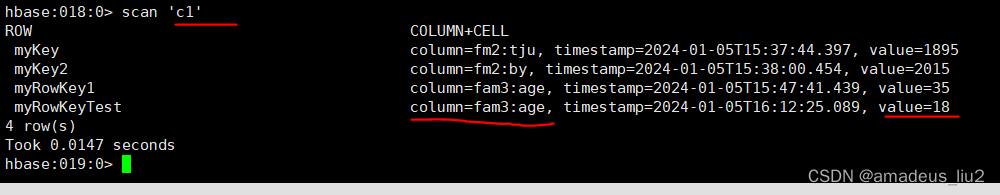

10. (多选题)关系数据库已经流行很多年,并且Hadoop已经有了HDFS和MapReduce,为什么需要HBase?

A. Hadoop可以很好地解决大规模数据的离线批量处理问题,但是,受限于Hadoop MapReduce编程框架的高延迟数据处理机制,使得Hadoop无法满足大规模数据实时处理应用的需求上

B. HDFS面向批量访问模式,不是随机访问模式

C. 传统的通用关系型数据库无法应对在数据规模剧增时导致的系统扩展性和性能问题

D. 传统关系数据库在数据结构变化时一般需要停机维护;空列浪费存储空间

正确答案: ABCD:Hadoop可以很好地解决大规模数据的离线批量处理问题,但是,受限于Hadoop MapReduce编程框架的高延迟数据处理机制,使得Hadoop无法满足大规模数据实时处理应用的需求上; HDFS面向批量访问模式,不是随机访问模式; 传统的通用关系型数据库无法应对在数据规模剧增时导致的系统扩展性和性能问题; 传统关系数据库在数据结构变化时一般需要停机维护;空列浪费存储空间;

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。