项目里用logstash分析日志,由于有多种模式(pattern)需要匹配,网上搜了很多示例,发现这些都是老的写法,都会报错,后来查阅了官方文档,才发现,新版本只支持新语法。

错误的语法:

正确的语法:

注意,先后顺序很重要,上面示例中,如果排错了顺序,后面规则永远匹配不到,都会被前面的规则抢先了。

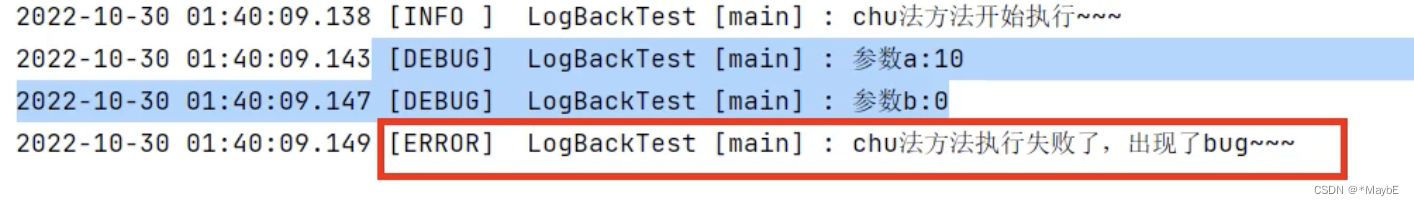

为方便大家拿来主义,上面示例对应的logback配置如下:

另外,为了让一条日志包含多行(如,异常日志),应该做如下配置:

参考官方文档:(搜索“multiple patterns”)

https://www.elastic.co/guide/en/logstash/current/plugins-filters-grok.html

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。