本文介绍: Nginx(“engine–x”)是一个高性能的开源反向代理服务器,也可以用作负载均衡器、HTTP缓存服务器和Web服务器。Nginx可以作为反向代理服务器,接受客户端请求并将其转发给后端服务器。它可以帮助处理静态文件、负载均衡、SSL终端等任务,提高系统性能和安全性。Nginx支持基于轮询、IP哈希、最小连接数等算法的负载均衡。通过分发请求到多个服务器,可以提高应用程序的可伸缩性和稳定性。Nginx可以缓存静态文件,降低对后端服务器的请求压力,提高网站性能。它支持各种缓存策略,如过期时间、刷新策略等。

Nginx

1 介绍

Nginx(“engine–x”)是一个高性能的开源反向代理服务器,也可以用作负载均衡器、HTTP缓存服务器和Web服务器。以下是关于Nginx的一些基本信息:

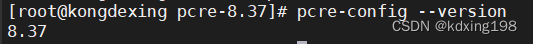

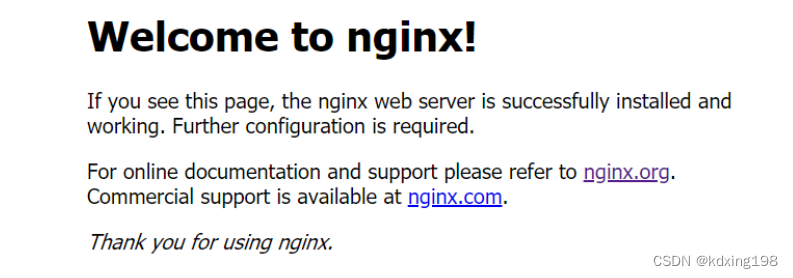

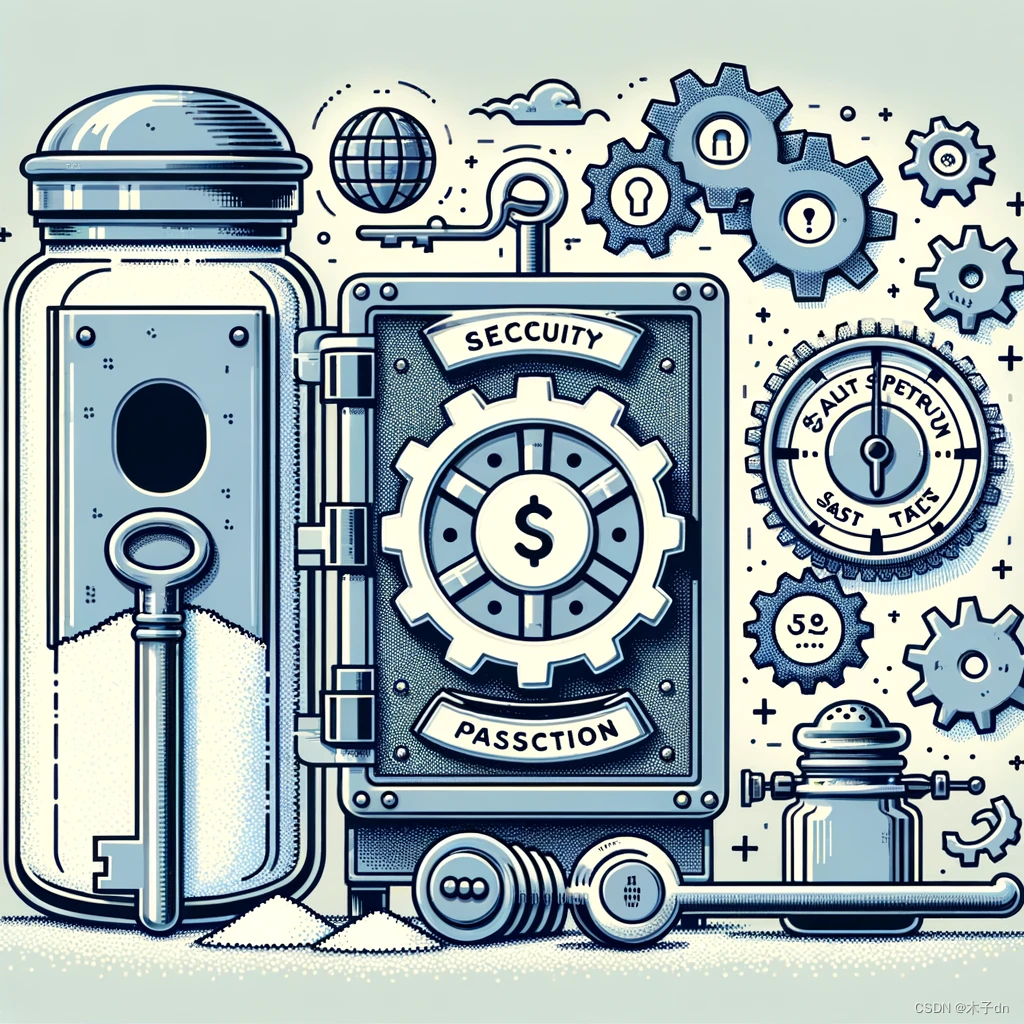

2 Nginx 安装

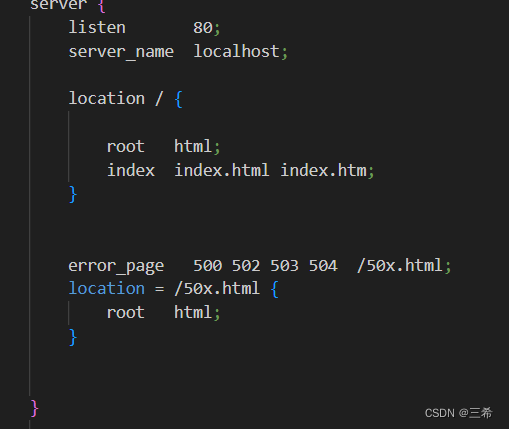

3 nginx.conf 配置文件

nginx.conf 是Nginx的主配置文件,其中包含了Nginx服务器的全局配置、http块配置以及server块配置等。以下是对一些常见配置项的解释:

4 正向代理和反向代理

4.1 正向代理

正向代理:如果把局域网外的 Internet 想象成一个巨大的资源库,则局域网中的客户端要访问 Internet,则需要通过代理服务器来访问,这种代理服务就称为正向代理。

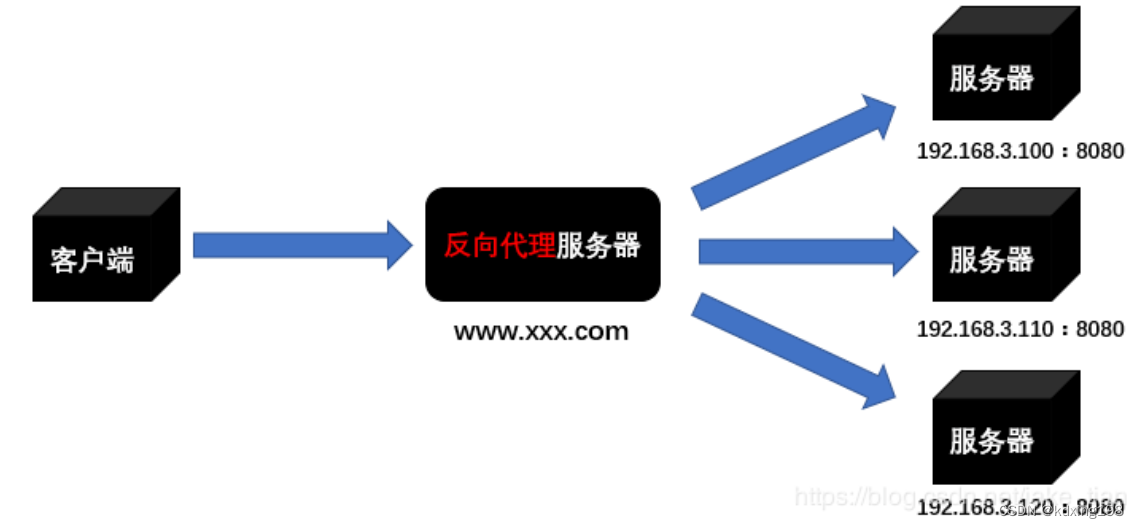

4.2 反向代理

反向代理,其实客户端对代理是无感知的,因为客户端不需要任何配置就可以访问,我们只需要将请求发送到反向代理服务器,由反向代理服务器去选择目标服务器获取数据后,在返回给客户端,此时反向代理服务器和目标服务器对外就是一个服务器,暴露的是代理服务器地址,隐藏了真实服务器 IP 地址。

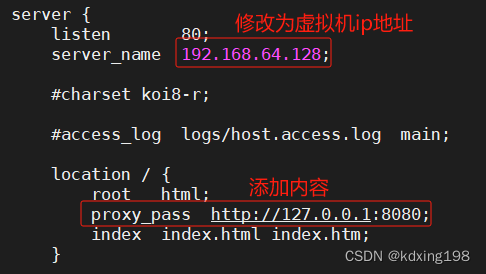

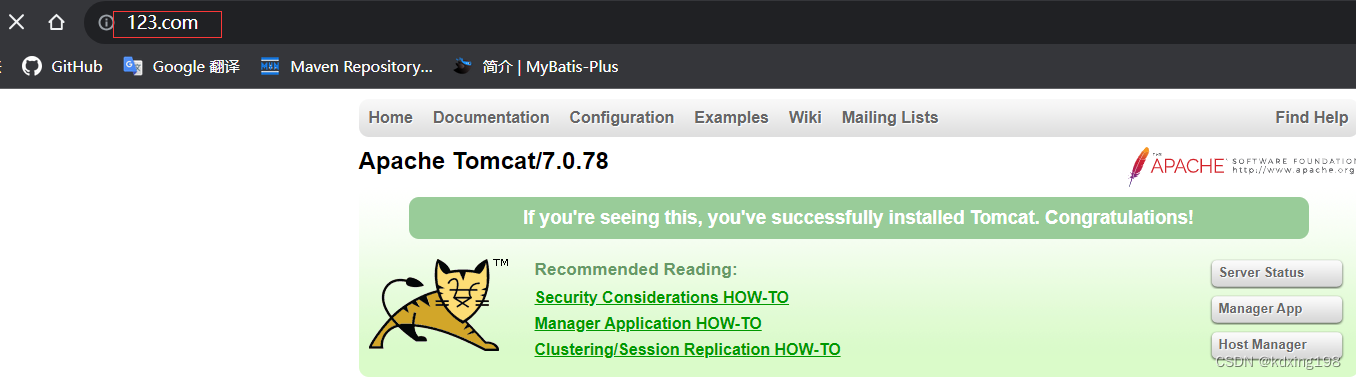

4.2.1 反向代理实例一

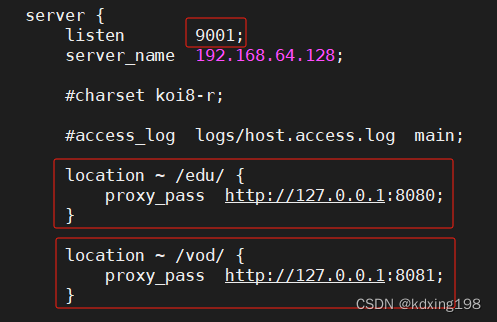

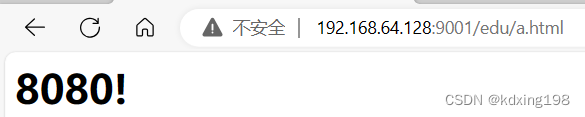

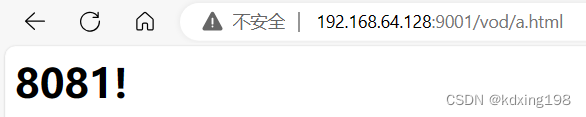

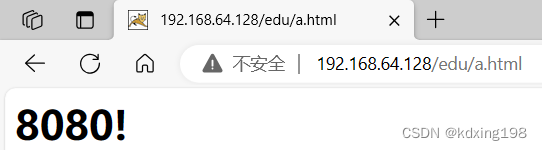

4.2.2 反向代理实例二

5 负载均衡

并发量特别大的时候容易造成服务器直接崩溃。这时候集群的概念产生了,单个服务器解决不了,我们增加服务器的数量,然后将请求分发到各个服务器上,将原先请求集中到单个服务器上的情况改为将请求分发到多个服务器上,将负载分发到不同的服务器,也就是我们所说的负载均衡。

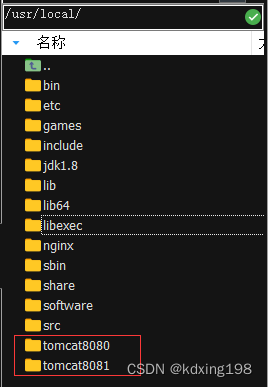

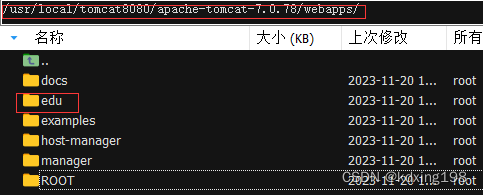

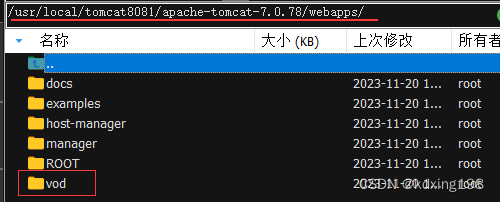

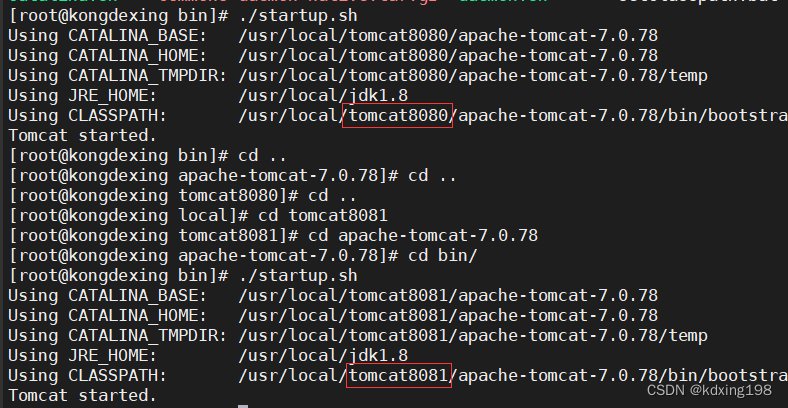

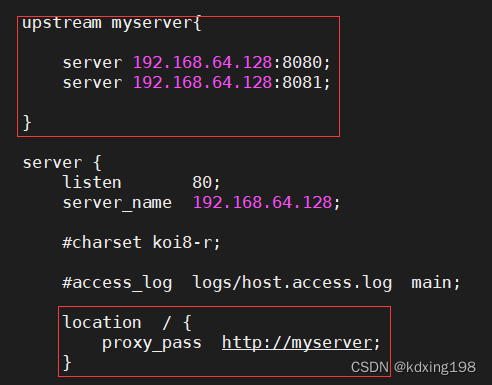

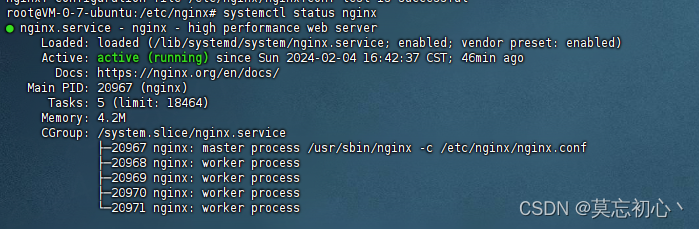

5.1 负载均衡实例

5.2 nginx 分配服务器策略

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。