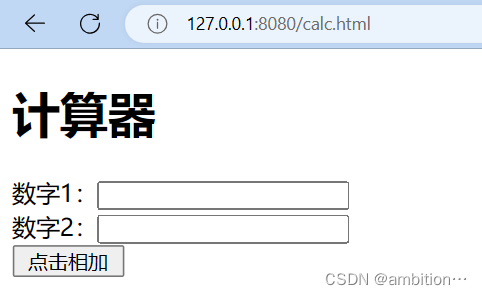

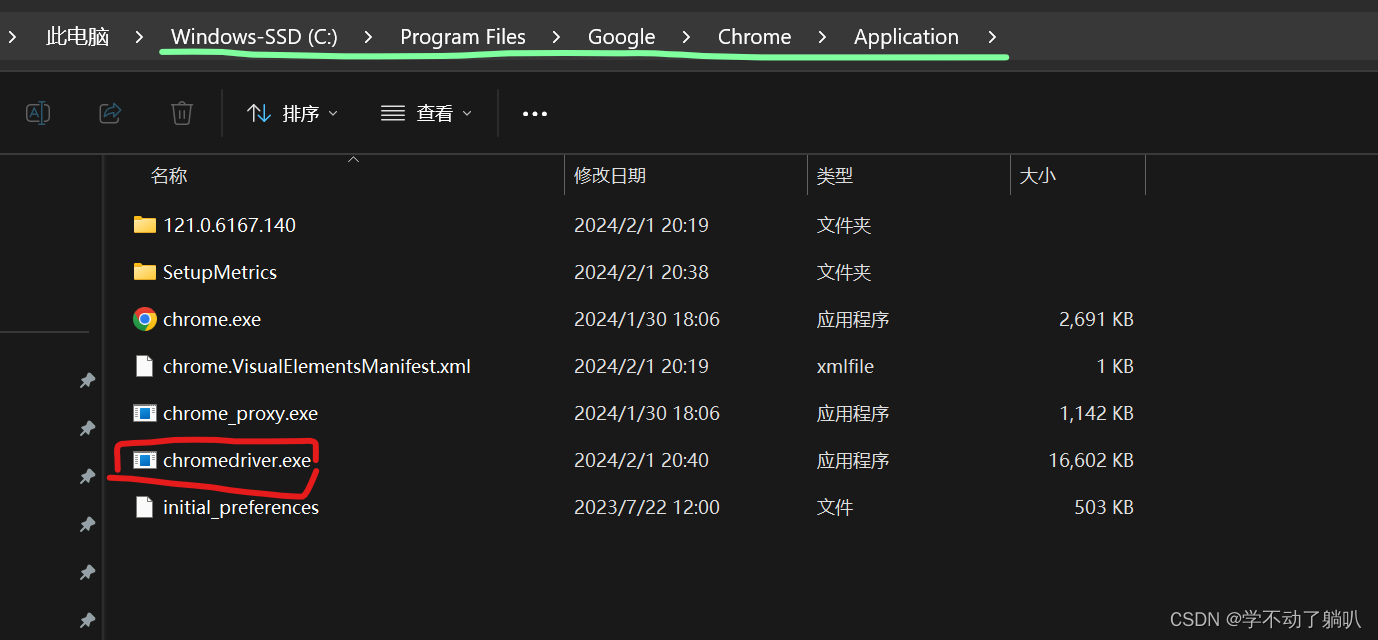

本文介绍: 针对这个案例,现在对爬虫的基础使用做总结如下:1、算法框架(1)设定传入参数~url:当前整个页面的url:当前页面的网址当前页面某个局部的url:打开检查~data:需要爬取数据的关键字,即搜索内容~param:需要获取哪些(类型)的数据,即数据类型~headers:UA伪装(2)得到get/post请求响应根据”检查“结果进行判断:get请求:response=requests.get(url=**,data=**,param=**,headers=**)

1、算法框架解释

2、代码解析

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。