本文介绍: ShapeNetV2, 所有55个categories来train GPT;但在chair,table,bench和lamp这四个类别上finetune。AutoEncoder用了2 A100, 2 days。transformer用了4 A100, 5 days。

概述

- 任务:无条件生成mesh (无颜色)

- 数据集:shapenet v2

- 方法:先trian一个auto encoder,用来获得code book;然后trian一个自回归的transformer

- mesh表达:face序列。face按规定的顺序;每个face用三个顶点的坐标表示

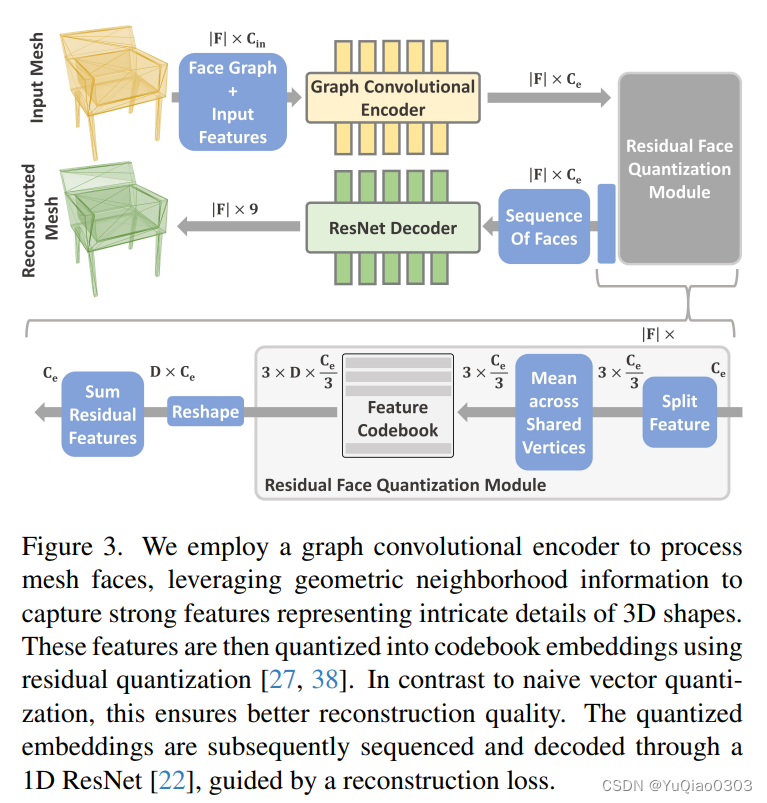

Learning Quantized Triangle Embeddings (一个auto encoder)

- mesh表示为triangle face的序列。

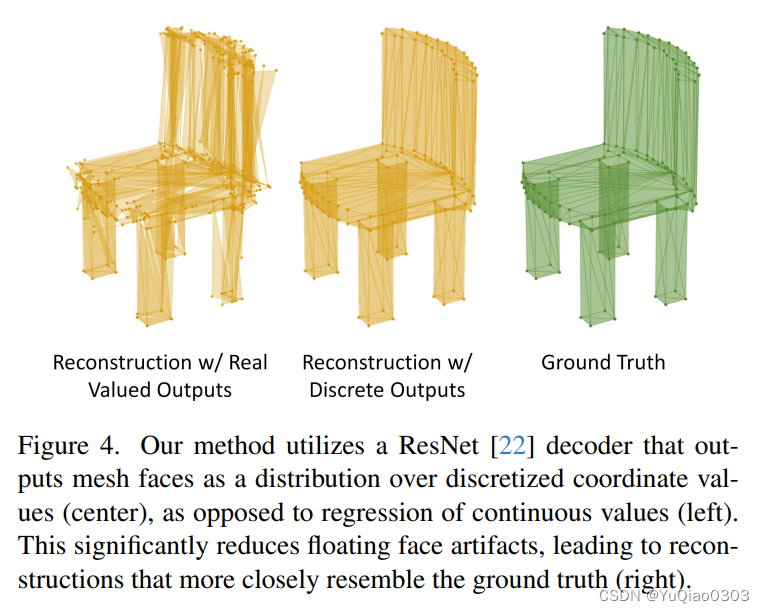

- face怎么表示呢?直接用3 vertices的9 coordinates 来表达一个face不太好;因此作者就这样:

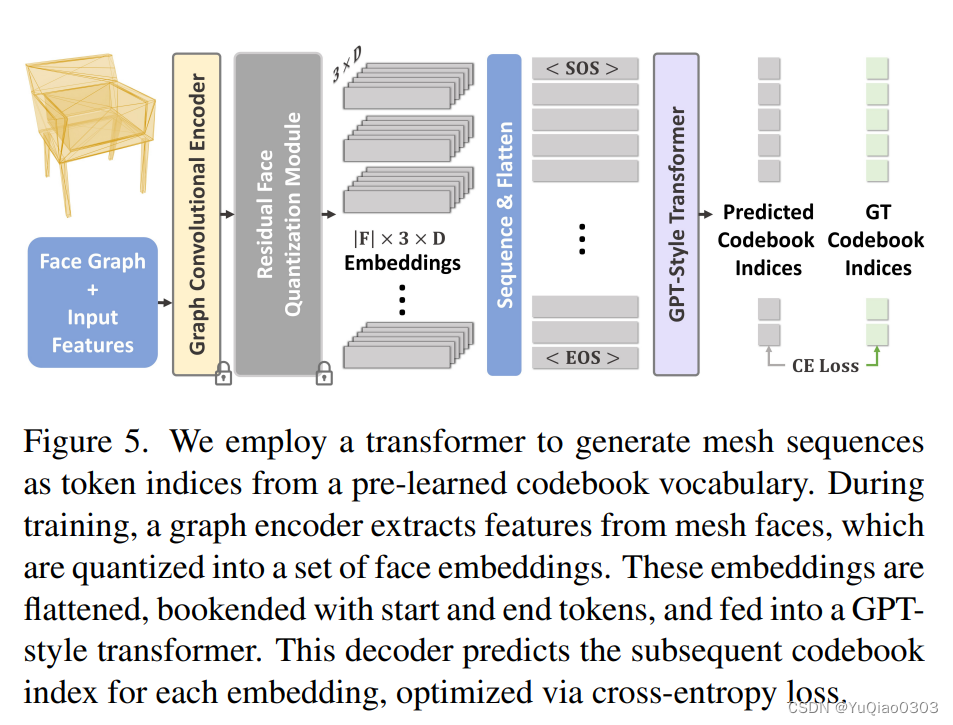

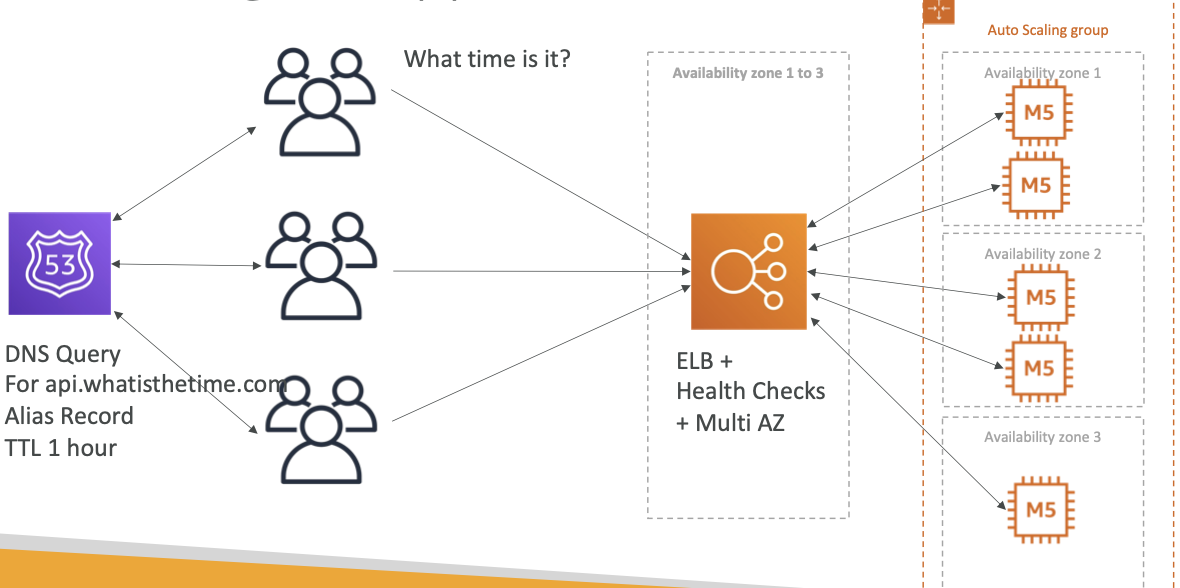

mesh generation with transformers

像文字接龙的语言模型一样,自回归地训练transformer:

- transformer训练时的输入,是刚才得到的e,(加上learned position encoding等);

- 经过一个类似GPT的transformer,预测下一个token e在codebook中的index

- 用交叉熵loss来train

得到mesh:

训练时间

训练时间:

AutoEncoder用了2 A100, 2 days

transformer用了4 A100, 5 days

数据集:

ShapeNetV2, 所有55个categories来train GPT; 但在chair,table,bench和lamp这四个类别上finetune。

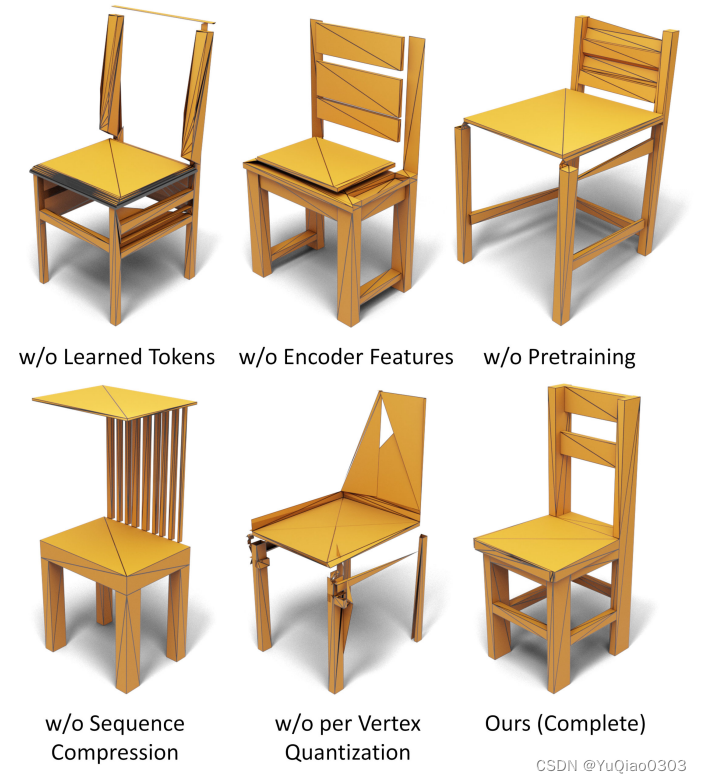

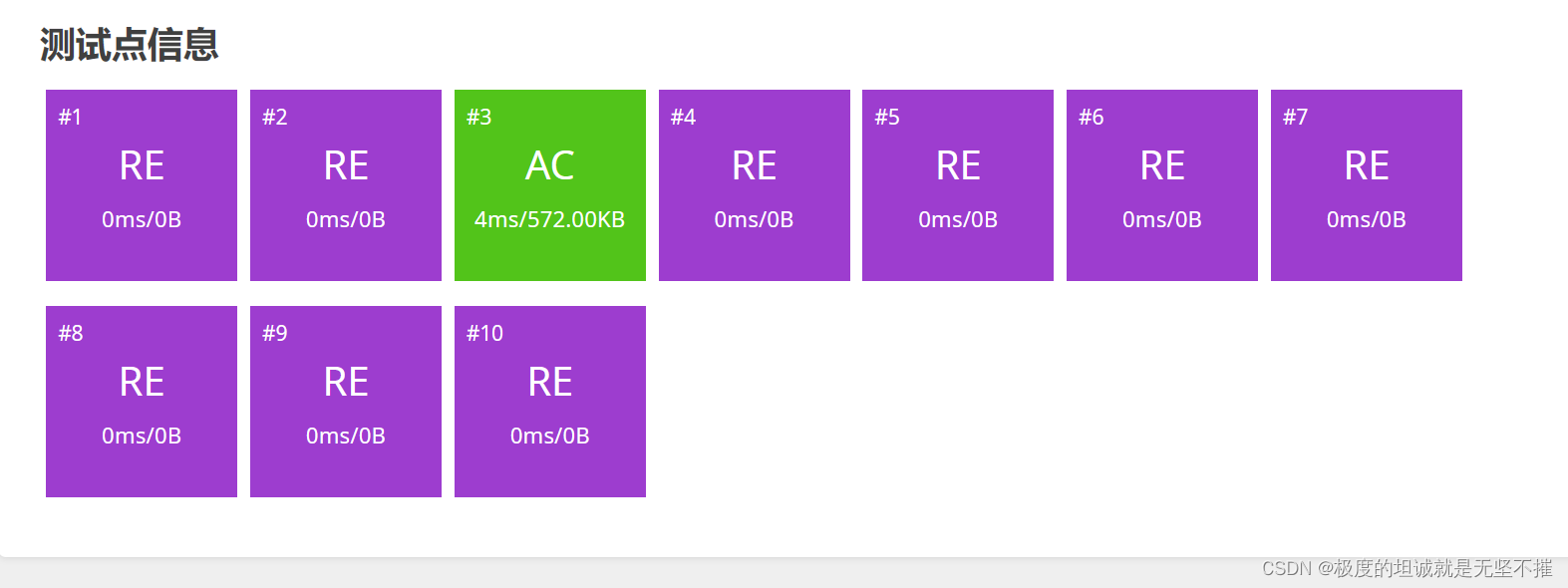

消融实验

原文地址:https://blog.csdn.net/qq_34342853/article/details/134717785

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_30678.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

![洛谷 P8682 [蓝桥杯 2019 省 B] 等差数列](http://www.7code.cn/wp-content/uploads/2023/11/ee6748cbc735e6105405f8a984d954c804b93f34bc916-Z0IqTf_fw1200.png)