1[2]。

最后想再强调一下“矢量化”的好处。神经网络的规模之所以可以越来越大,得益于“矢量化”,这保证神经网络可以使用矩阵运算高效地部署。这是因为并行计算硬件,比如GPU或者强大的CPU,非常擅长做非常大的矩阵运算。

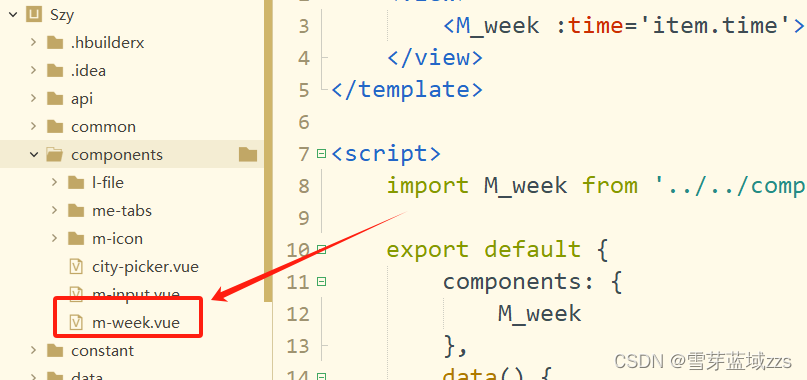

4.4 代码实现–手写数字识别

5. AGI漫谈

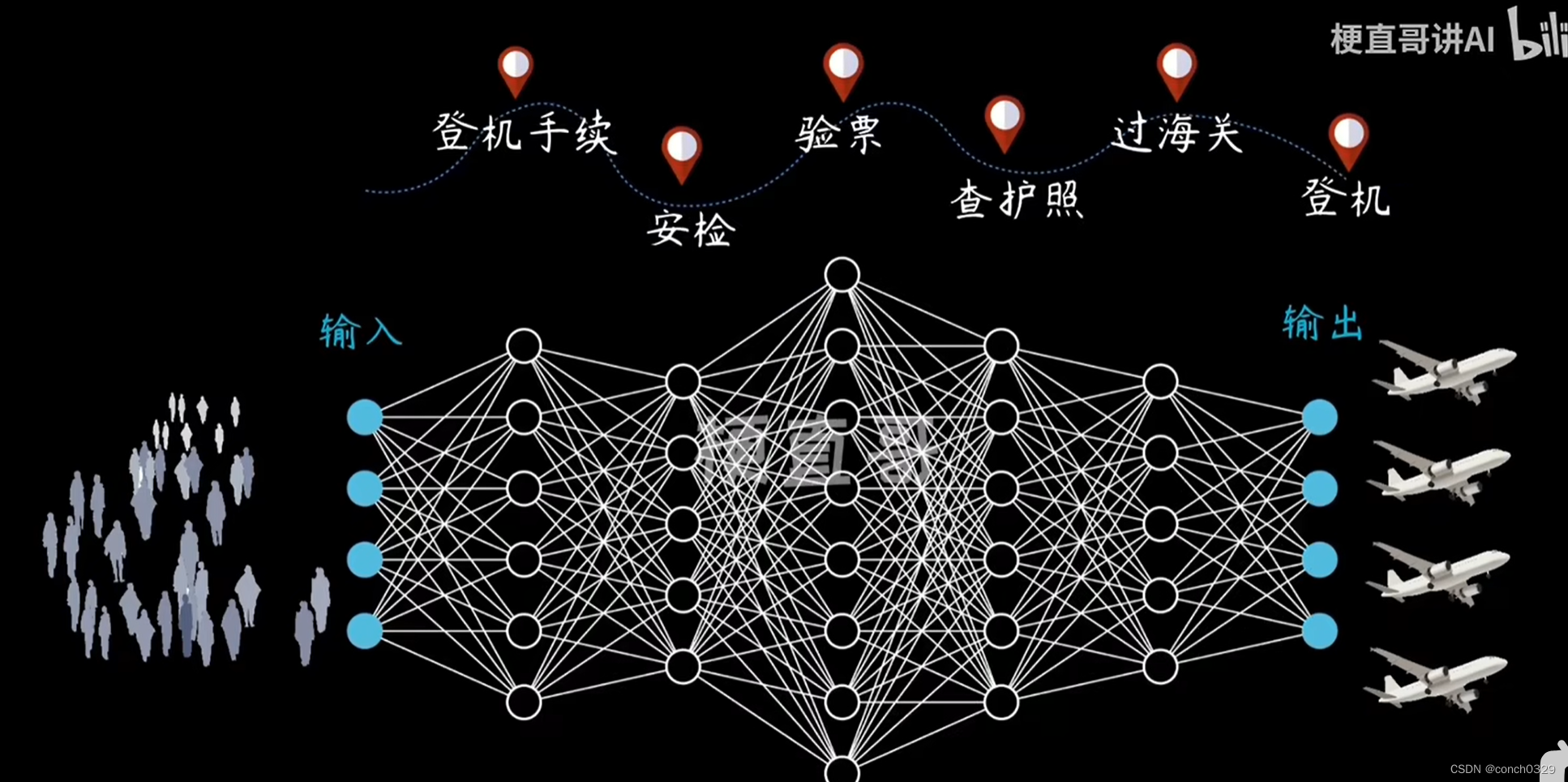

最后一节放松一下,来谈谈“AGI(Artifical General Intelligence, 通用人工智能)”。老师一直梦想着构建一个和人一样聪明的AI系统,这也是全世界人工智能领域的愿景,但是前路漫漫,不知道几十年、上百年能否实现。不过,如今AGI的目标是构建一个“和人一样聪明的AI”,这让人兴奋但同时又有很多不切实际的炒作,比如《终结者》系列电影中的“天网”要灭绝人类,这引起一部分人对于AI的恐慌。但其实AI主要包括两方面完全不一样的内容:

并且,即使从“模拟人脑”的角度来看,要想实现真正的AGI依旧非常困难,主要有两个原因:

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。