Cross–modality image translation: CT image synthesis of MR brain images using multi generative network with perceptual supervision

跨模态图像翻译:使用具有感知监督的多生成网络合成MR脑图像的CT图像

Computer Methods and Programs in Biomedicine 237 (2023) 107571

背景

- 背景:计算机断层扫描(CT)和磁共振成像(MRI)是临床上的主流成像技术。CT成像可以揭示高质量的解剖和病理生理结构,尤其是骨组织,用于临床诊断。MRI在软组织中提供高分辨率,并且对病变敏感。CT结合MRI诊断已成为常规的影像引导放射治疗方案。但是由于额外的CT检查会增加电离辐射,给患者带来风险。如果能够将磁共振图像转换为CT图像,则可以避免不必要的辐射,并且可以提高诊断价值。

- 方法:在本文中,为了减少CT检查中的辐射暴露剂量,改善传统虚拟成像技术的局限性,我们提出了一种具有结构感知监督的生成MRI到CT的转换方法。即使结构重建在MRI-CT数据集配准中在结构上不对齐,我们提出的方法也可以更好地将合成CT(sCT)图像的结构信息与输入MRI图像对齐,同时在MRI到CT的跨模态转换中模拟CT的模态。

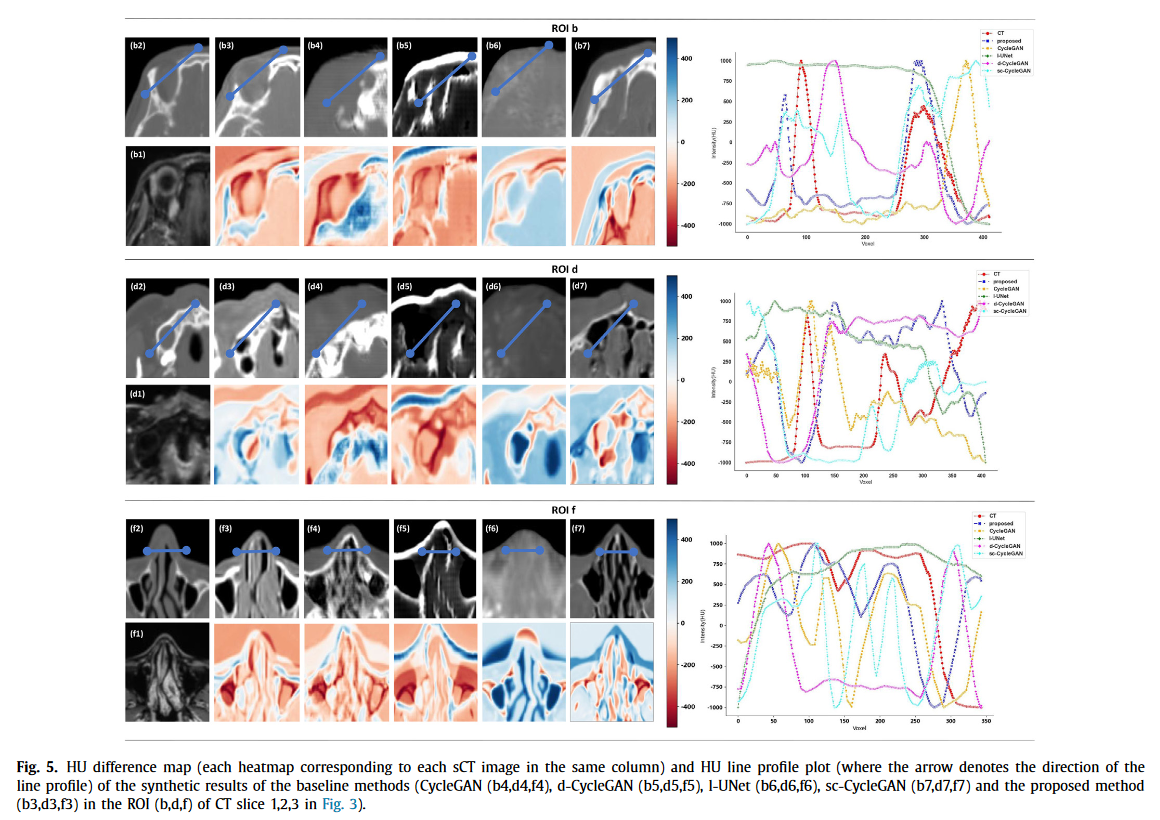

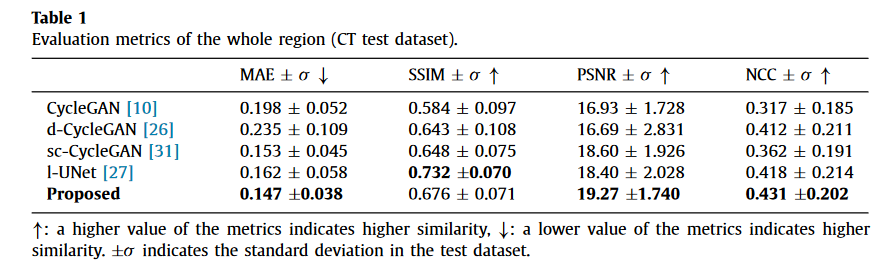

- 结果:我们总共检索了3416张大脑MRI-CT配对图像作为训练/测试数据集,包括10名患者的1366张训练图像和15名患者的2050张测试图像。通过HU差异图、HU分布和各种相似性指标,包括平均绝对误差(MAE)、结构相似性指数(SSIM)、峰值信噪比(PSNR)和归一化互相关(NCC),对几种方法(基线方法和所提出的方法)进行了评估。在我们的定量实验结果中,所提出的方法在整个CT测试数据集中实现了最低的MAE平均值0.147,最高的PSNR平均值19.27和NCC平均值0.431。

- 结论:总之,合成CT的定性和定量结果都验证了所提出的方法比基线方法能够保持更高的目标CT骨组织结构信息的相似性。此外,所提出的方法为模拟CT模态的分布提供了更好的HU强度重建。实验估计表明,该方法值得进一步研究。

贡献

我们提出了一个跨模态生成网络。为了平衡成对MRI和CT图像的结构对齐,我们在先前工作的基础上使用了结构感知损失重建方法[21]。Johnson等人的论文[22]通过计算特征提取器输出的感知损失,增强了对目标风格的监督。在CT重建任务中,我们采用了多层ImageNet预训练的ResNet-50的感知损失。我们的工作验证了所提出的方法可以在模态转换中保持MRI图像和CT图像之间的结构一致性。

CT-MRI变换中的结构对准结构对准是跨模态图像生成的关键因素,先前的研究表明,成对的CT-MRI图像中的逐像素结构错位会导致重建失败。为了应对CT-MRI配准中结构不相似的挑战,我们提出了一种新的训练方法,该方法能够从结构不一致的CT-MRI数据集进行重建,同时保留输入域的原始组织和结构信息。我们的方法为解决临床实践中CT-MRI配准结果中的像素错位提供了一种潜在的解决方案。

受CycleGAN和风格转移方法的启发,我们的工作提出了一个统一的三种损失(感知、CycleGAN和风格损失)目标函数,以解决跨域转换中内容重构的收敛问题。与普通的循环一致性损失相比,联合目标函数对内容重建的体素保持了更高的保真度。

[21] X. Gu, Z. Liu, J. Zhou, H. Luo, C. Che, Q. Yang, L. Liu, Y. Yang, X. Liu, H. Zheng, D. Liang, D. Luo, Z. Hu, Contrast-enhanced to noncontrast CT transformation via an adjacency content–transfer–based deep subtraction residual neural network, Phys. Med. Biol. 66 (14) (2021) 145017, doi:10.1088/1361-6560/ac0758.

实验

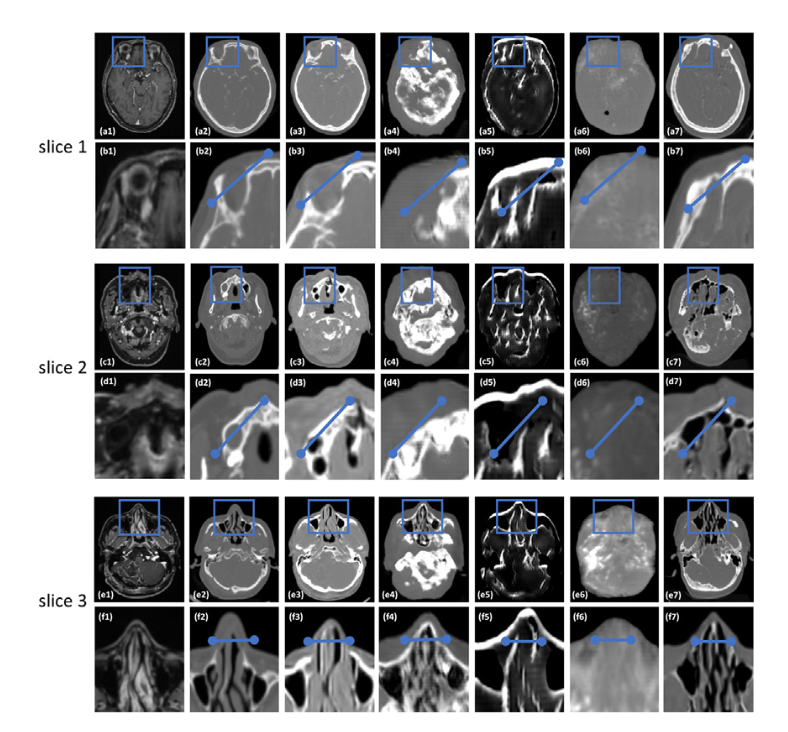

用热图图评估了配对CT图像和合成CT图像之间的结构差异,热图是通过Hounsfield单位(HU)值的强度差异计算的。因此,我们使用核密度估计(KDE)曲线在CT头部测试图像的整个区域上分析了CT图像的HU分布。我们通过对标记线中像素位置对应的HU值进行采样来评估测试图像的HU轮廓。

数据集:私有CT、MRI数据集,25例,3416对,体素大小为0.5 mm×0.5 mm×1.0 mm,使用刚性配准算法对每个患者的CT和MR图像进行刚性对齐,并将它们重新采样到相同的体素大小和视野,以形成数据集。为了避免我们提出的模型中的过拟合和数据泄露,我们将数据集划分为来自10名患者的1366个CT/MR切片的训练集和来自15名患者的2050个CT/MR切片的测试集

方法

引入了一种感知提取方法,该方法在我们之前与CT重建相关的工作中提出[21]。在这项工作中,我们实现了一个预训练的具有冻结参数的ResNet-50作为损失网络

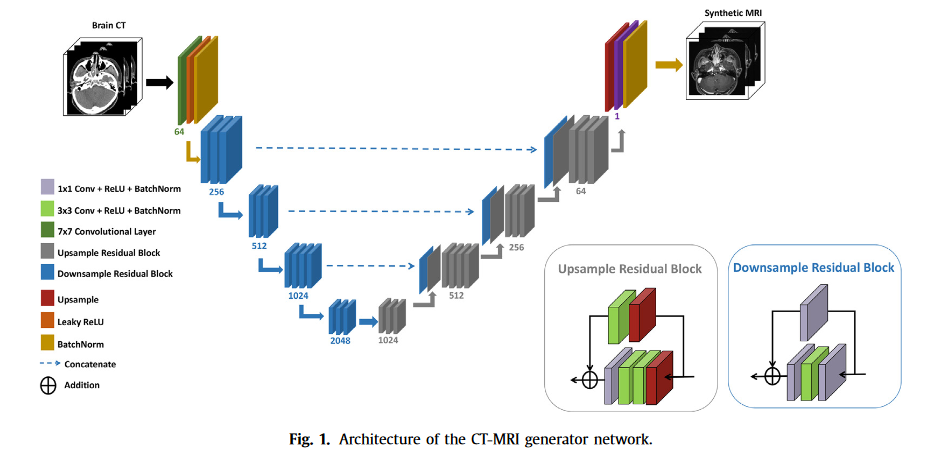

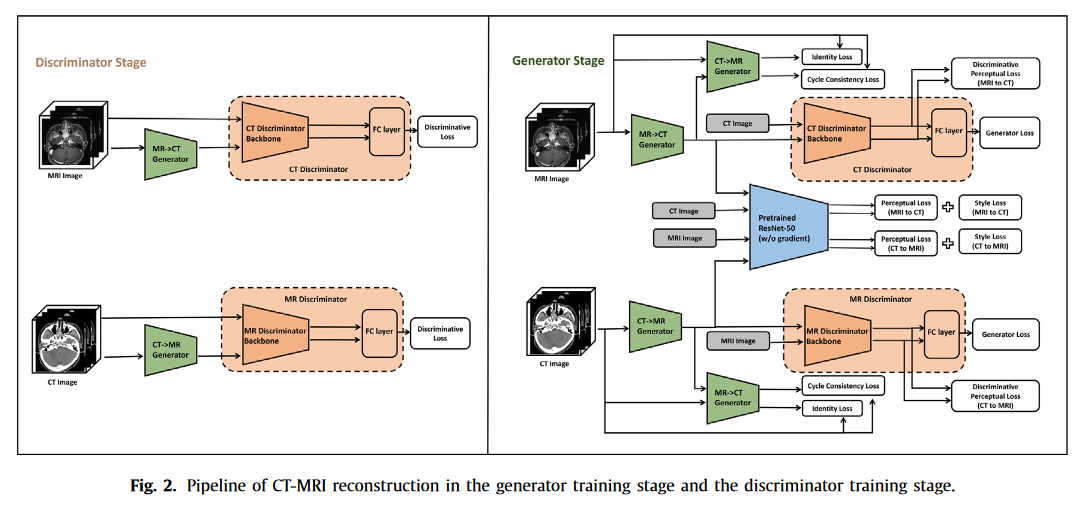

参考CycleGAN,我们提出的方法初始化用于MRI到CT转换和CT到MRI转换的两个生成器。对应于MRI到CT发生器和CT到MRI发生器,该方法构造了两个鉴别器网络来识别真实目标的模拟。此外,我们的方法利用特征提取方法来保留结构未对准的输入到目标变换中的重要结构信息。为了捕捉特征图整个区域中目标特征的一致性,我们引入了一种感知提取方法,该方法在我们之前与CT重建相关的工作中提出[21]。在这项工作中,我们实现了一个预训练的具有冻结参数的ResNet-50作为损失网络。此外,我们使用鉴别器网络的主干来提取目标域中的身份特征。这两个特征提取器都有助于生成器网络的损失计算。图1显示了生成器网络的架构,包括上采样和下采样残差块的架构。

损失函数

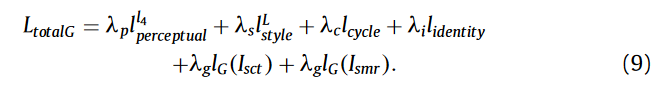

为了解决未配对MRI-CT数据中MRI图像和CT图像的低结构一致性问题,我们提出的方法包括五个损失函数:风格传递损失、感知损失、循环损失、一致性损失和对抗性损失。

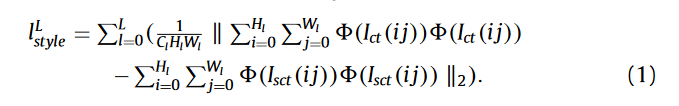

- style loss 风格损失函数,使用gram矩阵的欧几里得距离作为ImageNet预训练的ResNet-50模型的输出层中的风格损失

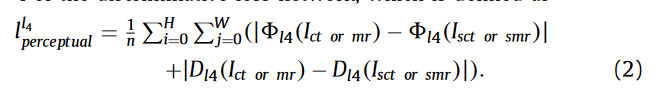

- perceptual loss 感知损失是从没有梯度的预训练损失网络的第4层和判别损失网络的4层计算的

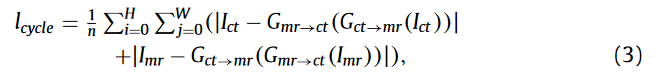

- 循环损失来控制输出映射循环到原始图像的重构

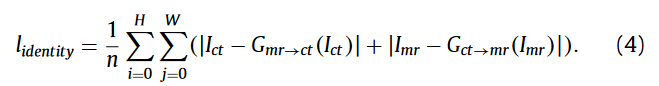

- 一致性损失是为了鼓励目标图像的映射,以保持从目标到输入的G投影中的像素一致性

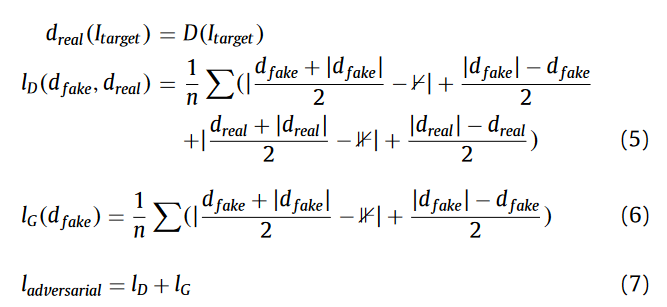

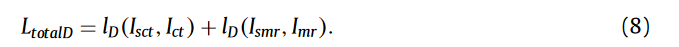

- 与WGAN网络类似,我们将L1损失计算应用于MRI到CT发生器/鉴别器和CT到MRI发生器/鉴别器的对抗性损失,无需对数

Thinking

原文地址:https://blog.csdn.net/weixin_42489272/article/details/134738674

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_31040.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!