Apache Kafka是一个分布式流处理平台,用于构建高性能、可扩展的实时数据流应用程序。本文将介绍如何使用Docker容器化技术来安装和配置Apache Kafka。

一、使用镜像安装

1、kafka安装必须先安装Zookpper

2、下载镜像

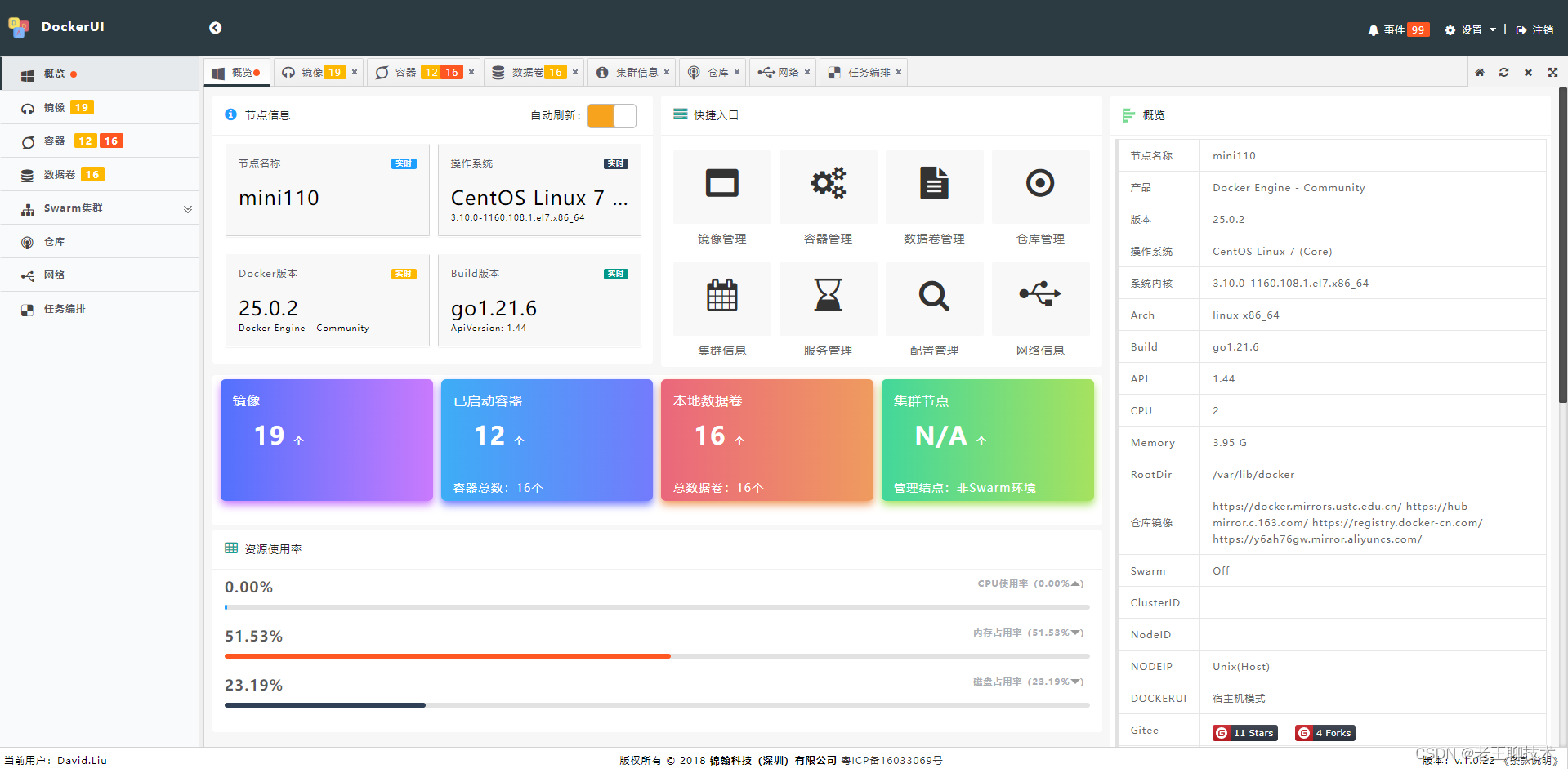

docker pull wurstmeister/kafka3、查看下载好的镜像

docker images4、启动Kafka

docker run -d --name kafka --publish 9092:9092 --link zookeeper --env KAFKA_ZOOKEEPER_CONNECT=zookeeper:2181 --env KAFKA_ADVERTISED_HOST_NAME=127.0.0.1 --env KAFKA_ADVERTISED_PORT=9092 wurstmeister/kafka5、查看是否创建好Kafka容器

docker ps6、进入到Kafka容器内

sudo docker exec -it kafka /bin/bash7、创建topic

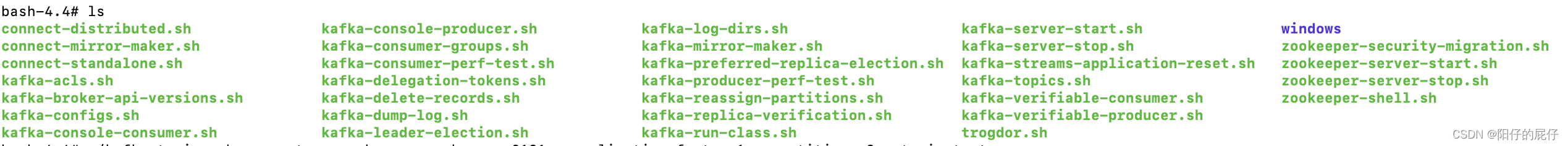

cd opt/kafka_2.13-2.6.0/bin

./kafka-topics.sh --create --zookeeper zookeeper:2181 --replication-factor 1 --partitions 8 --topic test Created topic test.8、创建成功之后发送消息

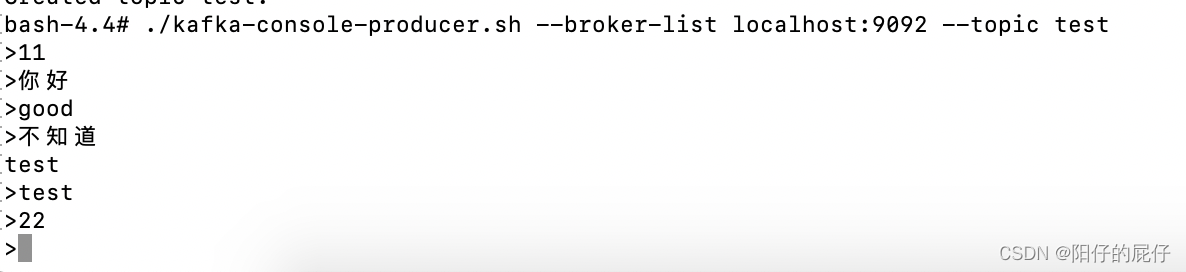

./kafka-console-producer.sh --broker-list localhost:9092 --topic test

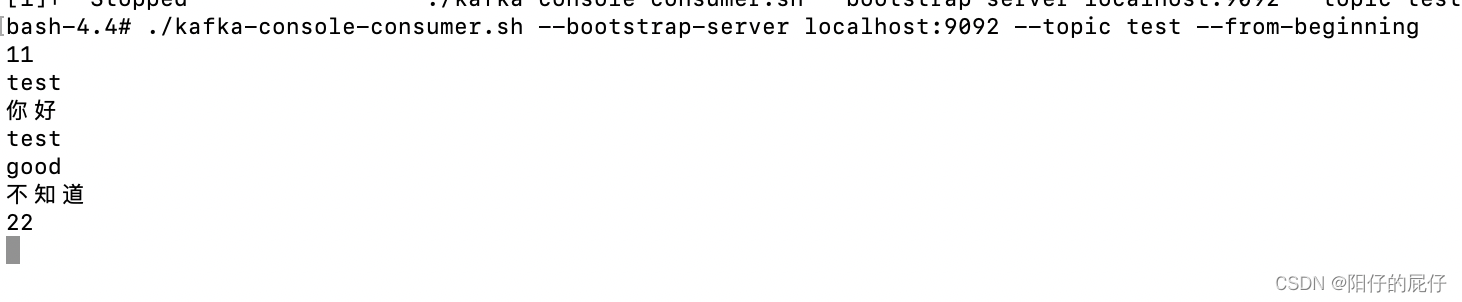

9、重新打开一个终端,创建消费者

sudo docker exec -it kafka /bin/bash cd opt/kafka_2.13-2.6.0/bin/ ./kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test --from-beginning #若不想从头消费就使用 ./kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test

这样就能接受到生产着生产的数据了

10、查看、删除Kafka中的所有的topic

#查看 ./kafka-topics.sh --list --bootstrap-server ZK地址:端口

./kafka-topics.sh --list --bootstrap-server localhost:9092

#删除 ./kafka-topics.sh --delete --bootstrap-server ZK地址:端口 --topic topic名

./kafka-topics.sh --delete --bootstrap-server localhost:9092 --topic local_point二、使用Docker Compose安装

1. 安装Docker和Docker Compose

首先,确保你的系统已经安装了Docker和Docker Compose。你可以根据操作系统的不同,按照官方文档的指引进行安装。

2. 创建Docker Compose文件

在你的项目目录下创建一个名为`docker-compose.yml`的文件,并添加以下内容:

services:

zookeeper:

image: confluentinc/cp-zookeeper:6.2.0 ports:

– “2181:2181”

environment:

– ZOOKEEPER_CLIENT_PORT=2181 – ZOOKEEPER_TICK_TIME=2000 kafka:

image: confluentinc/cp-kafka:6.2.0 ports:

– “9092:9092”

environment:

– KAFKA_ZOOKEEPER_CONNECT=zookeeper:2181 – KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://kafka:9092 – KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR=1 depends_on:

– zookeeper“`

3. 启动Kafka集群

打开终端,进入到包含`docker-compose.yml`文件的目录,并执行以下命令启动Kafka集群,如下命令Docker将会下载所需的镜像,并启动一个包含Zookeeper和Kafka的容器集群。

bashdocker-compose up -d4. 验证Kafka集群是否正常运行

执行以下命令,查看Kafka集群的运行状态:如果所有容器都处于运行状态,则表示Kafka集群已成功启动。

bashdocker-compose ps5. 使用Kafka

现在可以使用Kafka进行消息的发布和订阅。可以使用Kafka的命令行工具或者编程语言的Kafka客户端库来与Kafka集群进行交互。

6. 停止和清理

如果想停止Kafka集群并清理相关的容器和资源,可以执行以下命令,Docker将会停止并删除相关的容器和网络。

bashdocker-compose down结论:

通过使用Docker容器化技术,我们可以方便地安装和配置Apache Kafka,快速搭建一个可用的Kafka集群。这为我们开发和测试实时数据流应用程序提供了便利,同时也提供了良好的可扩展性和灵活性。

原文地址:https://blog.csdn.net/lly576403061/article/details/134672761

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_31264.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!