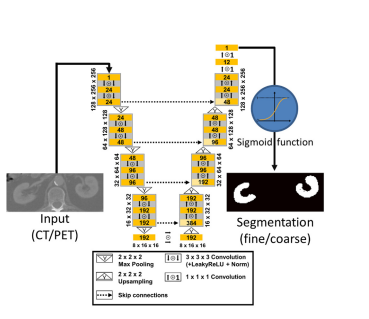

本文介绍: 我们提出了SegNeXt,一个简单的语义卷积网络架构分割。近年来,基于变换的语义分割模型由于其在空间编码中的自注意性而在语义分割领域占据主导地位信息。在本文中,我们证明了卷积注意是一种更有效的方法变压器中的自注意机制是对上下文信息进行编码的有效途径。通过重新审视成功者所拥有的特点在分割模型中,我们发现了导致分割模型性能改进的几个关键组件。这促使我们去设计一部小说使用廉价卷积运算的卷积注意力网络。

1.该文章属于YOLOV5/YOLOV7/YOLOV8改进专栏,包含大量的改进方式,主要以2023年的最新文章和2022年的文章提出改进方式。

2.提供更加详细的改进方法,如将注意力机制添加到网络的不同位置,便于做实验,也可以当做论文的创新点。

3.涨点效果:SegNext_Attention注意力机制,实现有效涨点!

1.第一步,在ultralytics/nn/modules/block.py文件中添加注意力机制

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。