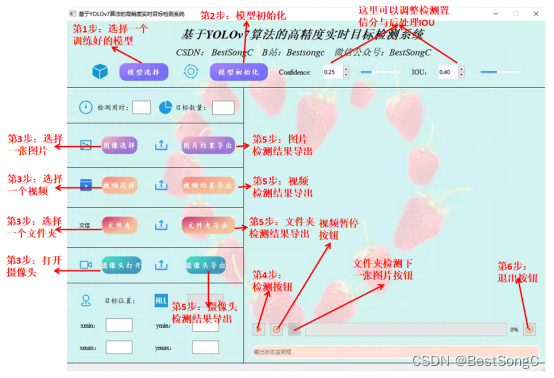

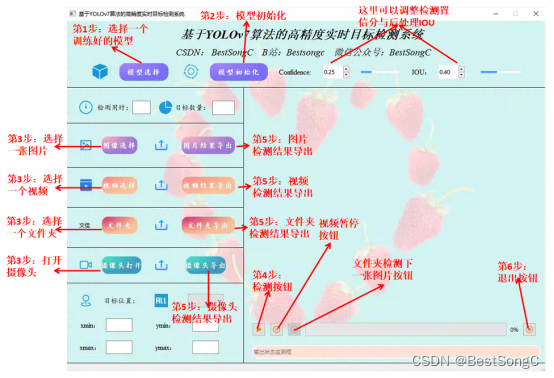

摘要:基于YOLOv7算法的高精度实时检测识别系统可用于日常生活中检测与定位多种目标,此系统可完成对输入图片、视频、文件夹以及摄像头方式的目标检测与识别,同时本系统还支持检测结果可视化与导出。本系统采用YOLOv7目标检测算法来训练数据集,使用Pysdie6框架来搭建桌面页面系统,支持PT、ONNX等模型权重作为系统的预测模型加载。本系统实现的功能包括:模型权重的选择与初始化;检测置信度与后处理IOU阈值的调节;图像的导入、检测、检测结果的可视化与目标统计;视频的导入、检测、检测结果的可视化与目标统计;文件夹的图像批量导入、检测、检测结果的可视化与目标统计;设备摄像头的导入、检测、检测结果的可视化与目标统计;单张图像、视频、摄像的推理用时展示。本博文详细介绍系统的环境搭建过程、整体功能介绍与演示,用时也提供了完整的Python源码和使用教程,适合新入门的朋友参考同时支持二次开发,整个系统的完整代码以及资源文件请转至文末的下载链接来获取。

YOLOv7算法原理介绍

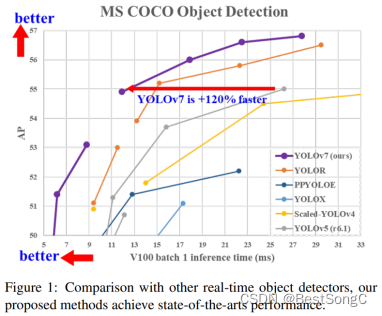

2022年7月YOLOv7被提出与发布,论文发表在2023的计算机视觉顶级会议CVPR上,在YOLOv3和YOLOv4的官网上均挂上了YOLOv7的链接和说明,这说明YOLOv7已得到了大佬的认可。官方版的YOLOv7相同体量下比YOLOv5精度更高,速度快120%(FPS),比 YOLOX 快180%(FPS),比 Dual-Swin-T 快1200%(FPS),比 ConvNext 快550%(FPS),比 SWIN-L快500%(FPS)。在5FPS到160FPS的范围内,无论是速度或是精度,YOLOv7都超过了目前已知的检测器,并且在GPU V100上进行测试,精度为56.8% AP的模型可达到30 FPS(batch=1)以上的检测速率,与此同时,这是目前唯一一款在如此高精度下仍能超过30FPS的检测器。

论文地址:https://arxiv.org/pdf/2207.02696.pdf

源码地址:https://github.com/WongKinYiu/yolov7

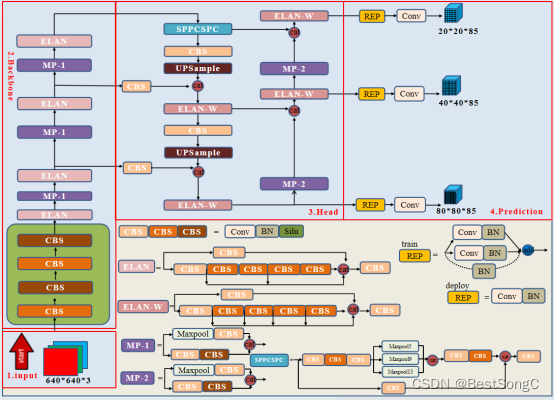

YOLOv7模型结构

YOLOv7模型的整体结构如下,与YOLOv5相似,整体可分为Input、Backbone、Neck、Head以及Prediction模块。

本节介绍YOLOv7相关模型里的新的模块:

(1)ReOrg:位于yolov7-w6.yaml文件中

这个模块其实是对输入的信息进行切片操作,与YOLOv2算法的PassThrough层以及YOLOv5(v5.0版本)的Focus操作类似,对输入图层尽可能保持原信息并进行下采样。(这部分代码具体位于models/common.py文件的48行)

(2)多路卷积模块

这部分主要还是大量复用1×1的point Conv和3×3的standard Conv,每个Conv 的输出不仅作为下一个Conv的输入,还会和所有其他的Conv输出进行Concat相连操作,类似于DenseNet里面的操作

(3)SPPCSPC模块

这是一种利用金字塔池化操作和CSP结构得到的模块,依旧包含了大量支路;总的输入会被分成三段进入不同的分支,最中间的分支其实就是金字塔池化操作,左侧分支类似于 depthwise Conv,但是请注意中间的3×3卷积并未进行分组,依旧是标准卷积,右侧则为一个point onv,最后将所有分支输出的信息流进行 concat向量(这部分代码具体位于models/common.py文件的262行)。

(4)RepConv模块

RepVGG是一种基于VGG网络设计的多分支模型,在训练过程中可以通过多分支提升性能,推理可以通过结构重新参数化转换为具有3×3卷积和ReLU的连续直筒型VGG类网络,实现推理速度的加快(这部分代码具体位于models/common.py文件的463行)。

(5)E-ELAN模块

这部分是对多路卷积模块的补充,在更大更深的模型才会用到(yolov7-e6e模型中)。在大多数关于设计高效网络的论文中,主要考虑的因素是参数量、计算量和计算密度。但从内存访存的角度出发出发,还可以分析输入 / 输出信道比、架构的分支数和元素级操作对网络推理速度的影响(shufflenet 论文提出)。在执行模型缩放时还需考虑激活函数,即更多地考虑卷积层输出张量中的元素数量。在大规模 ELAN 中,无论梯度路径长度和计算模块数量如何,都达到了稳定的状态。但如果更多计算模块被无限地堆叠,这种稳定状态可能会被破坏,参数利用率也会降低。作者进一步提出E-ELAN,采用 expand、shuffle、merge cardinality 结构,实现在不破坏原始梯度路径的情况下,提高网络的学习能力(具体在 cfg/training/yolov7-e6e.yaml可看到拆散成单独算子的结构配置)

YOLOv7损失函数

YOLOv7整体和YOLOv5保持一致,分为坐标损失、目标置信度损失(GT就是训练阶段的普通IoU)和分类损失三部分。其中目标置信度损失和分类损失采用BCEWithLogitsLoss(带log的二值交叉熵损失),坐标损失采用CIoU损失。详细参见utils/loss.py 里面的 ComputeLossOTA函数。

IoU_Loss:主要考虑检测框和目标框重叠面积。

GIoU_Loss:在IoU的基础上,解决边界框不重合时的问题。

DIoU_Loss:在IoU和GIoU的基础上,考虑边界框中心点距离的信息。

CIoU_Loss:在DIoU的基础上,考虑边界框宽高比的尺度信息。

系统环境搭建

(1)打开Anaconda Prompt(如果电脑没有anaconda软件,需下载安装)

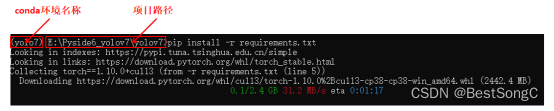

(2)创建yolo7的conda环境(conda create -n yolo7 python=3.8),并激活yolo7环境(conda activate yolo7)

(3)进入到项目目录(本文演示目录为:E:Pyside6_yolov7yolov7)

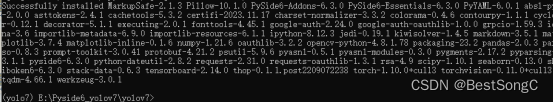

(4)安装环境依赖包:pip install –r requirements.txt

(5)在环境中输入:python base_camera,py 来打开系统界面

系统界面及功能展示

在本博文中将展示设计的软件界面,整体界面设计简洁大方,提供了直观的操作体验,主要功能包括以下几个方面: