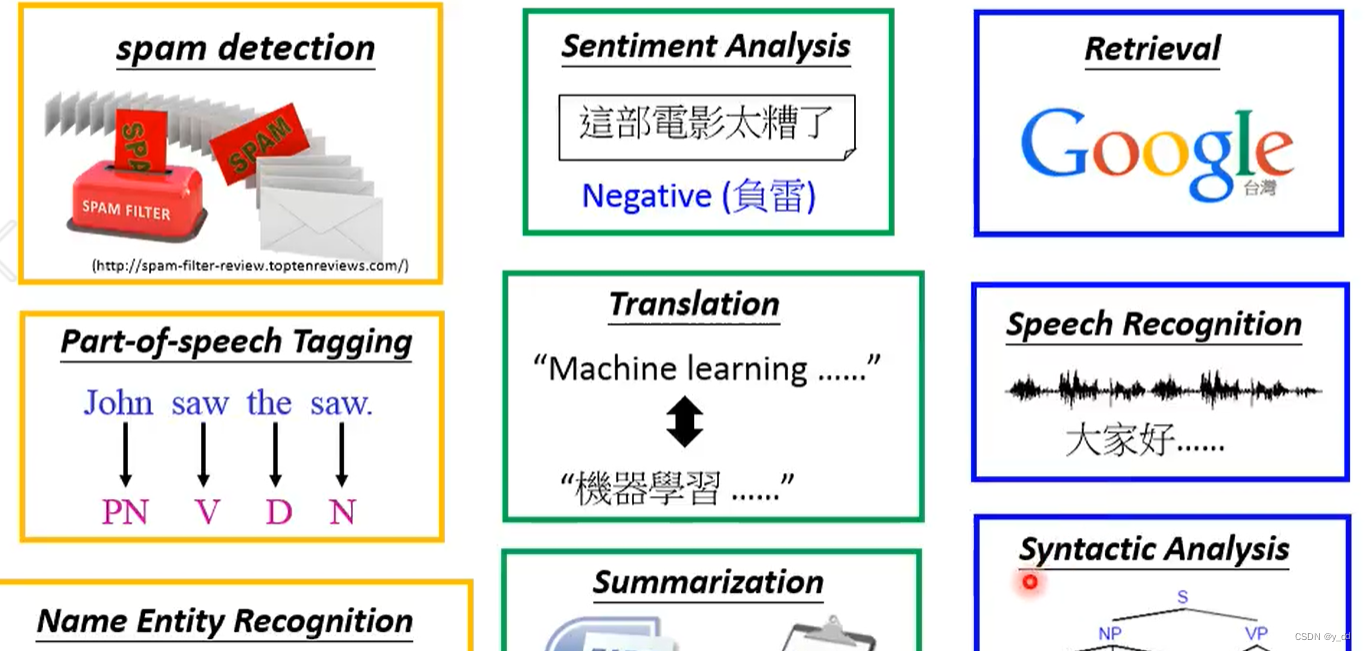

自然语言处理

神经机器翻译模型经历了哪些主要的结构变化?分别解决了哪些问题?

神经机器翻译(Neural Machine Translation, NMT)是一种使用深度学习技术来实现自动翻译的方法。自从提出以来,NMT模型经历了几个重要的发展阶段,每个阶段的模型结构变化都旨在解决特定的问题或提高翻译质量。以下是主要的结构变化及其解决的问题:

常见的词嵌入模型有哪些?它们有什么联系和区别?

这些模型之间的主要区别在于它们处理词义和上下文关系的方式。Word2Vec和GloVe更侧重于词汇的分布式表示,FastText增加了对词内结构的考虑,而BERT则提供了深层次的、双向的上下文词义表示。

这些模型之间的主要联系是它们都旨在将词汇转换为密集的向量表示,这些向量能够捕捉词汇的语义信息,从而在多种NLP任务中提供支持。随着模型结构从浅层到深层的演变,词嵌入技术在捕捉词义的精度和深度上取得了显著进步。

神经机器翻译如何解决未登录词的翻译问题?

未登录词(Out-Of-Vocabulary,OOV)问题是指在机器翻译过程中,翻译模型遇到了训练数据中未出现过的词汇,因此无法为其找到合适的翻译。在神经机器翻译(NMT)中,采取了几种策略来解决或减轻这个问题:

通过这些策略,神经机器翻译系统能够更有效地处理未登录词问题,从而提高翻译的准确性和流畅性。

如何对文本中词的位置信息进行编码?

在自然语言处理(NLP)和特别是在神经网络模型中,对文本中词的位置信息进行编码是一个重要的任务,因为这些信息对于理解词在句子中的作用和关系至关重要。以下是几种常用的位置编码方法:

这些方法各有优势,可以根据特定的任务和模型架构来选择。位置编码的引入显著提升了模型处理序列数据的能力,尤其是在语义理解和生成任务中。

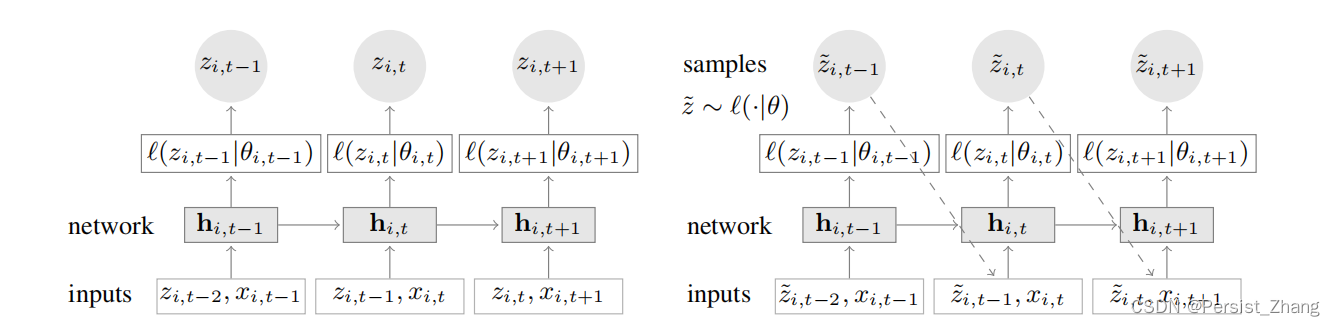

语言模型的任务形势是什么?语言模型如何帮助提升其他自然语言处理任务的效果?

训练神经机器翻译模型时有哪些解决双语语料不足的方法?

在给文本段落编码时如何结合问题信息?这样做有什么好处?

如何使用卷积神经网络和循环神经网络解决问答系统中的长距离语境依赖问题?Transformer相比以上方法有何改进?

对话系统中哪些问题可以使用强化学习来解决?

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。