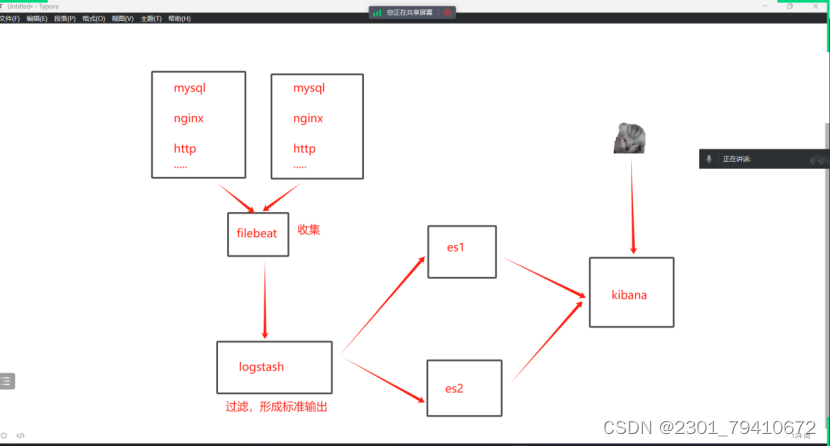

本文介绍: Filebeat是一个轻量级的日志手机工具,所使用的系统资源比logstash部署和启动时使用的资源要小得多。Logstash性能上的优化: logstash启动是在jvm虚拟机当中其中,启动一次至少500M内存。Filebeat可以在非java环境使用,他可以代理logstash在非java环境上收集日志。logstash的工作线程,默认值就是cpu数,4 2 8 4 给一半即可2核,2个。Logstash可以使用任意端口,只要没有被占用都可以使用,推荐1024之后使用。./filebeat 运行文件。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。