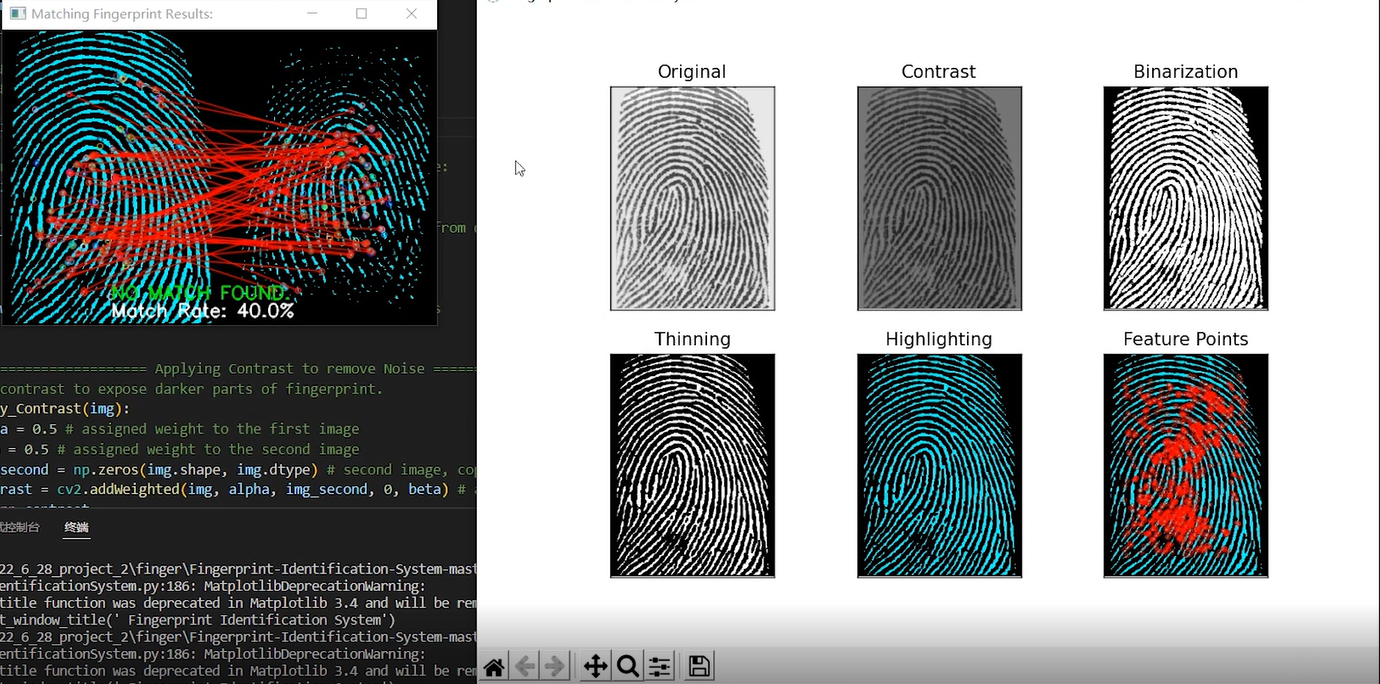

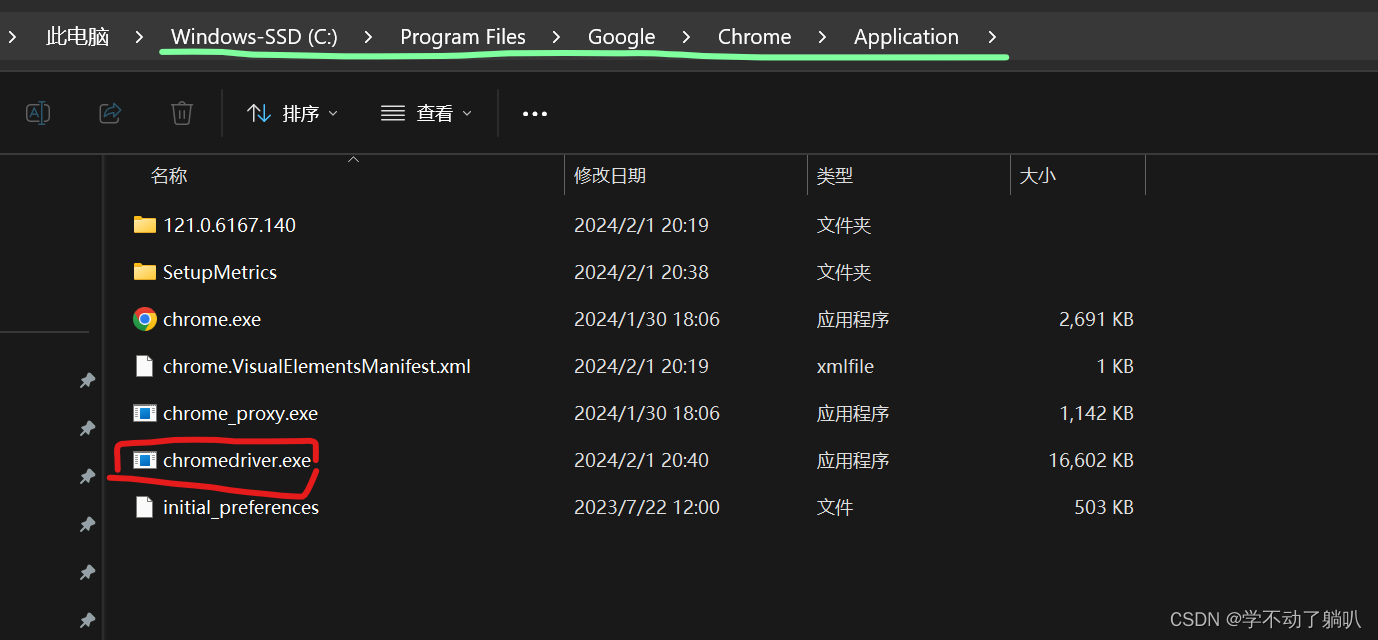

本文介绍: 模拟多样化的浏览器指纹信息,包括操作系统、浏览器版本、内核版本、User-Agent、字体、浏览器语言、分辨率、时区与地理位置、媒体设备指纹、Canvas指纹、WebGL等。通过为每个配置随机配置指纹信息,这样在每次请求中使用不同的浏览器指纹信息,爬虫可以模拟多个独立用户的行为,降低被封禁的风险。然而,传统爬虫往往面临被目标网站封禁的风险。自动化功能,只需用户编写需要的脚本,即可自动化执行作业,比如自动浏览、自动点击、自动抓取、自动填写表单等指令,这样即可快速的完成爬虫的步骤,准确且高效。

网络爬虫在信息搜集、数据挖掘等领域起着重要作用。然而,传统爬虫往往面临被目标网站封禁的风险。本文将介绍指纹浏览器对网络爬虫的作用,以及指纹浏览器如何帮助爬虫降低封禁风险。

网络爬虫面临的挑战

网络爬虫是一种自动化程序,用于从互联网上抓取信息。然而,许多网站采取了反爬虫措施来保护其内容和资源,如IP封禁、验证码、Cookie限制等。这使得爬虫面临着被目标网站封禁的风险,限制了数据的获取和应用。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。