一、稳定训练

常见方法如下:

· 将乘法变为加法

· ResNet:当层数较多时,会加入一些加法进去

· LSTM:如果时序序列较长时,把一些对时序的乘法做加法

· 归一化

· 梯度归一化:把梯度转化为一个均值0、方差1这样的数,从而避免梯度的数值过大或过小

· 梯度裁剪:如果梯度大于一个阈值,就强行拉回来减到一个范围里

二、合理初始化操作

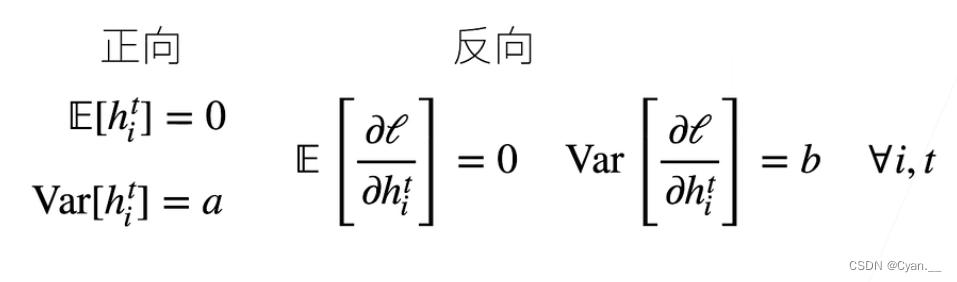

目标:让每层的方差都为一个常数

· 让输出和梯度的均值和方差都保持一致,那么就可以在每层的传递之间保持,不会出现问题

权重初始化

目标:将参数和权重初始化在一个合理的区间值里,防止参数变化过大或过小导致出现问题

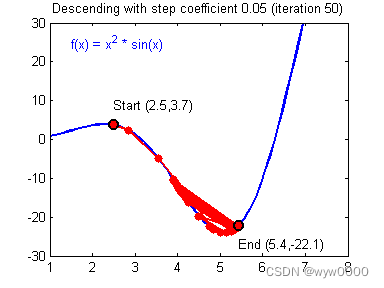

· 当训练开始时,数值更易出现不稳定的问题

· 随机初始的参数可能离最优解很远,更新幅度较陡,损失函数会很大,从而导致梯度较大

· 假设不定义初始化方法,框架将使用默认初始化,即采用正态分布初始化权重值

· 这种初始化方法对小型神经网络较为有效,但当网络较深时,这种初始化方法往往表现较差

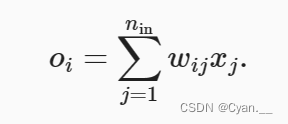

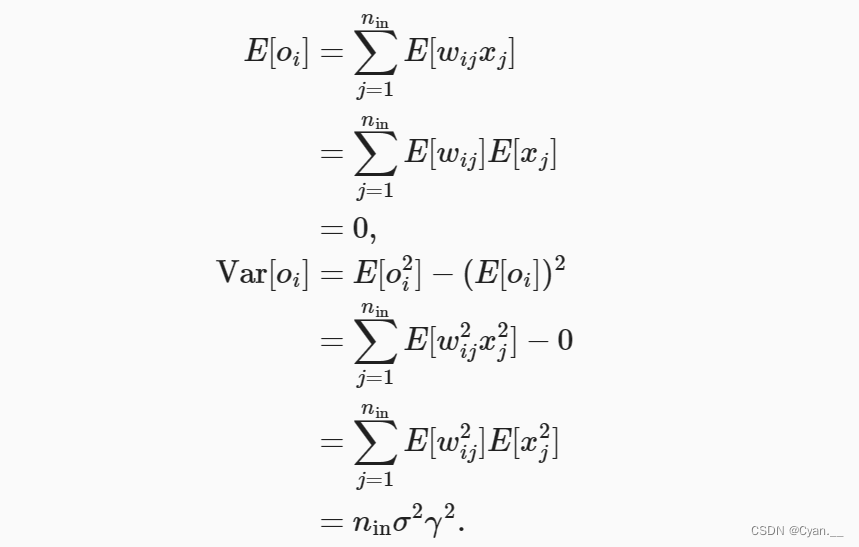

某些没有非线性的全连接层输出(例如,隐藏变量) 的尺度分布:

权重 都是从同一分布中独立抽取的

· 假设该分布具有均值 0 和方差 (不一定是标准正态分布,只需均值方差存在)

· 假设层 的输入也具有均值 0 和方差

,且独立于

并彼此独立

现在考虑反向传播过程,我们面临着类似的问题,尽管梯度是从更靠近输出的层传播的。

· 除非 ,否则梯度的方差可能会增大。其中

是该层输出的数量。

· 然而,我们不可能同时满足 和

这两个条件。

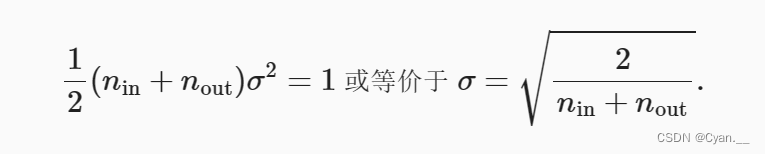

但我们只需满足:

通常,Xavier初始化从均值为 0,方差 的高斯分布中采样权重。

· 任何梯度的方差不受输出数量的影响。

原文地址:https://blog.csdn.net/Yukiice/article/details/134521050

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_3636.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!