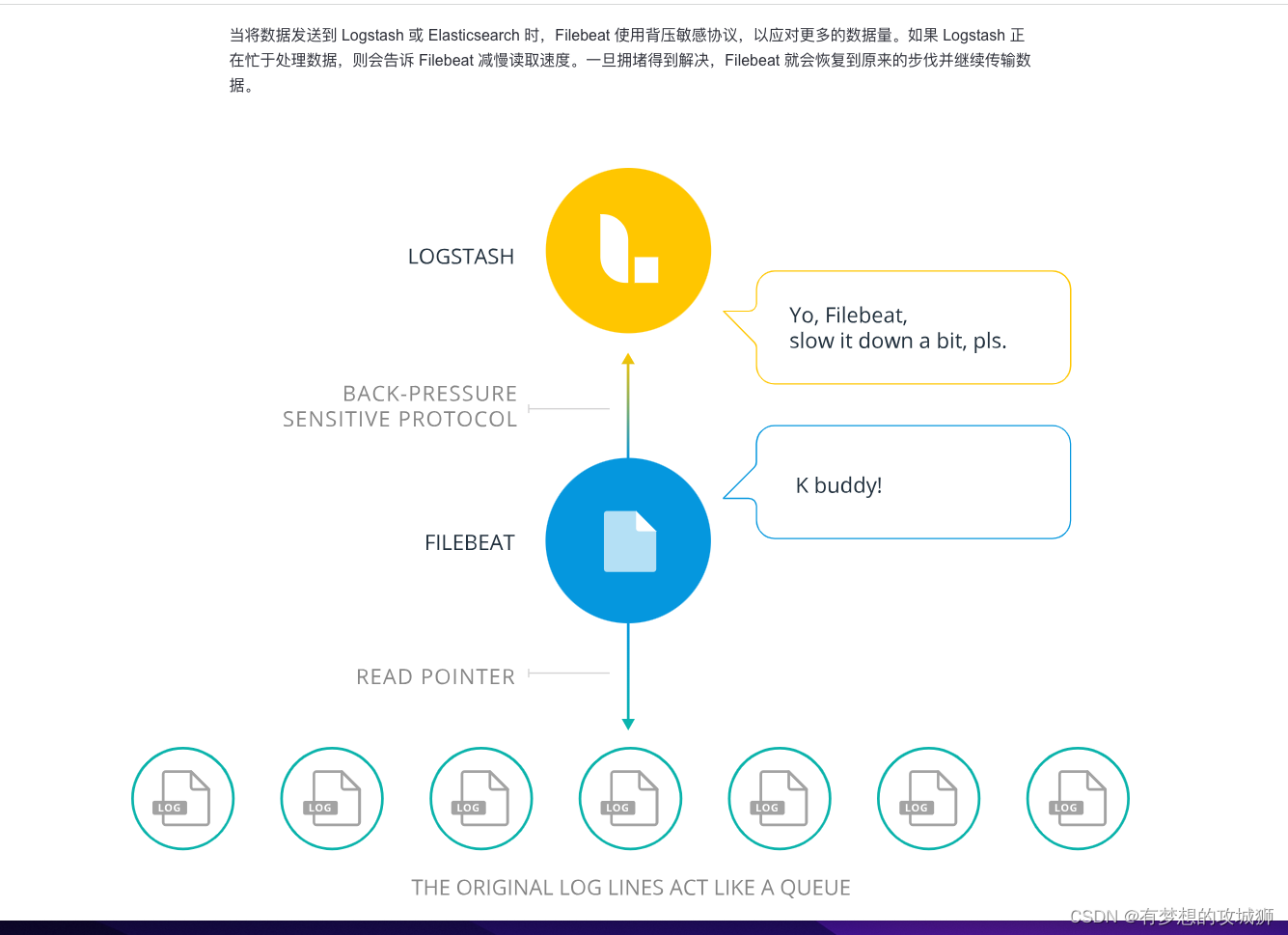

本文介绍: Filebeat是使用Golang实现的轻量型日志采集器,也是Elasticsearch stack的一员。它可以作为一个agent安装在各个节点上,根据配置读取对应位置的日志,并上报到相应的地方去。Filebeat的可靠性很强,可以保证日志至少一次的上报,同时也考虑了日志搜集中的各类问题,例如日志断点续读、文件名更改、日志截断等。Filebeat并不依赖于Elasticsearch,可以单独存在。

Filebeat介绍

Filebeat是使用Golang实现的轻量型日志采集器,也是Elasticsearch stack的一员。它可以作为一个agent安装在各个节点上,根据配置读取对应位置的日志,并上报到相应的地方去。Filebeat的可靠性很强,可以保证日志至少一次的上报,同时也考虑了日志搜集中的各类问题,例如日志断点续读、文件名更改、日志截断等。Filebeat并不依赖于Elasticsearch,可以单独存在。其内置了常用的Output组件,例如Kafka、Elasticsearch、Redis等,也可以输出到console和file,我们还可以利用现有的Output组件将日志进行上报。

主要优势

主要功能

配置日志的解析

Kibana中设置日志解析

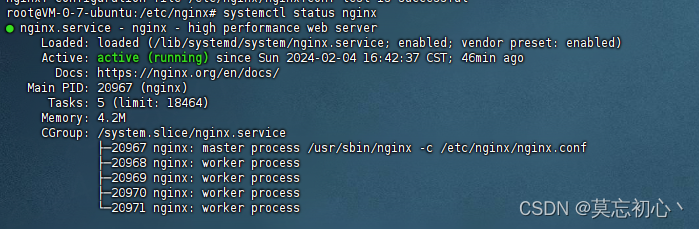

安装步骤

安装Filebeat

安装监控

通过prometheus监控

Filebeat和Logstash的主要区别

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。