本文介绍: 这句话的意思是:期望张量的后端处理是在cpu上,但是实际是在cuda上。排查代码发现,数据还在cpu上,但是模型已经转到cuda上,所以可以通过把数据转到cuda上解决。解决方法:减小batch size的大小或减小图片的尺寸。

1、

这句话的意思是:期望张量的后端处理是在cpu上,但是实际是在cuda上。排查代码发现,数据还在cpu上,但是模型已经转到cuda上,所以可以通过把数据转到cuda上解决。

这句话的意思是:期望张量的后端处理是在cpu上,但是实际是在cuda上。排查代码发现,数据还在cpu上,但是模型已经转到cuda上,所以可以通过把数据转到cuda上解决。

解决代码:

2、

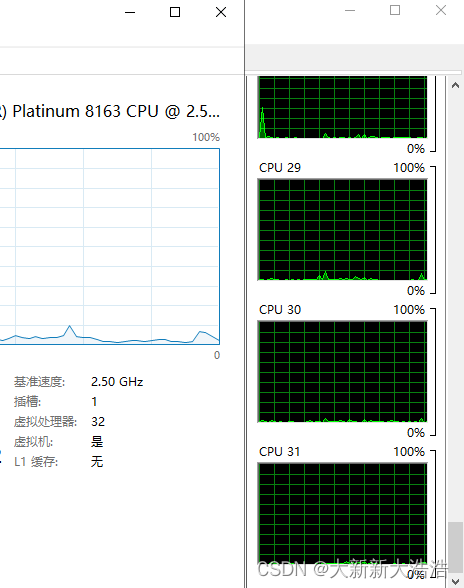

解决方法:减小batch size的大小或减小图片的尺寸

解决方法:减小batch size的大小或减小图片的尺寸

3、

原因:因为只有一块GPU,以上代码是多GPU使用的

解决方法:改为以下单GPU代码:

4、 原始代码:

原始代码:

原因:模型参数文件是保存在了state_dict中,所以后面要加

解决方法:改成以下代码:

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

原始的

原始的