0.前提

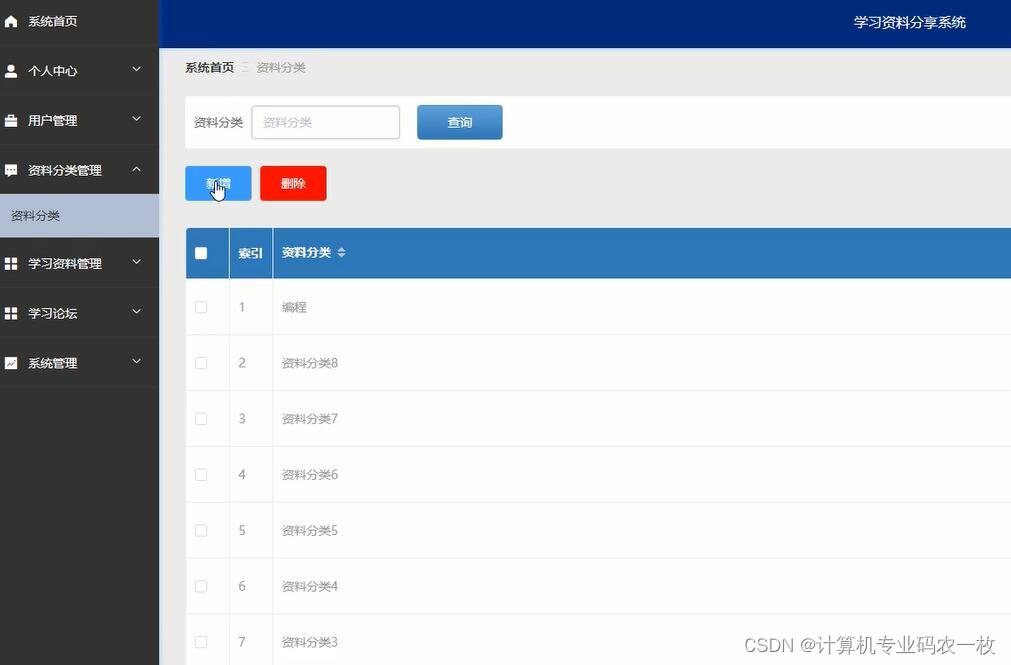

深度学习(Deep Learing)是机器学习(Machine Learning)领域中的一个新的研究方向,在如今的时代研究深度学习的大模型是十分热门的。我不知道有多少人有关注到最近openai的事件啊,说个比较让我惊讶的事情,一直在支持我做一些实验的老师今年在ICCV的A区发文章,直接给我看傻了,平常经常看到老师骑着电车在学校里面跑。既然深度学习是机器学习的一个子集,那想要入门深度学习,学习机器学习那就很有必要了。这篇文章也是为了在未来更好的解剖了解我的智能小车。

1.机器学习的类型

1.监督学习

·监督学习是指利用有标签数据进行训练从而得到预测模型的学习任务。换句话说就是训练的数据有标签,输入数据x预测y。

·监督学习算法主要分两类:离散的,那就是分类算法(classification);连续的,那就是回归算法(regression)。

1.分类算法

2.回归算法

2.无监督学习

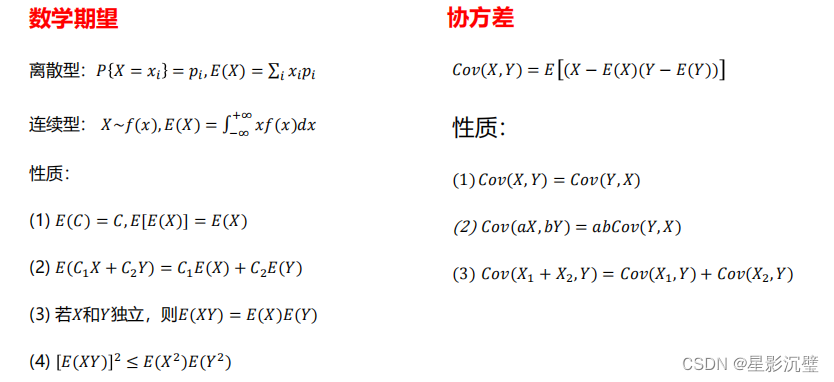

1.聚类

2.关联

3.强化学习

2.机器学习的主要概念

1.模型

1.概率模型

2.非概率模型

线性模型

非线性模型

2.损失函数

3.优化算法

4.模型评估

3.机器学习的学习基础

1.高数-导数

2.高数-泰勒公式

3.线代-行列式

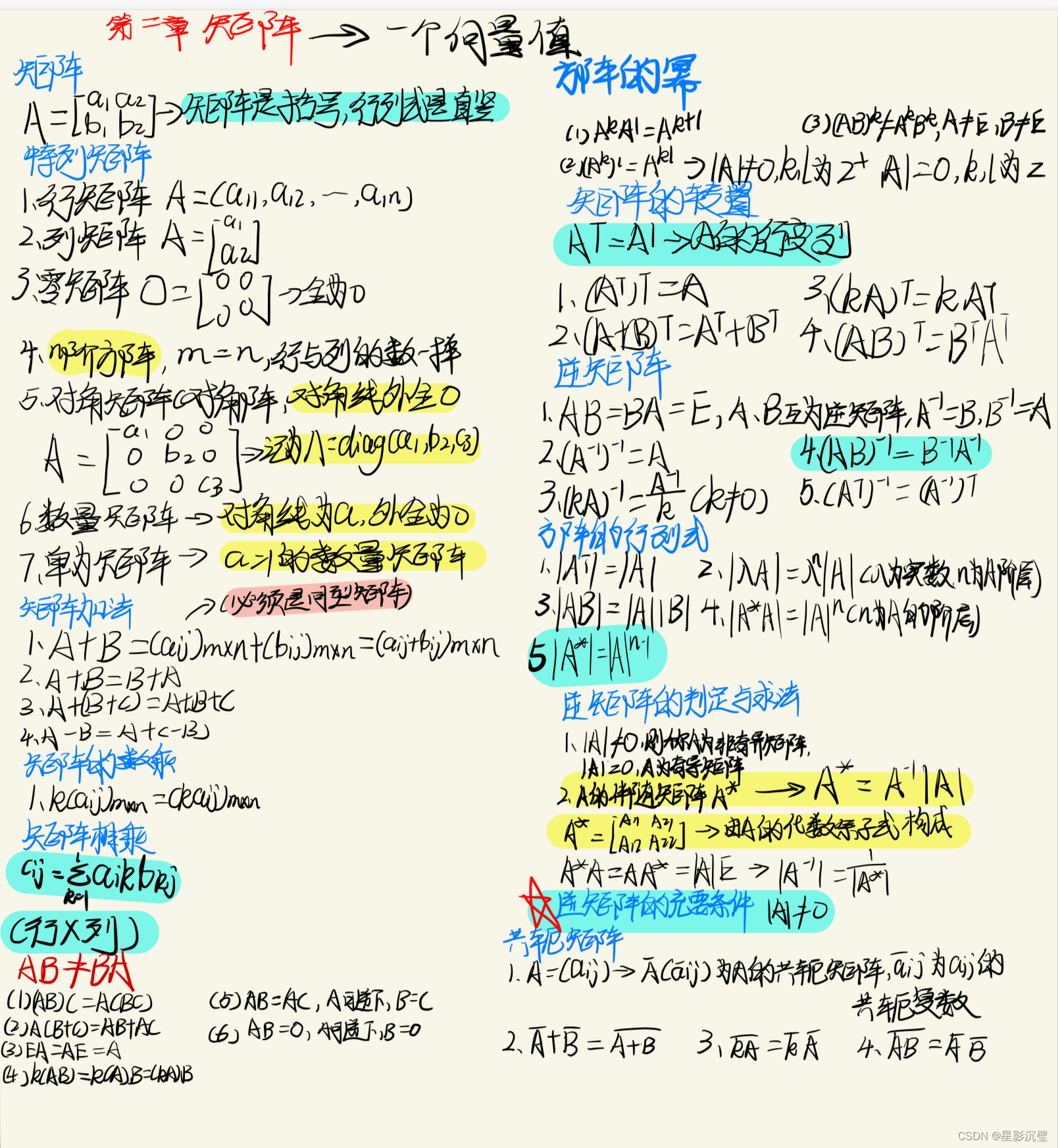

4.线代-矩阵

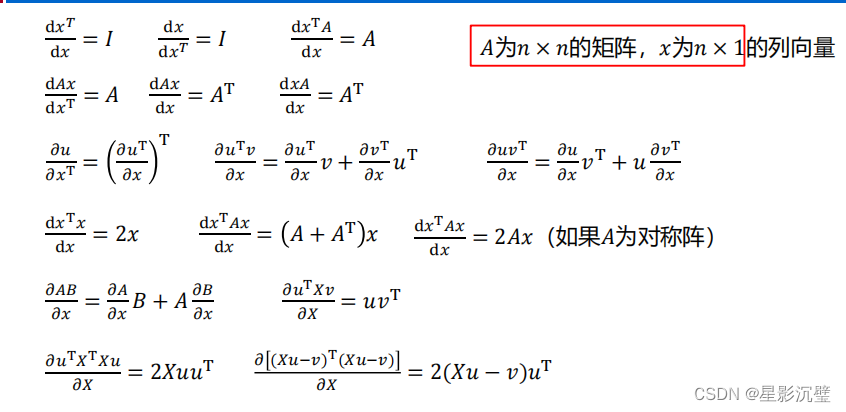

5.线代-求导

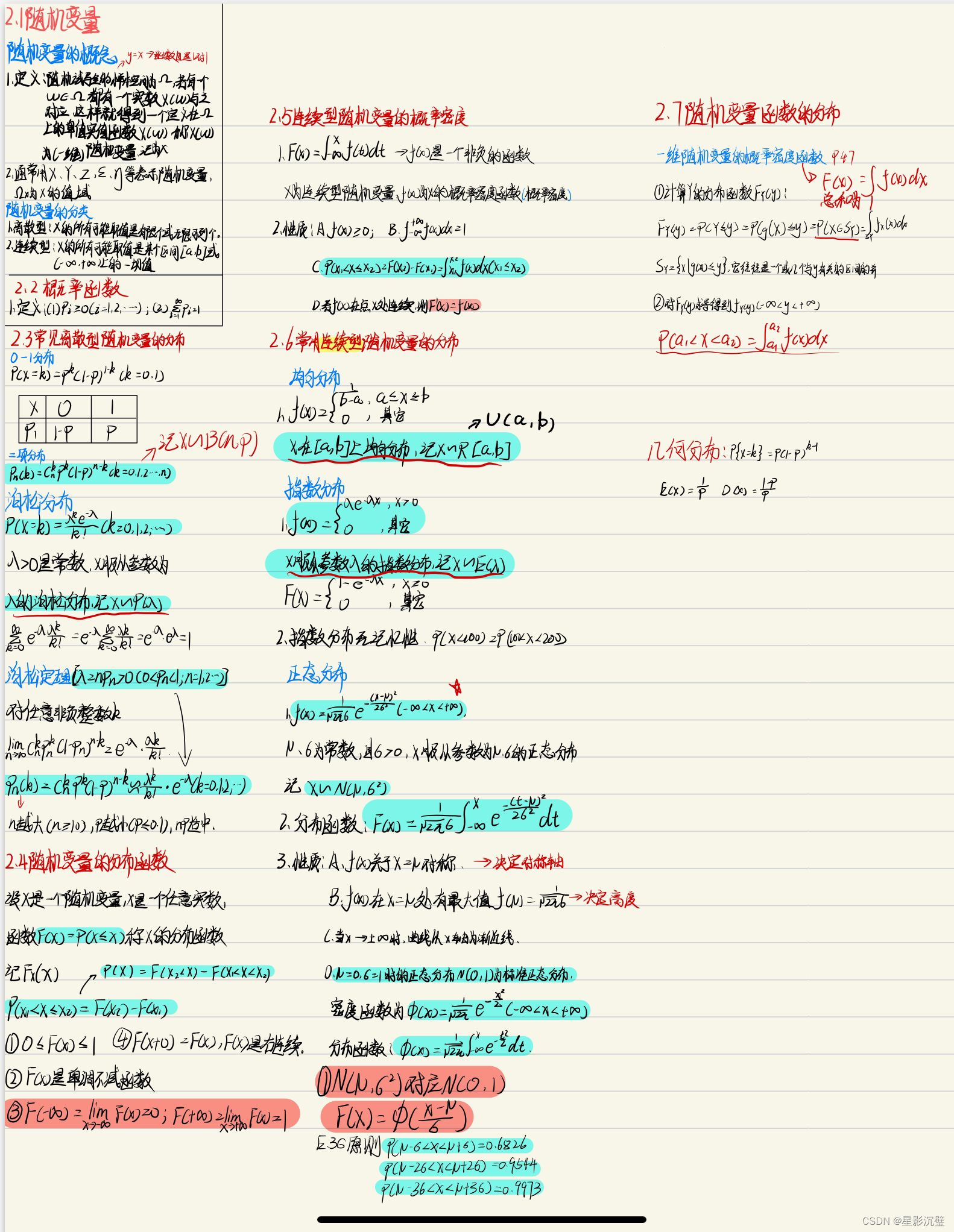

6.概率与数理 –随机事件与概率

7.概率与数理-古典概型与几何概型

8.概率与数理-条件概率

9.概率与数理-全概率

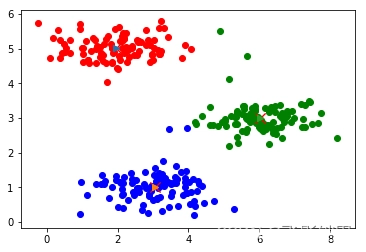

10.概率与数理-各种分布

10.概率与数理-期望与方差

4.总结

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。