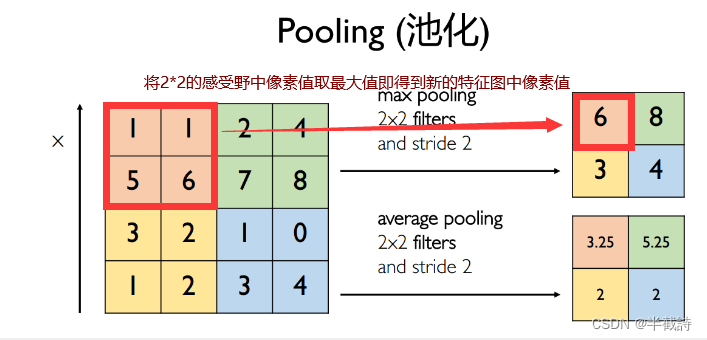

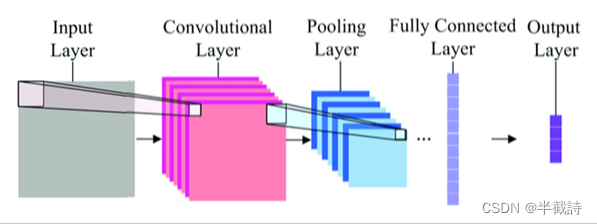

本文介绍: 输出尺寸为W2*H2*K(W2*H2为池化特征图的尺寸,在全局池化中对应为1*1),池化层可用于进一步筛选特征,可以有效减少后续网络所需要的参数量,在降低数据维度的同时防止过拟合。:输出尺寸为(W2*H2*K)*C (W2*H2*K是将多维特征压缩到一维之后的大小,C对应图像类别个数),将多维特征展平为二维特征,通常低维度对应任务的学习目标。:输出尺寸为W1*H1*K(K表示卷积层中卷积核(滤波器)的个数),用于实现参数共享,局部连接,利用平移不变性从全局特征图提取局部特征。

1.卷积神经网络基本结构结构

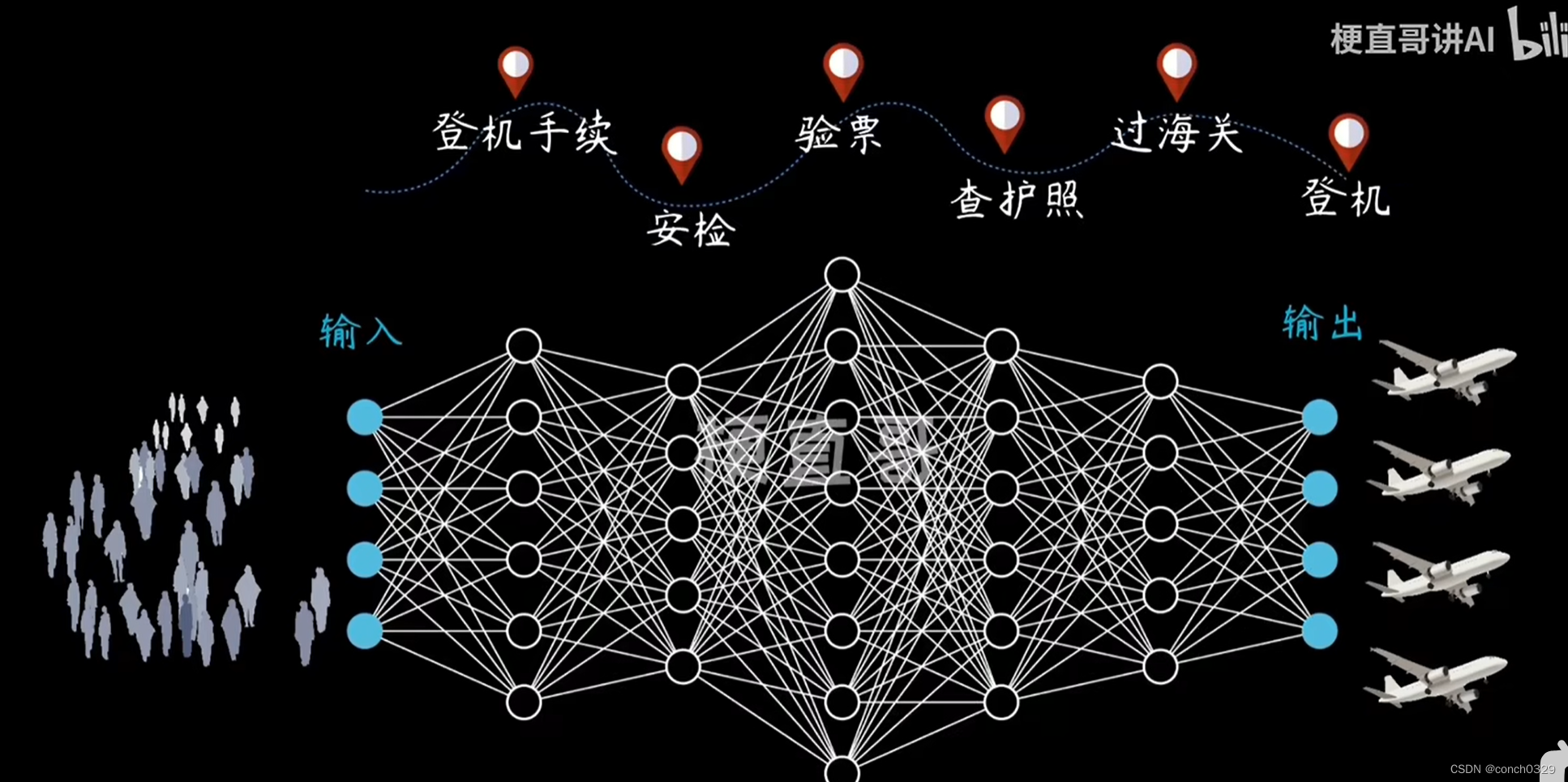

卷积神经网络采用类似于动物视觉皮层组织中的神经元的连接模式,是一类包含卷积神经网络且具有深度结构的前馈神经网络。其基本结构如图2-1所示,大致包括:卷积层,激活函数,池化层,全连接层,输出层。

输入层:输出尺寸为W1*H1*3(3表示RGB图像对应通道),其作用是作为卷积神经网络的原始输入,一般是原始或预处理后的像素矩阵。

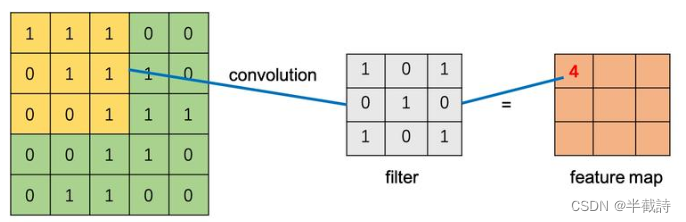

卷积层:输出尺寸为W1*H1*K(K表示卷积层中卷积核(滤波器)的个数),用于实现参数共享,局部连接,利用平移不变性从全局特征图提取局部特征。

2.专业名词

3.卷积操作

4.池化操作

5.全连接操作

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。