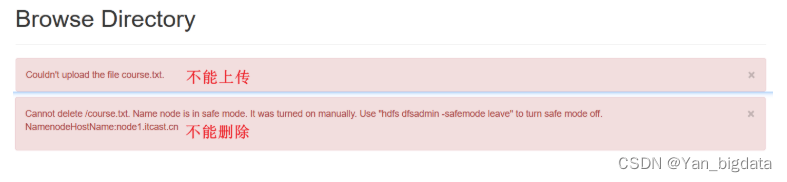

1.安全模式

在安全模式下 不允许HDFS客户端进行任何修改文件的操作,包括上传文件,删除文件等操作。

2.归档机制

3.垃圾桶机制

在虚拟机中需要手动设置才能使用垃圾桶回收: 把删除的内容放到: /user/root/.Trash/Current/

先关闭服务: 在 node1 中执行 stop-all.sh 新版本不关闭服务也没有问题

再修改文件 core–site.xml : 进入/export/server/hadoop-3.3.0/etc/hadoop目录下进行修改

其中,1440 表示 1440分钟,也就是 24小时,一天的时间。

设置了垃圾桶机制好处: 文件不会立刻消失,可以去垃圾桶里把文件恢复,继续使用

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。