本文介绍: 本文提出了一种新颖的顺序建模方法,可以在不使用任何语言数据的情况下学习大型视觉模型(LVM)。为此,我们定义了一种通用格式,“视觉句子”,在这种格式中,我们可以表示原始图像和视频以及带注释的数据源,如语义分割和深度重建,而无需超出像素之外的元知识。一旦这种广泛的视觉数据(包含(420)亿个tokens)被表示为序列,就可以训练模型以最小化下一个token预测的交叉熵损失。通过在不同规模的模型架构和数据多样性上进行训练,我们提供了实证证据,表明我们的模型可以有效地扩展。

一、论文速读

1.1 摘要

1.2 论文概要总结

相关工作

主要贡献

论文主要方法

实验数据

未来研究方向

二、论文精度

2.1 论文试图解决什么问题?

2.2 论文中提到的解决方案之关键是什么?

1. 视觉句子的定义和使用

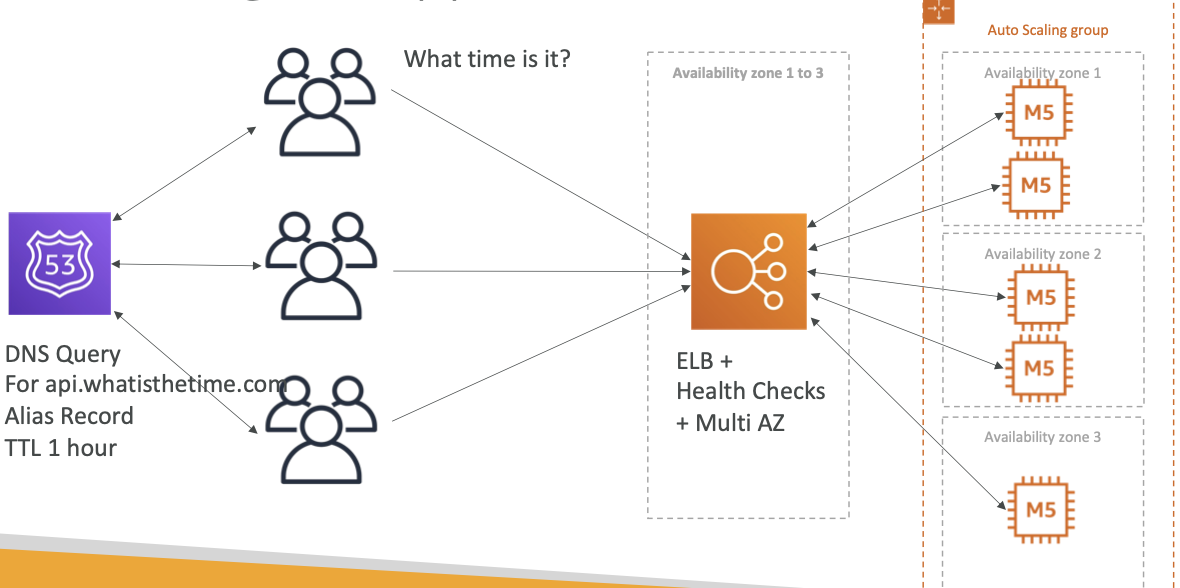

2. 大型Transformer架构的应用

3. 大规模和多样化的训练数据集

4. 顺序建模和自回归训练方法

5. 多任务和上下文学习能力

2.3 论文提出的架构和损失函数是什么?

架构

损失函数

2.4 用于定量评估的数据集是什么?代码有没有开源?

UVDv1数据集细节

2.5 这篇论文到底有什么贡献?

1. 提出新的大型视觉模型(LVM)概念

2. 开发了一种无需语言数据的视觉学习方法

3. 创新的“视觉句子”概念

4. 构建了一个大规模和多样化的视觉数据集

5. 展示了模型在多种视觉任务上的应用能力

6. 提供了关于模型扩展性的见解

2.6 下一步呢?有什么工作可以继续深入?

1. 模型扩展和优化

2. 数据集的扩展和多样化

3. 新任务和应用领域

4. 跨模态学习

5. 解释性和可视化

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。