本文介绍: 数据质量管理和数据清洗是确保数据质量的关键步骤。通过数据质量评估和度量,可以发现数据质量问题并制定相应的清洗策略。Java作为一种强大的编程语言,在数据质量管理和数据清洗中具有广泛的应用。通过合理的实践和最佳方法,可以确保数据质量的持续改进和业务决策的准确性。

引言

在当今数字化时代,数据质量管理和数据清洗对于企业和组织来说变得至关重要。随着大数据的快速增长和数据驱动决策的普及,确保数据的准确性、一致性和完整性成为保证业务成功的关键因素。本文将探讨数据质量管理和数据清洗的概念、目标以及其在Java开发中的应用。

1. 数据质量管理的概念和目标

数据质量管理是指通过一系列策略、流程和技术,确保数据在整个生命周期中始终保持高质量的管理过程。其目标包括确保数据的准确性、一致性、完整性、可靠性和及时性。数据质量管理的关键是通过数据质量评估和度量来发现和解决数据质量问题。

1.1 数据质量管理的概念

数据质量管理是一种系统化的方法,旨在确保数据具备高质量的特征和属性,以满足业务需求和决策支持的要求。它涉及到数据的收集、存储、处理和分发等各个环节,并通过一系列策略、流程和技术手段来管理数据的质量。

1.2 数据质量管理的目标

1.3 数据质量管理的重要性

1.4 数据质量管理的实践

2. 数据质量评估和度量指标

2.1 准确性(Accuracy)

2.2 完整性(Completeness)

2.3 一致性(Consistency)

2.4 唯一性(Uniqueness)

2.5 及时性(Timeliness)

2.6 合规性(Compliance)

3. 数据清洗的过程和技术

3.1 数据去重(Data Deduplication)

3.2 数据转换(Data Transformation)

3.3 数据填充(Data Imputation)

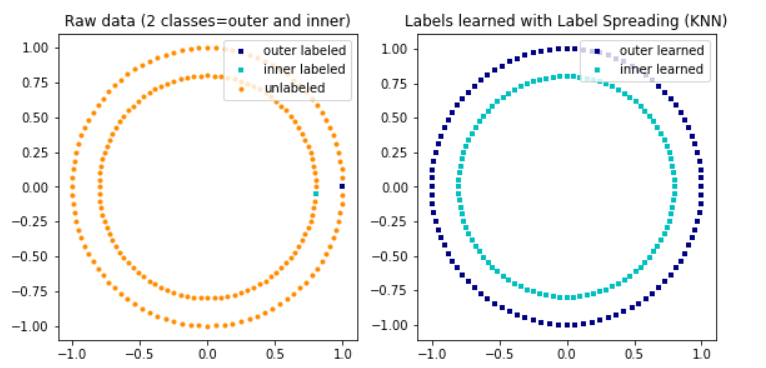

3.4 异常检测和纠正(Outlier Detection and Correction)

3.5 数据验证和规范化(Data Validation and Standardization)

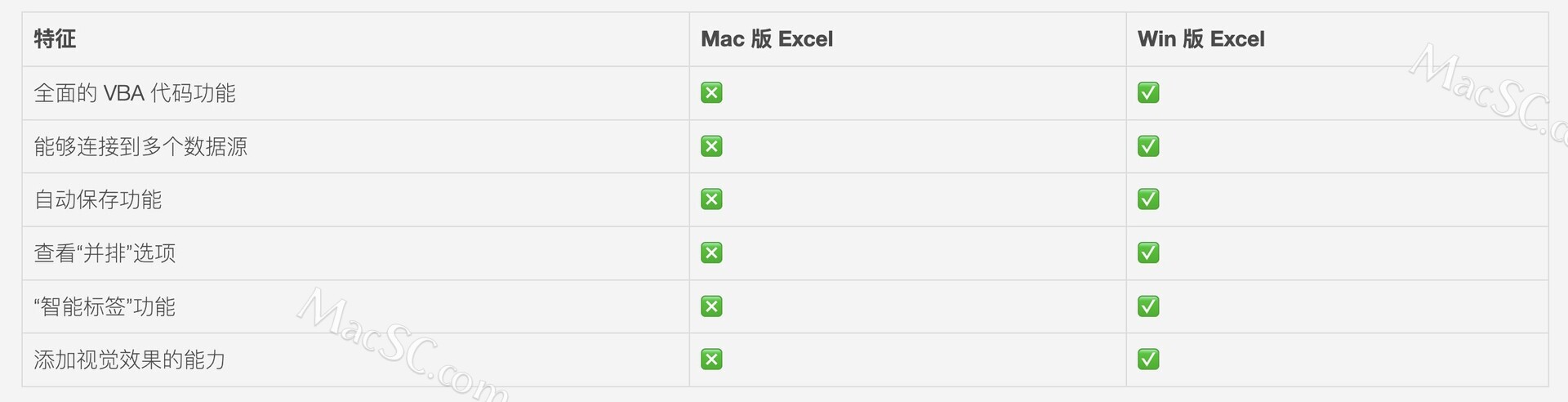

4. Java在数据质量管理和数据清洗中的应用

4.1. 数据质量评估和度量的Java实现

4.2. 数据清洗的算法和逻辑的Java实现

5. 数据质量管理和数据清洗的最佳实践

5.1. 数据质量监控和异常检测

5.2. 数据质量规则和约束

5.3. 数据质量管道和自动化流程

总结

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。