本文全面探讨了ROC曲线(Receiver Operating Characteristic Curve)的重要性和应用,从其历史背景、数学基础到Python实现以及关键评价指标。文章旨在提供一个深刻而全面的视角,以帮助您更好地理解和应用ROC曲线在模型评估中的作用。

一、引言

机器学习和数据科学在解决复杂问题时,经常需要评估模型的性能。其中,ROC(Receiver Operating Characteristic)曲线是一种非常有用的工具,被广泛应用于分类问题中。该工具不仅在医学检测、信号处理中有着悠久的历史,而且在近年来的机器学习应用中也显得尤为关键。

ROC曲线简介

ROC曲线用于展示在不同的分类阈值下,模型的真正类率(True Positive Rate, TPR)和假正类率(False Positive Rate, FPR)之间的关系。通常与ROC曲线一起使用的还有AUC(Area Under the Curve)值,用以量化ROC曲线下的面积,进而给出一个关于模型性能的单一指标。

二、ROC曲线的历史背景

了解ROC曲线的历史背景不仅能增加我们对这一工具的尊重,还能更好地理解它在多个领域内的应用价值。因此,本节将探讨ROC曲线从最早的军事应用到现代医学和机器学习领域的发展过程。

二战雷达信号检测

ROC曲线最初的应用场景是二战中的雷达信号检测。当时,盟军需要一种方法来评估雷达系统的性能——特别是系统在检测敌方飞机时的灵敏度和误报率。这就催生了ROC曲线的诞生,它用于度量在不同阈值下,雷达正确检测到目标(True Positive)和误报(False Positive)的情况。

在医学和机器学习中的应用

随着时间的推移,ROC曲线的应用场景逐渐扩大。在20世纪50年代和60年代,该曲线开始在心理测量学和医学诊断中得到应用。比如,在癌症筛查中,ROC曲线用于评估在不同诊断阈值下,筛查测试对正例和负例的分类能力。

进入21世纪,随着机器学习和数据科学的崛起,ROC曲线在这些领域内也获得了广泛应用。它成为了评估分类模型(如支持向量机、随机森林和神经网络等)性能的标准方法之一。

横跨多个领域的普及

值得注意的是,ROC曲线如今已经不仅局限于专业的科研和工程领域。许多业界工具和库(如Scikit–learn、TensorFlow和PyTorch等)都内置了绘制ROC曲线的功能,使得即使是不具备专门训练的个人和小团队也能轻易地应用这一工具。

三、数学基础

在深入研究ROC曲线的实际应用之前,我们首先需要理解其背后的数学基础。ROC曲线是建立在一系列重要的统计量之上的,包括True Positive Rate(TPR)和False Positive Rate(FPR)。本节将详细介绍这些概念和计算方法,并提供相关Python代码示例。

True Positive Rate(TPR)与False Positive Rate(FPR)

True Positive Rate(TPR)

TPR也称为灵敏度(Sensitivity)或召回率(Recall),是真正例(True Positive,TP)占所有实际正例(实际正例 = TP + FN)的比例。

False Positive Rate(FPR)

FPR也称为1-特异性(1-Specificity),是假正例(False Positive,FP)占所有实际负例(实际负例 = FP + TN)的比例。

计算方法

-

使用分类模型对数据进行预测。

-

计算TP, FP, TN, FN的数量。

代码示例:计算TPR和FPR

下面是一个用Python和PyTorch来计算TPR和FPR的简单代码示例。

import torch

# 真实标签和模型预测概率

y_true = torch.tensor([0, 1, 1, 0, 1])

y_pred = torch.tensor([0.2, 0.8, 0.6, 0.1, 0.9])

# 设置阈值

threshold = 0.5

# 根据阈值进行分类

y_pred_class = (y_pred > threshold).float()

# 计算TP, FP, TN, FN

TP = torch.sum((y_true == 1) & (y_pred_class == 1)).float()

FP = torch.sum((y_true == 0) & (y_pred_class == 1)).float()

TN = torch.sum((y_true == 0) & (y_pred_class == 0)).float()

FN = torch.sum((y_true == 1) & (y_pred_class == 0)).float()

# 计算TPR和FPR

TPR = TP / (TP + FN)

FPR = FP / (FP + TN)

print(f'TPR = {TPR}, FPR = {FPR}')输出:

TPR = 0.6667, FPR = 0.0四、Python绘制ROC曲线

理论基础明确之后,我们将转向如何用Python实现ROC曲线的绘制。这里,我们会使用Python的数据科学库matplotlib和深度学习框架PyTorch进行展示。为了简化问题,我们将使用一个简单的二分类问题作为例子。

导入所需库

import matplotlib.pyplot as plt

import torch

from sklearn.metrics import roc_curve, auc准备数据

为了本教程的目的,我们假设已经有了模型预测的概率值和相应的真实标签。

# 真实标签

y_true = torch.tensor([0, 1, 1, 0, 1, 0, 1])

# 模型预测的概率值

y_score = torch.tensor([0.1, 0.9, 0.8, 0.2, 0.7, 0.05, 0.95])计算ROC曲线坐标点

利用sklearn.metrics库的roc_curve函数可以方便地计算出ROC曲线的各个点。

fpr, tpr, thresholds = roc_curve(y_true, y_score)计算AUC值

AUC(Area Under Curve)是ROC曲线下方的面积,通常用于量化模型的整体性能。

roc_auc = auc(fpr, tpr)绘制ROC曲线

使用matplotlib进行绘图。

plt.figure()

lw = 2 # 线宽

plt.plot(fpr, tpr, color='darkorange', lw=lw, label=f'ROC curve (area = {roc_auc:.2f})')

plt.plot([0, 1], [0, 1], color='navy', lw=lw, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic Example')

plt.legend(loc='lower right')

plt.show()这段代码会生成一个标准的ROC曲线,其中橙色的线表示ROC曲线,虚线表示随机分类器的性能。

完整代码示例

import matplotlib.pyplot as plt

import torch

from sklearn.metrics import roc_curve, auc

# 真实标签和模型预测的概率

y_true = torch.tensor([0, 1, 1, 0, 1, 0, 1])

y_score = torch.tensor([0.1, 0.9, 0.8, 0.2, 0.7, 0.05, 0.95])

# 计算ROC曲线的各个点

fpr, tpr, thresholds = roc_curve(y_true, y_score)

# 计算AUC值

roc_auc = auc(fpr, tpr)

# 绘制ROC曲线

plt.figure()

lw = 2

plt.plot(fpr, tpr, color='darkorange', lw=lw, label=f'ROC curve (area = {roc_auc:.2f})')

plt.plot([0, 1], [0, 1], color='navy', lw=lw, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic Example')

plt.legend(loc='lower right')

plt.show()五、ROC曲线的评价指标

在深入了解如何绘制ROC曲线后,接下来我们将专注于如何使用ROC曲线来评价模型的性能。ROC曲线本身提供了一个直观的方式来观察模型在不同阈值下的性能,但除此之外,还有其他一些重要的评价指标。

AUC(Area Under Curve)

AUC是ROC曲线下的面积,范围在0到1之间。AUC值可以用于总体评价模型的分类性能。

-

AUC = 1,表示模型有完美的分类性能。

Youden’s Index

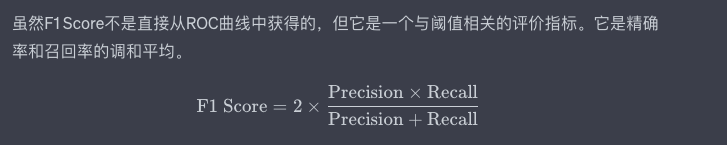

F1 Score

虽然F1 Score不是直接从ROC曲线中获得的,但它是一个与阈值相关的评价指标。它是精确率和召回率的调和平均。

代码示例:计算AUC和Youden’s Index

以下Python代码段使用sklearn.metrics库来计算AUC,并手动计算Youden’s Index。

from sklearn.metrics import roc_curve, auc

# 计算ROC曲线

fpr, tpr, thresholds = roc_curve(y_true, y_score)

# 计算AUC

roc_auc = auc(fpr, tpr)

print(f'AUC: {roc_auc}')

# 计算Youden's Index

youdens_index = tpr - fpr

best_threshold = thresholds[torch.argmax(torch.tensor(youdens_index))]

print(f"Best threshold according to Youden's Index: {best_threshold}")输出:

AUC: 0.94

Best threshold according to Youden's Index: 0.7六、总结

本文全面而深入地探讨了ROC曲线的各个方面,从其历史背景和数学基础到具体的Python实现以及相关的评价指标。通过这一流程,我们不仅能更加深刻地理解ROC曲线作为一个模型评估工具的价值,而且还可以洞察到其在现代机器学习和数据科学中的应用广度和深度。

技术洞见

虽然ROC曲线和AUC通常被视为分类模型性能的金标准,但值得注意的是,它们并不总是适用于所有场景。例如,在高度不平衡的数据集中,ROC曲线可能会给出过于乐观的性能评估。这是因为ROC曲线对假正例和假负例的处理是平等的,而在不平衡数据集中,这种平等处理可能会掩盖模型在较少类别上的性能不足。

另外,虽然ROC曲线能够很好地评价模型的整体性能,但它并不能提供关于模型在不同类别或群体间公平性的信息。在一些应用场景中,如医疗诊断和金融风险评估,模型的公平性是一个重要的考量因素。

展望未来

随着机器学习和人工智能技术的不断发展,评估模型性能的方法也在逐渐演化。在深度学习、自然语言处理和强化学习等领域,研究人员正在开发出更为复杂和精细的评价机制。因此,理解和掌握ROC曲线只是起点,未来还有更多富有挑战性和创新性的工作等待我们去探索。

通过本文,我们希望能够提供一个全面而深入的视角,以助您在复杂的模型评估问题中做出更加明智和准确的决策。正如数据科学中常说的,了解并正确使用各种评价指标,就是走向建模成功的关键第一步。

原文链接:https://www.cnblogs.com/xfuture/p/17874545.html

原文地址:https://blog.csdn.net/kfashfasf/article/details/134805869

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_47862.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!